Template

.

.

.

.

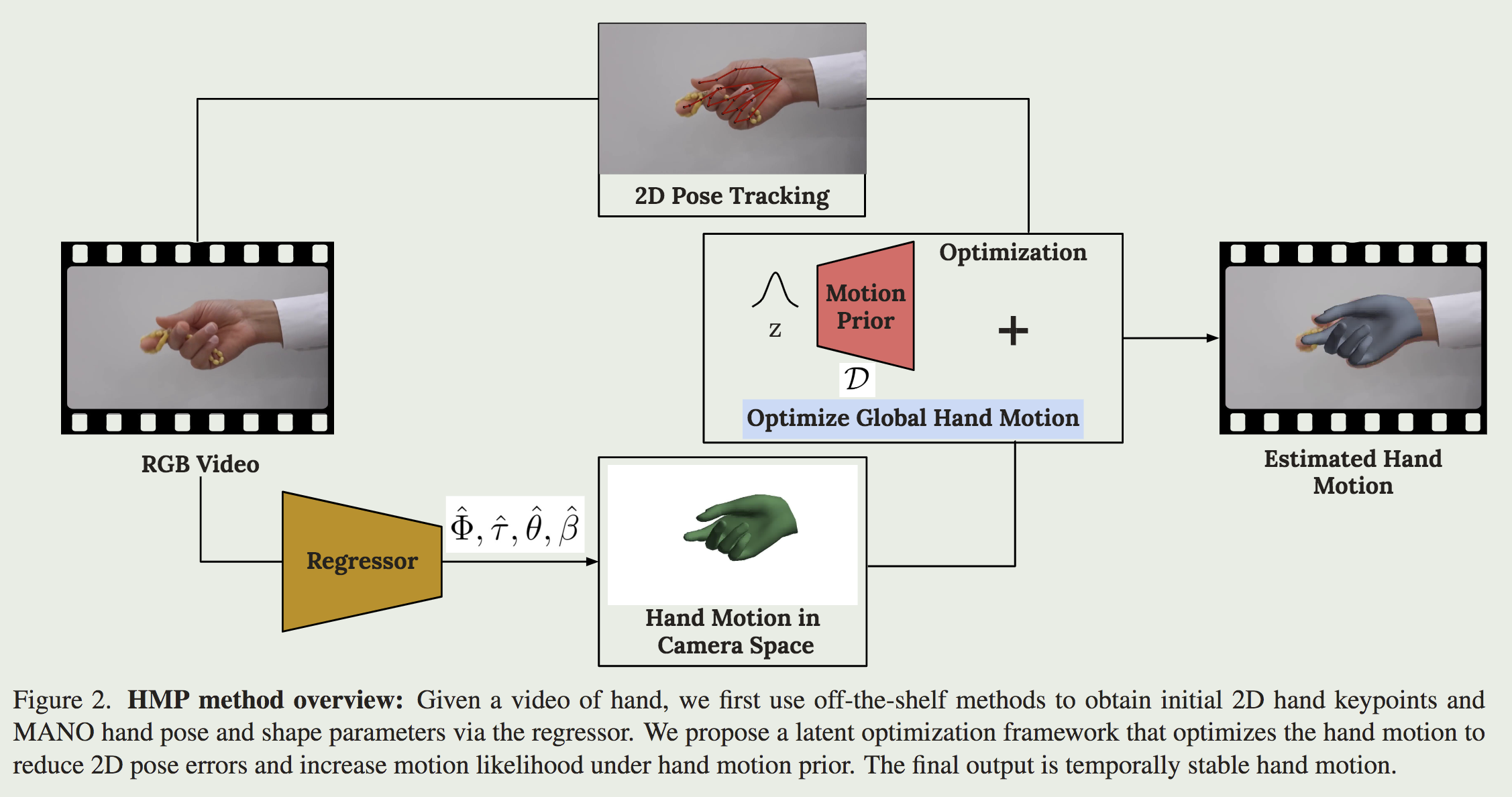

核心问题是什么?

目的

.

.

.

.

.

现有方法及局限性

.

.

.

.

.

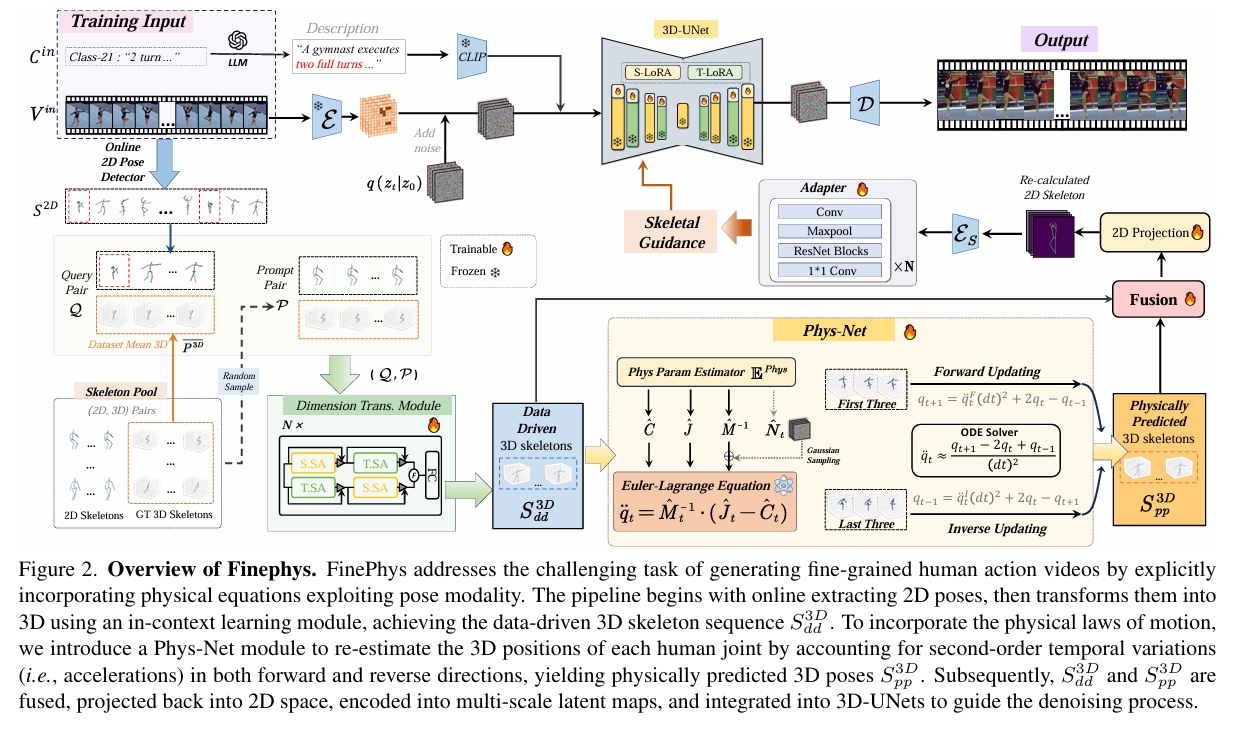

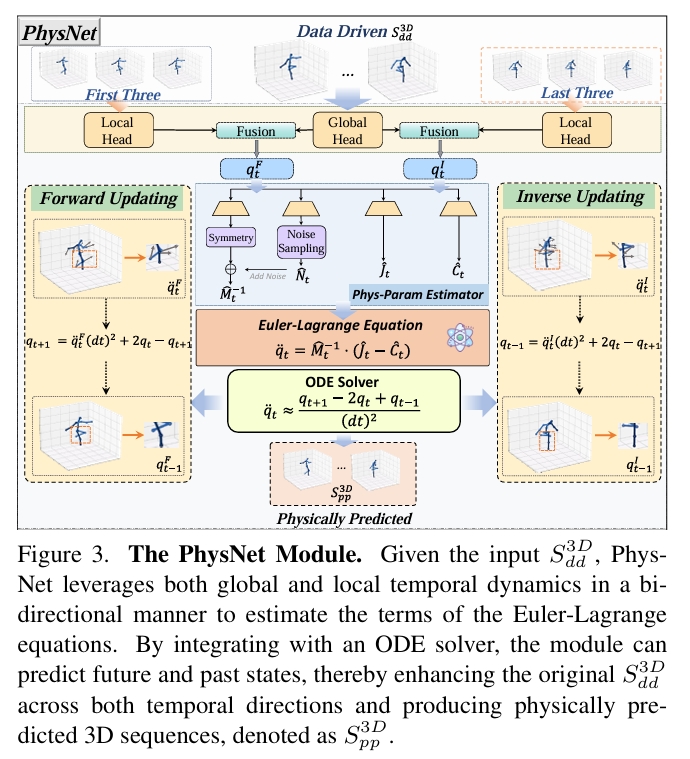

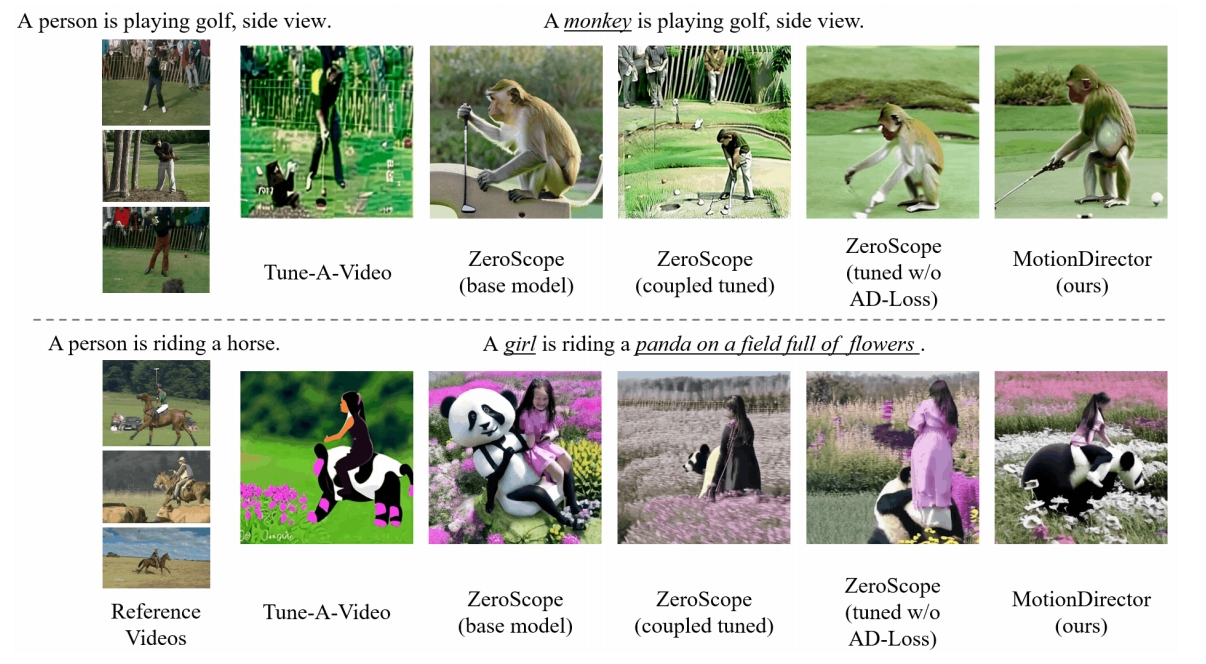

本文方法

.

.

.

.

.

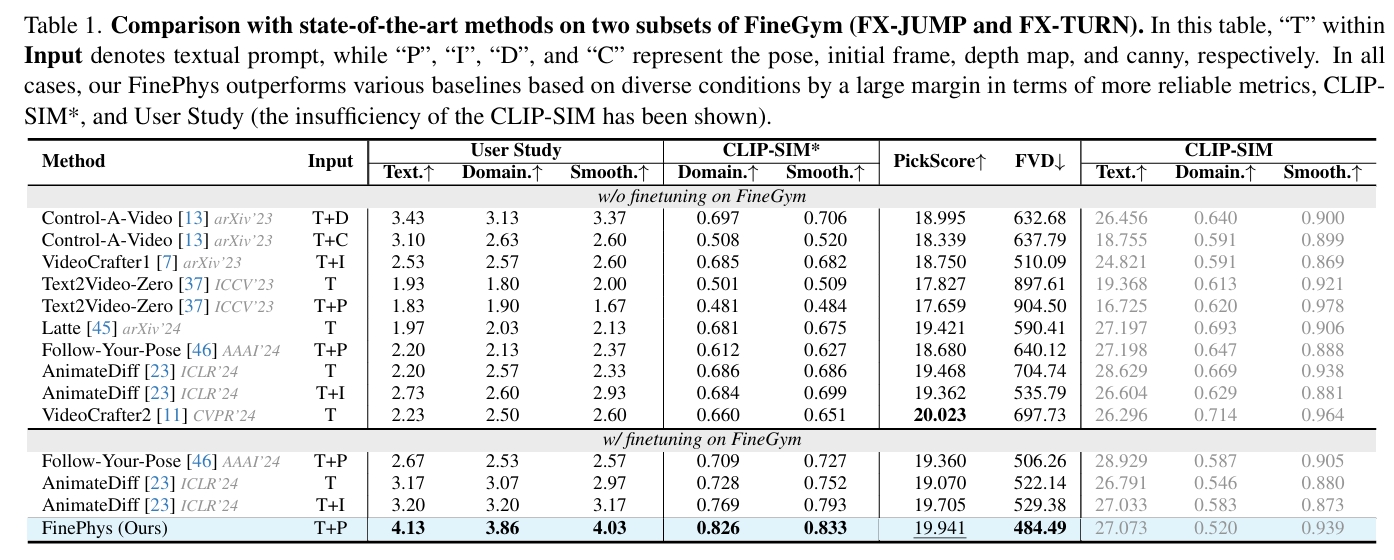

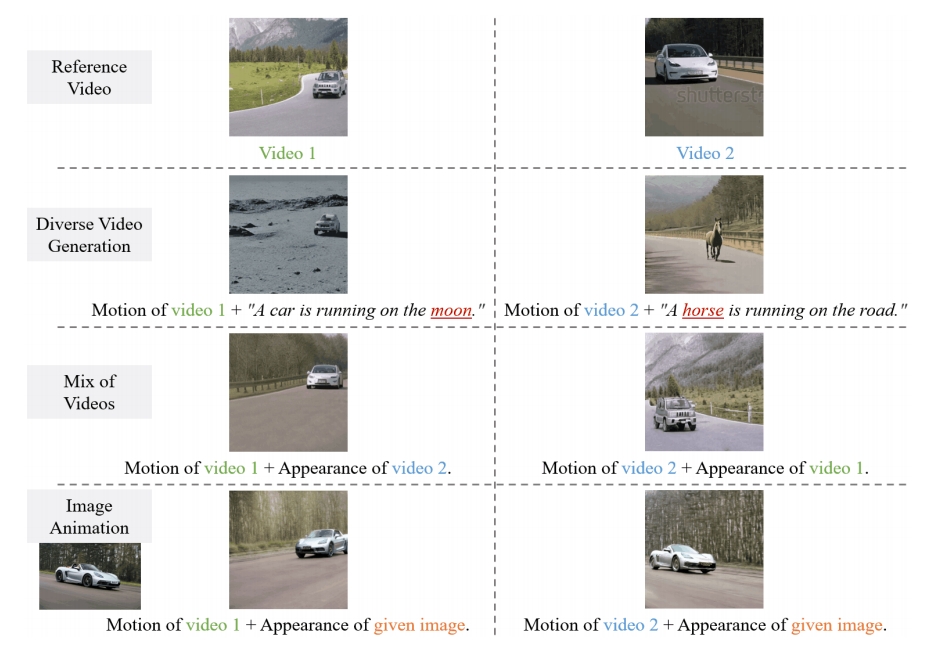

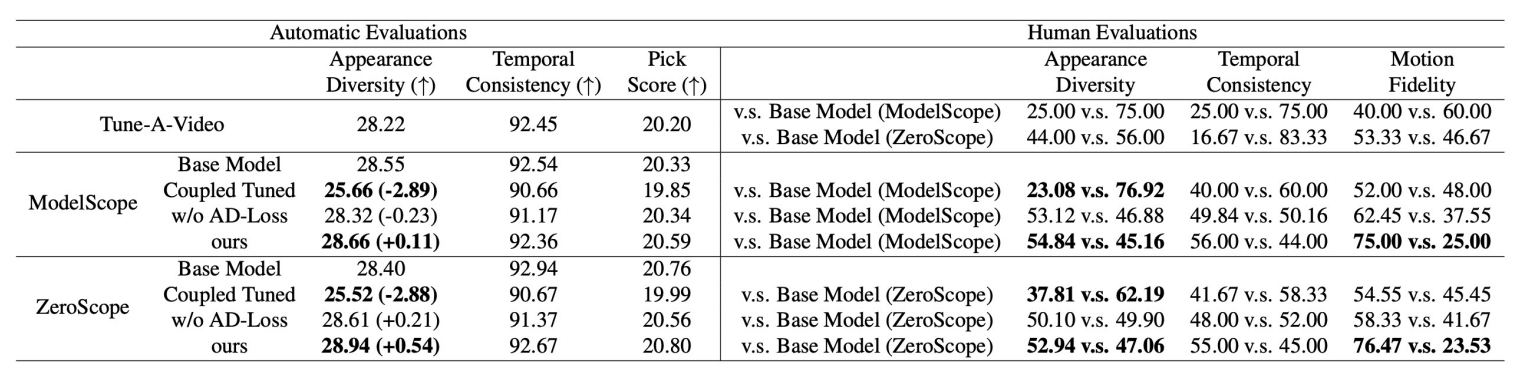

效果

.

.

.

.

.

核心贡献是什么?

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

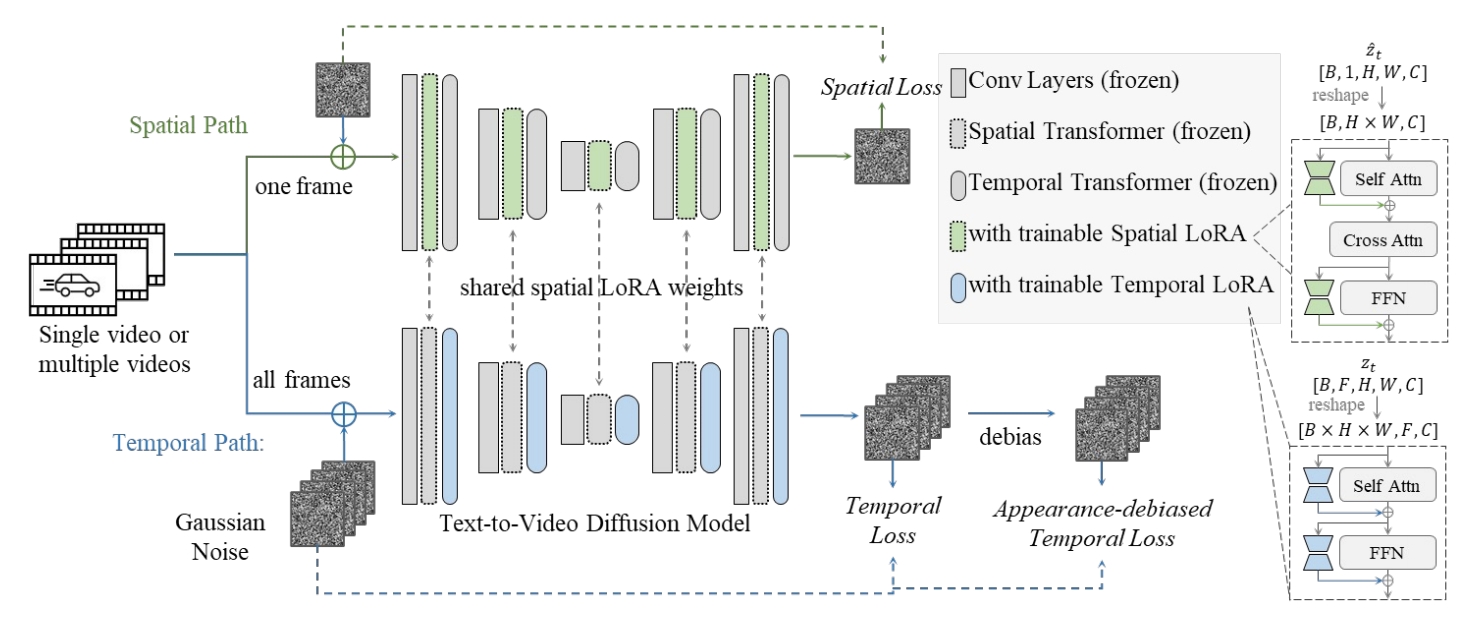

大致方法是什么?

.

.

.

. .

.

.

. .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

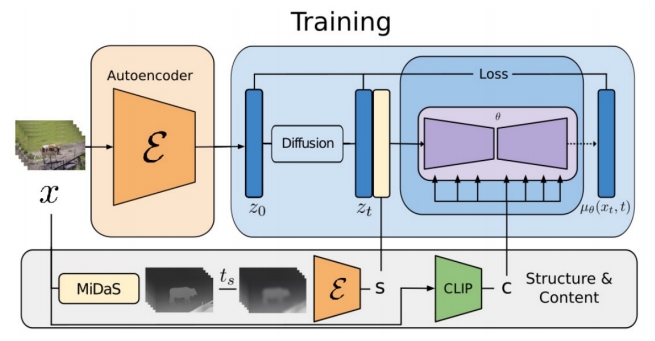

训练

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

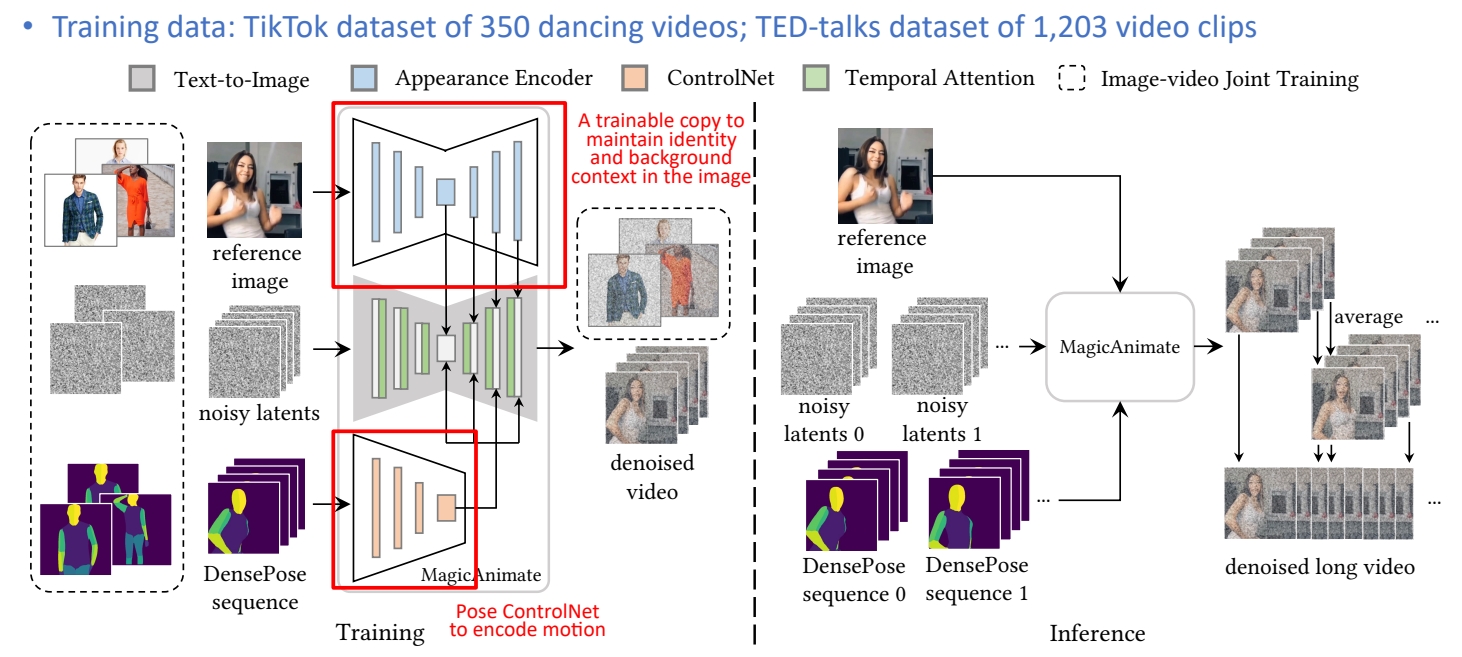

数据集

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

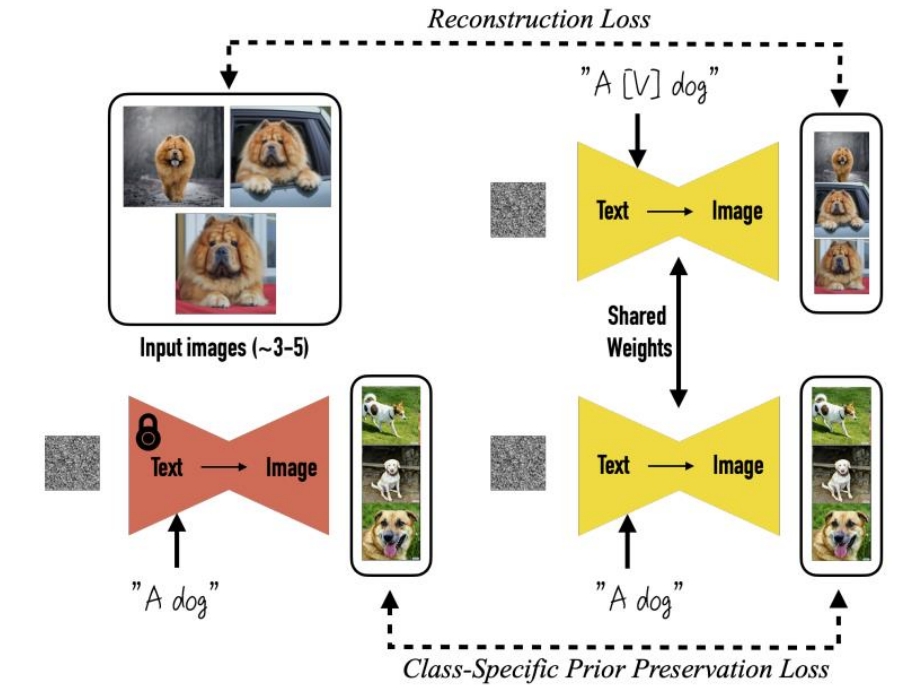

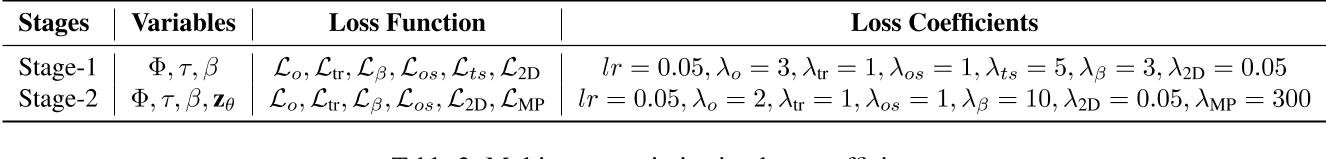

loss

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

训练策略

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

实验与结论

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

局限性

.

.

.

Loss

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

有效

.

.

.

.

.

.

.

.

.

.

.

.

局限性

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

启发

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

遗留问题

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

参考材料

Regional Time Stepping for SPH

摘要

针对经典弱可压缩光滑粒子流体动力学(WCSPH)方法,本文提出一种新颖高效的策略,可根据自由表面流的局部动力学特性,在空间上自适应分配计算量。该方法采用便捷且易于并行化的分块策略,为流体不同区域分配不同的时间步长并以不同速率求解,从而最大限度降低计算成本。实验表明,即便在高动态场景中,该方法的运算速度也较标准方法提升约一倍。

主要方法

适用于(WCSPH)的区域时间步长法(RTS),首个考虑不同区域的时间自适用算法。

怎样管理粒子的仿真步长?

将模拟域划分为虚拟网格,以分块为单位计算各区域的时间步长,而非以单个粒子为单位。

怎样计算一个粒子的适合的步长?

[TODO] 图1

- 所有粒子计算自身的速度和总受力;

- 粒子将自身属性传递至所属分块,分块根据内部粒子的最大受力和最大速度,计算该分块的最小时间步长;

- 各分块将计算得到的时间步长分配至内部所有粒子。

怎样算是合适的步长?

-

考虑时间步长内的突发加速度

[TODO] 公式2

- 根据粒子在一个时间步长内以当前速度移动的距离占其支撑半径的比例,为每个粒子分配对应的时间步长(本文新增)

[TODO] 公式3

判定条件 公式 作用 系数设置 CFL 条件(经典) Δtn≤csλvr 限制粒子在一个步长内的移动距离,避免穿透 λv≤0.4,cs为介质声速 加速度条件(经典) Δtn≤λfFmaxrm 应对突发加速度,保证动力学稳定性 λf≤0.25,Fmax为分块最大受力,m为粒子质量 速度分区条件(新增) rΔtnVmax≤αβn 根据粒子速度占支撑半径的比例分区,实现步长的空间梯度 α=0.4;β1=∞,βn=0.4(0.2)n−2(n≥2)

不同仿真步长对仿真过程有什么影响?

粒子新增了两个属性变量:

- 有效性(validity):表示粒子最新计算的属性的有效最小时间步长数(即距离其实际时间步长结束剩余的子步数);

- 计算标记(compute):布尔变量,标记粒子当前是否为活动粒子(即是否需要重新计算加速度,并在步长结束时校正位置和速度),当validity≤0 时,该标记为真。

若粒子为活动粒子,则计算其邻近粒子集合,并求解局部密度和受力;否则跳过上述计算步骤。在每次循环结束时,更新所有粒子的位置和速度,并按照塞尔纳的策略 [SRS03] 对活动粒子的速度和位置进行校正(算法 1 第 25-30 行)。

- 若粒子为活动粒子,则计算其邻近粒子集合,并求解局部密度和受力。否则跳过这一步。

- 所有粒子更新速度和位置。

- 若粒子为活动粒子,按照塞尔纳的策略对活动粒子的速度和位置进行校正

不同仿真步长之间的切换?

粒子可在其有效性属性过期前更改时间步长。这一设计使方法能在流体遭遇边界碰撞等突发加速度的情况下,保持模拟的稳定性。

不同仿真粒子表现的跳变?

定位不同时间步长区域的边界,并确定大时间步长一侧的分块集合,将该区域分配为其相邻区域的较小时间步长。

局限性

- 仅适用于WCSPH(弱可压缩 SPH),未拓展至更主流的不可压缩 SPH(如 PCISPH、IISPH);

- 分块的支撑半径固定为2s,未考虑自适应分块(如高动态区域细划分块,低动态区域粗划分块);

- 步长判定的系数为经验值,未给出自适应调优策略。

FreeGave: 3D Physics Learning from Dynamic Videos by Gaussian Velocity

本文旨在仅从多视角视频中建模 3D 场景的几何结构、外观及底层物理规律。现有方法通常通过将各种控制方程 (PDE) 作为物理信息神经网络 (PINN) 损失函数,或将物理模拟引入神经网络来实现。然而,这些方法往往难以学习边界处的复杂物理运动,或者需要依赖物体先验信息(如掩码或类型)。本文提出 FreeGave 方法,能够在无需任何物体先验信息的情况下学习复杂动态 3D 场景的物理规律。我们方法的关键在于引入一个物理编码 (physics code),并辅以一个精心设计的无散度模块 (divergence-free module),用于估计每个高斯点的速度场,而无需依赖低效的 PINN 损失函数。在三个公开数据集和一个新收集的高难度真实世界数据集上进行的大量实验表明,我们的方法在未来帧外推和运动分割任务上具有优越性能。尤为值得注意的是,我们对学习到的物理编码的研究表明,在训练中完全未使用任何人工标注的情况下,它们确实学习到了有意义的 3D 物理运动模式。我们的代码和数据可在 https://github.com/vLAR-group/FreeGave 获取。

Physics-informed neural networks: A deep learning framework for solving forward and inverse problems involving nonlinear partial differential equations

我们提出一种物理信息神经网络——这类网络在训练过程中不仅解决监督学习任务,同时严格遵循由通用非线性偏微分方程描述的物理定律。我们围绕两类核心问题的求解展开研究:偏微分方程的数据驱动求解与数据驱动发现。根据可用数据的性质与组织形式,我们设计出连续时间模型与离散时间模型两类不同算法框架。由此构建的神经网络形成了一类新型数据高效型通用函数逼近器,能够自然地将底层物理定律编码为先验信息。

在第一部分研究中,我们展示如何利用这类网络推断偏微分方程的解,并获得物理信息代理模型——该模型对所有输入坐标和自由参数均具备完全可微性。第二部分研究则聚焦于偏微分方程的数据驱动发现问题。

ParticleGS: Particle-Based Dynamics Modeling of 3D Gaussians for Prior-free Motion Extrapolation

本文旨在根据视觉观测数据建模三维高斯分布的动力学特性,以支持时间外推。

现有的动态三维重建方法通常难以有效学习潜在的动力学规律,或者严重依赖手动定义的物理先验,这限制了它们的外推能力。为解决这一问题,我们提出了一种新颖的、基于粒子动力学系统的、无需先验的动态三维高斯溅射运动外推框架。

我们方法的核心优势在于其能够学习描述三维高斯分布动力学的微分方程,并在未来帧外推过程中遵循这些方程。与简单地拟合观测到的视觉帧序列不同,我们的目标是更有效地建模高斯粒子动力学系统。为此,我们在标准高斯核中引入了一个动力学隐状态向量,并设计了一个动力学隐空间编码器来提取初始状态。随后,我们引入了一个基于神经常微分方程(Neural ODEs)的动力学模块,该模块在动力学隐空间中建模高斯分布的时间演化。最后,使用一个高斯核空间解码器将特定时间步的隐状态解码为形变。

实验结果表明,所提出的方法在重建任务中达到了与现有方法相当的渲染质量,并在未来帧外推方面显著优于现有方法。我们的代码公开在:https://github.com/QuanJinSheng/ParticleGS。

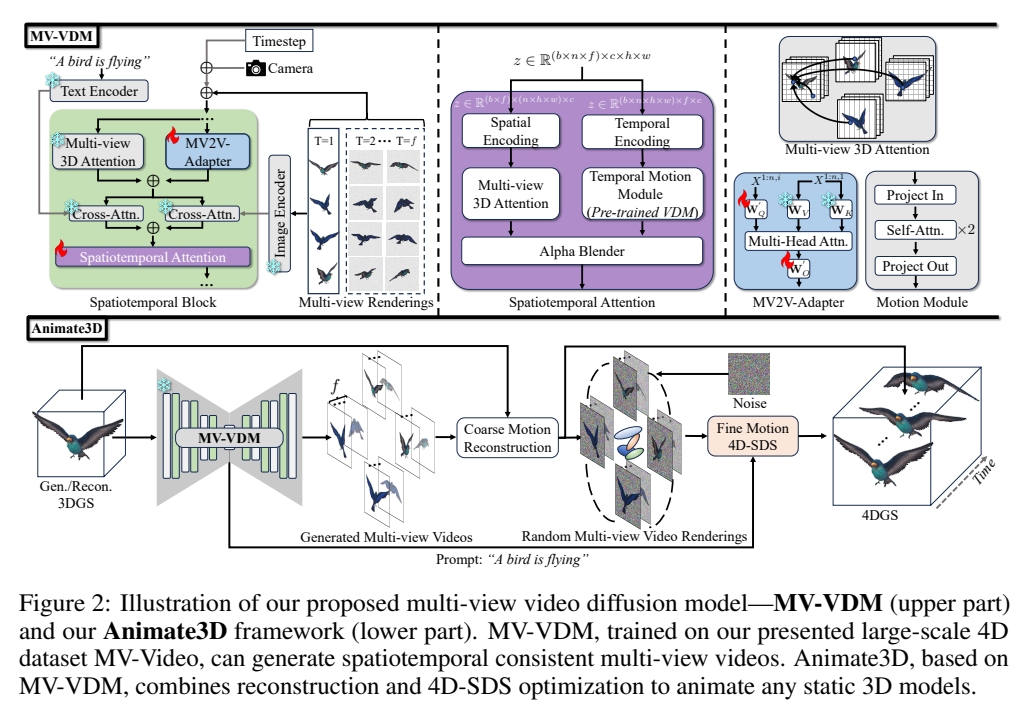

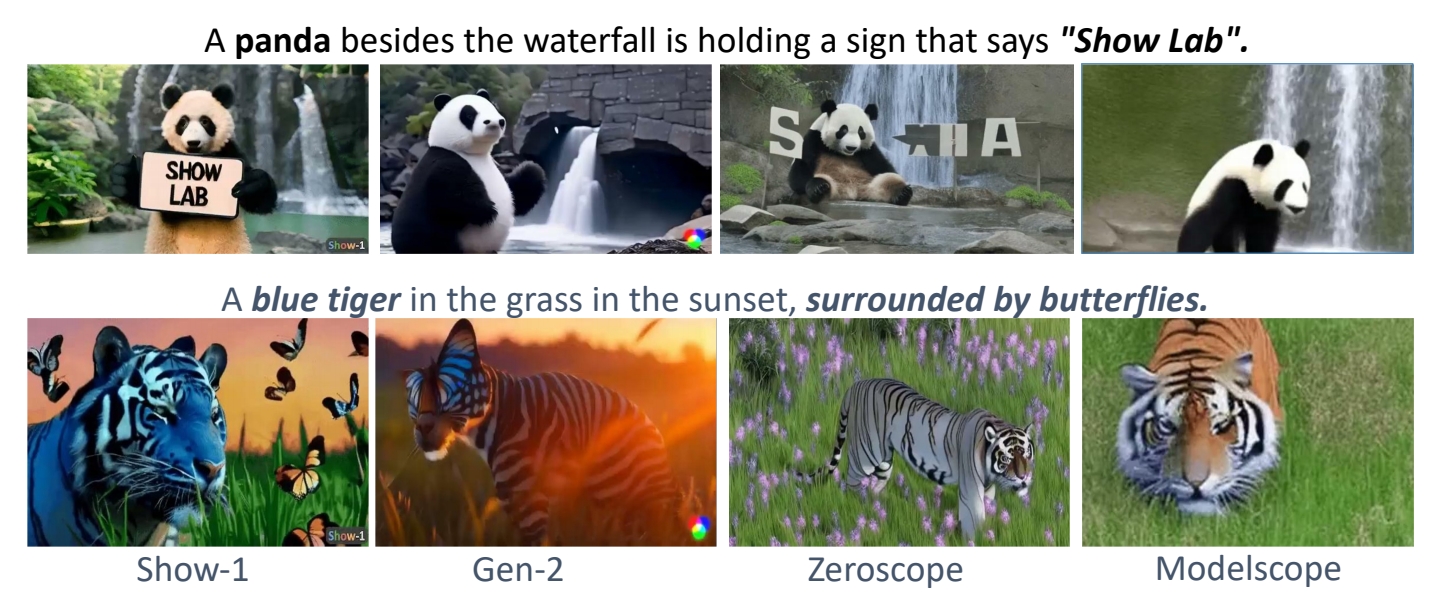

Animate3d: Animating any 3d model with multi-view video diffusion

当前四维生成领域的研究进展主要集中在通过蒸馏预训练的文本或单视图图像条件模型来生成四维内容。这类方法难以有效利用现有具有多视图属性的三维资源,且由于监督信号固有的模糊性,其生成结果常出现时空不一致问题。本研究提出Animate3D——一个可为任意静态三维模型生成动画的创新框架。其核心设计包含两个关键部分:1)我们提出基于静态三维对象多视图渲染的新型多视图视频扩散模型(MV-VDM),该模型在我们构建的大规模多视图视频数据集(MV-Video)上训练完成;2)基于MV-VDM,我们结合重建技术与四维分数蒸馏采样(4D-SDS),构建了利用多视图视频扩散先验实现三维对象动画的完整框架。具体而言,针对MV-VDM,我们设计了新颖的时空注意力模块,通过融合三维与视频扩散模型来增强时空一致性;同时利用静态三维模型的多视图渲染作为条件输入以保持其身份特征。在三维模型动画生成方面,我们提出有效的两阶段流程:首先直接从生成的多视图视频中重建运动序列,随后通过4D-SDS同步优化外观与运动表现。得益于精确的运动学习机制,我们能够实现直接的网格动画生成。定性与定量实验表明,Animate3D在各方面性能均显著超越现有方法。相关数据、代码与模型将全面开源。

研究背景与问题

任务

输入:3DGS静态模型 输出:t时刻相对于静态GS的位移、旋转、缩放。

本文方法及优势

| 要解决的问题 | 当前方法及存在的问题 | 本文方法及优势 |

|---|---|---|

| 引导视频 | 单视图图像或视频 由于监督信号固有的模糊性,其生成结果常出现时空不一致问题。 | 利用现有具有多视图属性的三维资源,构建多视图视频扩散模型(MV-VDM)。 |

主要贡献

1)多视角视频扩散模型(MV-VDM)

2)大规模多视图视频数据集(MV-Video)

3)基于MV-VDM,我们引入结合重建技术与4D分数蒸馏采样(4D-SDS)的框架,利用多视图视频扩散先验实现3D对象动画。

主要方法

多视角视频扩散模型(MV-VDM)

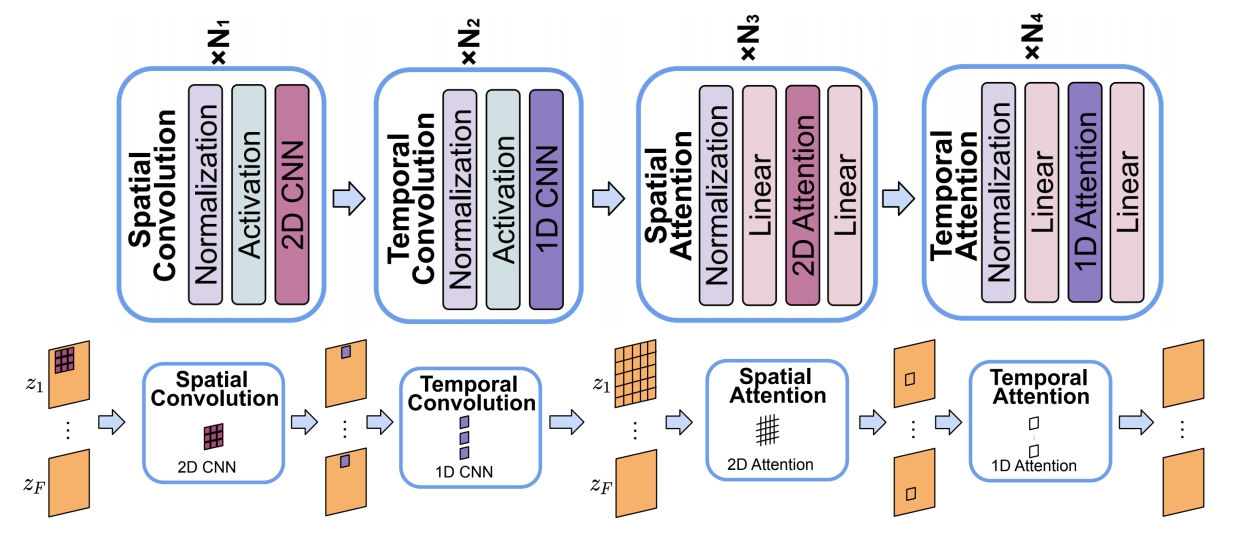

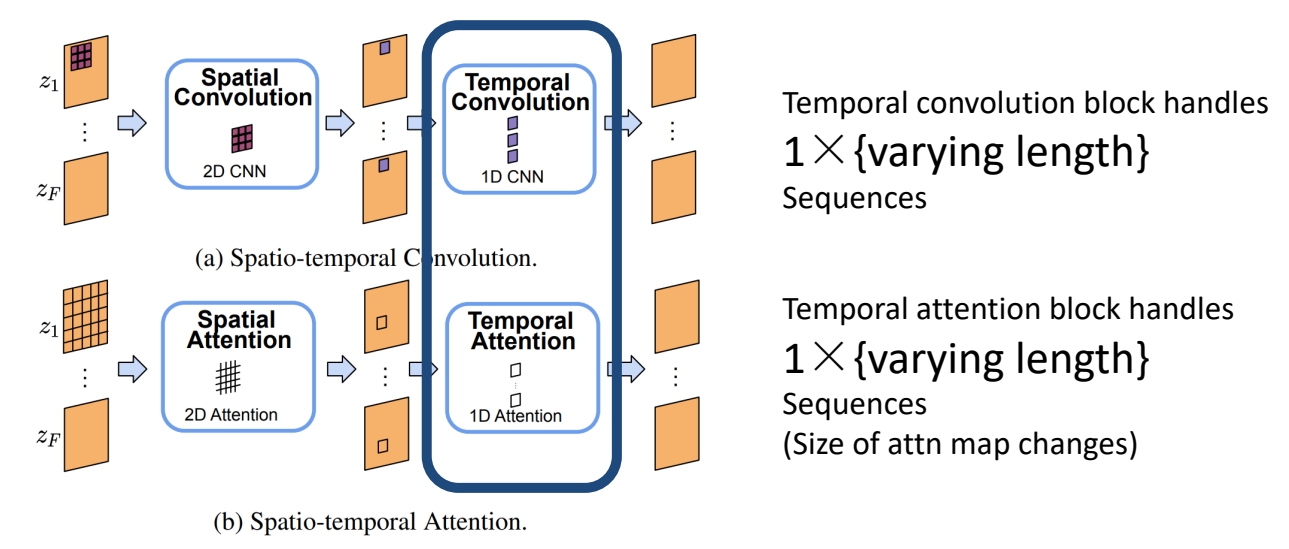

3D扩散模型(MVDream) + 视频扩散模型(AnimateDiff) + 结合图像条件化方法的高效即插即用时空注意力模块

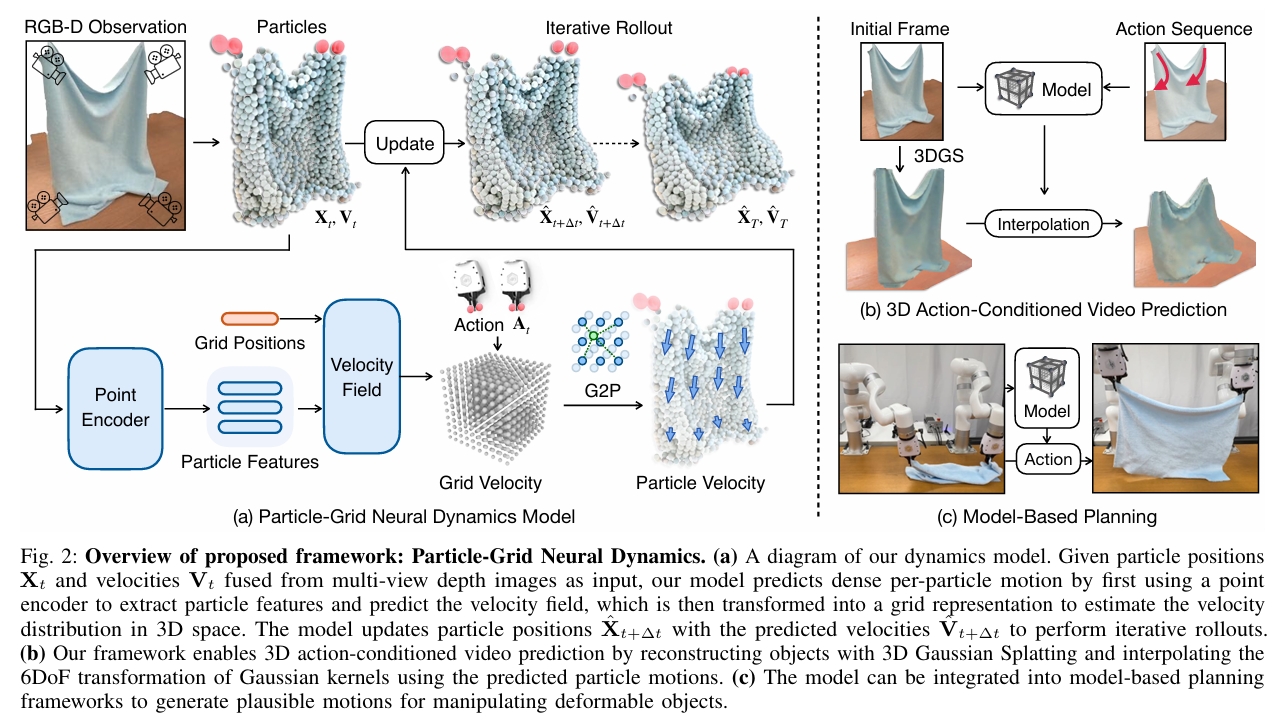

Particle-Grid Neural Dynamics for Learning Deformable Object Models from RGB-D Videos

由于可变形物体多样的物理特性以及难以从有限的视觉信息中估计其状态,建模其动力学具有挑战性。我们通过一个神经动力学框架来解决这些挑战,该框架在混合表示中结合了物体粒子 (object particles) 和空间网格 (spatial grids)。我们的粒子-网格模型 (particle-grid model) 既能捕捉全局形状和运动信息,又能预测密集的粒子运动,从而能够建模具有不同形状和材料的物体。粒子代表物体形状,而空间网格则将三维空间离散化,以确保空间连续性并提高学习效率。结合用于视觉渲染的高斯泼溅 (Gaussian Splatting) 技术,我们的框架实现了完全基于学习的可变形物体数字孪生模型 (fully learning-based digital twin),并生成动作条件的三维视频 (3D action-conditioned videos)。

通过实验,我们证明了我们的模型能够从机器人-物体交互的稀疏视角RGB-D记录 (sparse-view RGB-D recordings) 中学习各种物体(如绳索、布料、毛绒玩具和纸袋)的动力学,同时还能在类别层面 (category level) 上泛化到未见过的实例。我们的方法优于最先进的基于学习的模拟器 (learning-based simulators) 和基于物理的模拟器 (physics-based simulators),尤其是在相机视角有限 (limited camera views) 的场景下。此外,我们展示了所学模型在基于模型的规划 (model-based planning) 中的实用性,使其能够在一系列任务中实现目标条件的物体操作 (goal-conditioned object manipulation)。

项目页面位于:https://kywind.github.io/pgnd

研究背景与问题

任务

输入:3DGS场景的静态模型、交互操作

输出:预测GS球未来运动

主要方法

本文中仿真全过程使用的粒子是点云粒子。GS球只是最后渲染使用。

粒子-网格神经动力学

状态表示

| 符号 | 维度 | 含义 |

|---|---|---|

| Xt | 3*n | t时刻每个球的位置 |

| Vt | 3*n | t时刻每个球的速度 |

控制表示

\(A_t\) 表示机器人在时刻 \(t\) 对物体施加的外部作用。

$$ A_t = (y, T_t, \dot{T}_t, o_t), $$

| 符号 | 维度 | 含义 |

|---|---|---|

| \(y\) | 动作类型标签,是一个二元标签,用于指示动作是抓取操作还是非抓取式交互 | |

| \(T_t\) | 为末端执行器位姿 | |

| \(\dot{T}_t\) | 为其时间导数 | |

| \(o_t\) | 夹爪张开距离 |

动力学函数

$$ V_{t+1} = f_\theta(X_{(t-h):t}, V_{(t-h):t}, A_t) \\ X_{t+1} = X_t + V_{t+1} $$

粒子-网格模型

**使用端到端神经网络学习神经动力学参数 θ 通常会导致累积误差,进而引发预测不稳定。**因此同样采用particle-grid表示,以融入与空间连续性及局部信息集成相关的归纳偏置。

定义一个均匀分布的网格:

$$ G_{l_x, l_y, l_z, \delta} = { (k_x \delta, k_y \delta, k_z \delta) \mid k_i \in [l_i], \forall i \in {x, y, z} }. $$

末端执行器及每个粒子必定属于某个网格。

Grid用于学习上文提到的\(f_\theta\)函数。具体包含以下模块:

- \(f^{feature}_\phi\) 是基于神经网络的点编码器,用于从输入粒子中提取特征(第 III-B1 节);

- \(f^{field}_\psi\) 是基于神经网络的函数,用于根据提取的特征参数化神经速度场(第 III-B2 节);

- \(g^{grid}\) 是网格速度编辑控制方法,用于编码碰撞表面和机器人夹爪的运动(第 III-B4 节);

- \(h^{G2P}\) 是网格到粒子的积分函数,用于从基于网格的速度场计算粒子速度(第 III-B3 节)。

基于网格来学习速度场比直接学习每个粒子的速度更稳定。

网格模块

点编码器

输入:粒子位置与速度

输出:粒子的潜在特征

$$ Z_t = f^{feature}\phi (X{(t-h):t}, V_{(t-h):t}). $$

模型结构: PointNet

特征编码器必须提取对遮挡鲁棒的特征,以供后续速度解码使用。

神经速度场

输入:网格点g的位置x、网格点g的部感知特征z

输出:网格点g的速度向量

$$ \hat{v}{g,t} = f^{field}\psi (\gamma(x_g), z_{g,t}), $$

其中 \(\gamma\) 为正弦位置编码,局部感知特征 \(z_{g,t}\) 定义为网格位置邻域内粒子特征的平均池化:

$$ z_{g,t} = \frac{\sum_{p \in N_r(X_t, x_g)} z_{p,t}}{|N_r(X_t, x_g)|}, $$

半径 \(r\) 是一个超参数 (r),用于控制一个网格点所关注的粒子特征数量,从而促使网络预测依赖于局部几何的速度。

网格到粒子速度传递

遵循物质点法(MPM)的思路,采用连续的B样条核函数将网格速度 (\hat{v}{g,t}) 传递至粒子速度 (\hat{v}{p,t}):

$$ \hat{v}{p,t} = \sum{g \in G} \hat{v}{g,t} w{pg,t}, $$

预测值 \(\hat{V} \in \mathbb{R}^{3 \times n}\) 作为动力学函数 \(f_\theta\) 的最终输出,并用于更新粒子的位置。

变形控制

通过与外部物体交互来控制变形

网格速度编辑GVE

改变网格上的速度以匹配物理约束:

- 对于地面接触从接触面回推速度并加入摩擦项

- 定义刚性抓取点的运动,计算抓取中心点 \(x_{grasp,t}\) 附近的点,按如下方式修改其速度:

$$ v_{g,t} = \omega_t \times (x_g - x_{grasp,t}) + \dot{x}_{grasp,t}, $$

其中 \(\omega_t\) 和 \(\dot{x}{grasp,t}\) 分别为时刻 \(t\) 时夹爪的角速度和线速度,\(x_g\) 和 \(v{g,t}\) 分别为网格点 \(g\) 的位置和速度。

机器人粒子法

用于非抓取式动作建模,例如推动箱子。

用携带夹爪动作信息的额外粒子表示机器人夹爪,并将其融合到物体点云中

并在增广后的点云上建模粒子-网格动力学函数。

这便将动作信息注入粒子特征中,但不会显式强制粒子按指定速度运动,从而支持非抓取式操控。

数据收集与训练

数据收集

- 通过真实交互记录多视角的RGB-D视频,捕捉机器人-物体的随机交互过程。

- 用Segment-Anything [18, 39] 提取视频中物体的持续掩码。

- 将分割出的物体进行裁剪,并使用CoTracker [15] 对其进行跨帧跟踪,从而得到2D轨迹。

- 借助深度信息,通过逆投影将这些2D速度映射至3D空间,生成具有持续粒子跟踪信息的多视角融合点云。

训练

损失函数定义为预测粒子位置与实际粒子位置之间的均方误差位置。

渲染与动作条件视频预测

首先对点云集合 \(X\) 应用动力学模型,得到下一帧的预测 \(\hat{X}\)。点集 \(\hat{X}\) 可以来自对 \(X_{GS}\) 的采样,或从与 \(X_{GS}\) 处于同一坐标系内的额外点云观测中获取。

将 \(X\) 视为控制点,并对其预测运动进行插值,从而更新 \(X_{GS}\) 和 \(R_{GS}\),生成新的高斯中心与旋转。

假设高斯泼溅的颜色、尺度和不透明度保持不变。

HAIF-GS: Hierarchical and Induced Flow-Guided Gaussian Splatting for Dynamic Scene

基于单目视频的动态三维场景重建始终是三维视觉领域的核心难题。尽管三维高斯溅射(3DGS)技术在静态场景中实现了实时渲染,但其在动态场景的应用仍面临挑战——这源于学习结构化且时间一致的运动表征存在困难。现有方法通常表现为三方面局限:高斯更新冗余、运动监督不足,以及对复杂非刚性形变的建模能力薄弱。这些问题共同阻碍了连贯高效的动态重建。

为突破这些限制,我们提出HAIF-GS——一个通过稀疏锚点驱动形变实现结构化一致动态建模的统一框架。该框架首先通过锚点过滤器识别运动相关区域,抑制静态区域的冗余更新;随后利用自监督诱导流引导变形模块,通过多帧特征聚合驱动锚点运动,无需显式光流标签;为处理细粒度形变,分层锚点传播机制能依据运动复杂度提升锚点分辨率,并传播多级变换关系。在合成与真实数据集上的大量实验表明,HAIF-GS在渲染质量、时间一致性和重建效率上均显著超越现有动态3DGS方法。

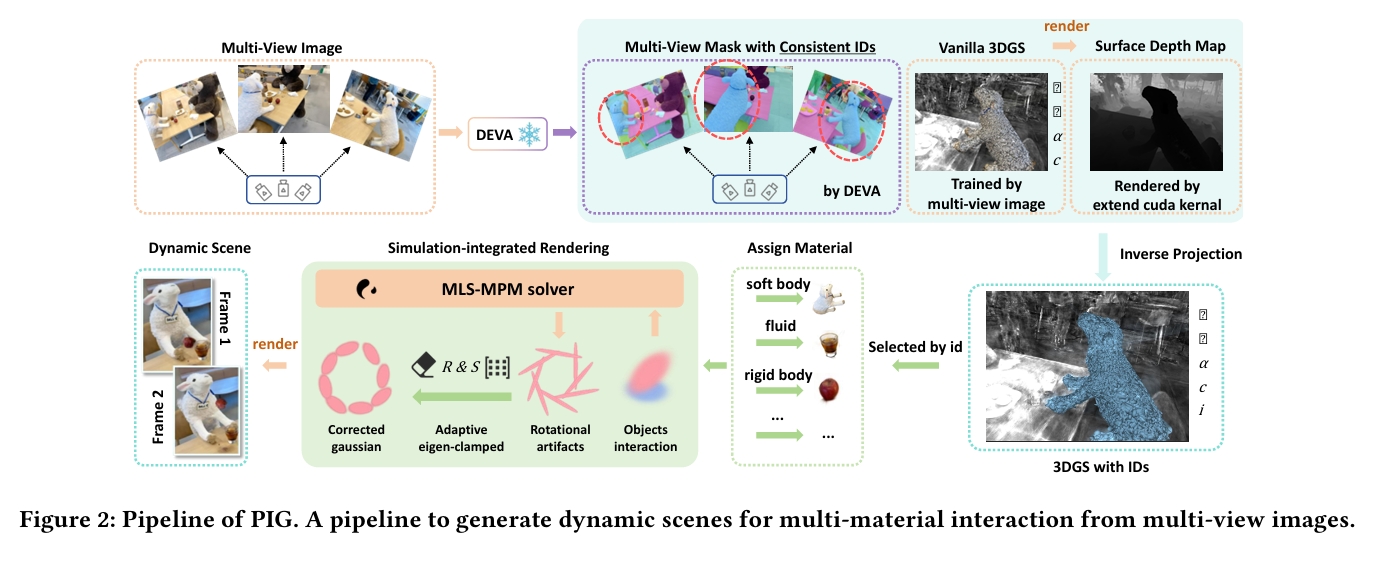

PIG: Physically-based Multi-Material Interaction with 3D Gaussians

3D高斯溅射技术在静态与动态3D场景重建领域取得了显著成功。然而,在由3D高斯基元表征的场景中,物体间的交互存在三大缺陷:三维分割精度不足、异质材质形变失准及严重渲染伪影。为应对这些挑战,我们提出PIG:基于物理的多材质3D高斯交互技术——这是一种融合三维物体分割与高精度交互仿真的创新方法。

首先,本方法实现了从二维像素到三维高斯基元的快速精准映射,从而达成精确的物体级三维分割。其次,我们为场景中分割后的物体赋予独特物理属性,以实现多材质耦合交互。最后,我们创新性地将约束尺度嵌入变形梯度,通过钳制高斯基元的缩放与旋转属性消除渲染伪影,达成几何保真度与视觉一致性。

实验结果表明,我们的方法不仅在视觉质量上显著超越现有最优方案(SOTA),更为物理真实感场景生成领域开辟了全新研究方向与技术路径。

研究背景与问题

任务

在由3D高斯基元表征的场景中的物体间的交互

现有方法及局限性

基于3D高斯泼溅的分割方法

- 从CLIP等二维预训练模型中提取特征,并将其蒸馏至3D高斯基元以进行点级分割。

- LangSplat训练自编码器在特征蒸馏前降维,将低维CLIP特征嵌入高斯模型中;

- Segment Any 3D Gaussians利用2D SAM掩码作为先验信息,训练场景专属特征

- Semantic Gaussians则借助高斯属性作为输入,训练具有二维预训练模型特征的3D语义特征;

- Feature Splatting通过渲染DINOv2与CLIP特征图,训练每个高斯基元的语义特征。

三维分割精度不足

驱动及渲染方法

- PhysGaussian提出将MPM与3DGS结合,在选定区域内生成单材料物理场景。这是首个将MPM引入3DGS的方法,但由于缺乏分割能力,难以在三维空间中精确定位仿真物体的包围盒。此外,当物体发生大变形时,直接使用MPM空间中粒子的变形梯度来调整对应高斯基元的协方差矩阵效果不佳。

- PhysDreamer通过集成生成模型来估计物理参数,再借助MPM进行仿真。该方法高度依赖生成模型的物理先验,且忽视了仿真与渲染间的差异——具体而言,它忽略了变形过程中高斯基元间相对位置的变化,导致渲染物体出现显著伪影。

异质材质形变失准及严重渲染伪影

本文方法及优势

本方法实现了从二维像素到三维高斯基元的快速精准映射,从而达成精确的物体级三维分割。

其次,我们为场景中分割后的物体赋予独特物理属性,以实现多材质耦合交互。

最后,我们创新性地将约束尺度嵌入变形梯度,通过钳制高斯基元的缩放与旋转属性消除渲染伪影,达成几何保真度与视觉一致性。

物体级三维分割

| 输入 | 输出 | 方法 |

|---|---|---|

| 多视角图像 | 3D高斯场景 | |

| 多视角图像 | 具有一致性ID的多视角掩码 | DEVA |

| 多视角图像 | 表面深度图 | |

| 表面深度图 | 2D到3D的映射关系 | |

| 2D到3D的映射关系 图像多视角掩码 | GS分割结果 |

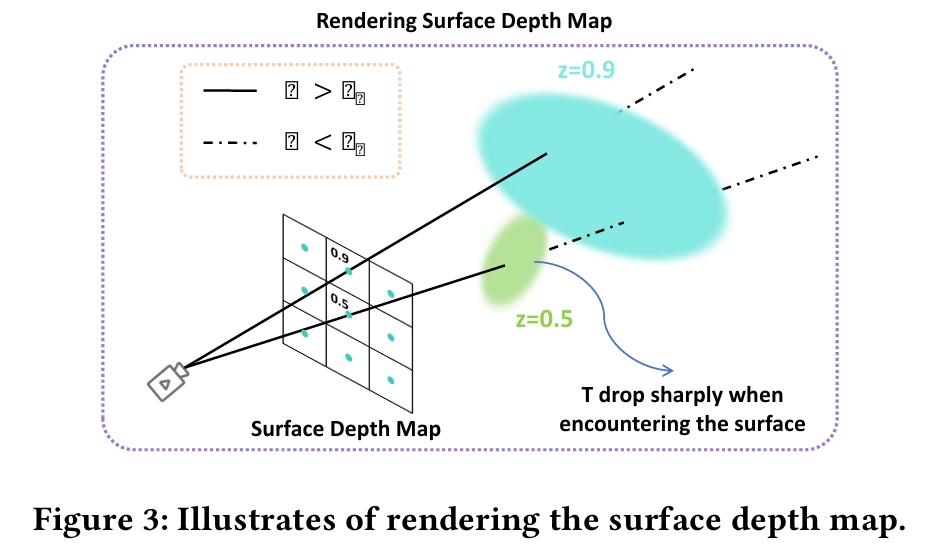

3.2.2 表面深度图渲染

为将掩码 \(M\) 中的 ID 映射到高斯场景 \(G\) 上,我们需要识别掩码中每个像素所对应的物体表面高斯元,并获取其深度信息,进而渲染成表面深度图。

对于任意像素 \(p_{i,j}^t\),我们将其转换为齐次坐标 \(P_{i,j}^t\)。利用相机内参 \(K\) 和外参 \(E\),得到相机坐标系下的射线方程:

$$ r_{i,j}^t(d) = C + d E^{-1} K^{-1} P_{i,j}^t, $$

其中 (C) 为相机在世界坐标系中的位置,(d) 表示深度。

射线与物体表面相交处,公式(1)中的透射率 (T) 会急剧下降。当 (T) 低于我们设定的透射率阈值 (\tau_T) 时,即表明已找到该像素对应的物体表面,此时将深度值 \(d_{i,j}^t\) 记录到深度图 \(D_t \in \mathbb{R}^{H \times W}\) 中。

EnliveningGS: Active Locomotion of 3DGS

本文提出了一种名为 EnliveningGS 的全新流程,它使得用 3D 高斯溅射(3DGS)表示的 3D 模型能够实现主动运动。我们的灵感来源于现实世界中生物通过压缩或拉伸其体内嵌入的肌纤维,以自然且符合物理规律的方式摆出身体姿态。EnliveningGS 旨在为 3DGS 模型复制类似的功能,从而使 3DGS 场景中的物体表现得如同活物,而非静态形状——它们在肌肉激活驱动的运动轨迹下,能够在场景中行走、跳跃和扭转。

尽管概念直观,但其中涉及许多需要解决的技术挑战。合成 3DGS 模型的逼真运动体现了一个非常高维度的逆向物理问题。核心挑战在于如何高效且鲁棒地建模“活化模型”与环境之间的摩擦接触,因为正是由肌肉激活引发的接触/碰撞/摩擦力共同作用,才最终生成了物体的运动。我们提出了一种混合数值方法,结合了线性互补问题(LCP)求解和惩罚法,以鲁棒地解决这个 NP 难题。

此外,我们的流程也解决了现有 3DGS 形变算法的局限性,并能够在模型移动时修复缺失的信息。

SplineGS: Learning Smooth Trajectories in Gaussian Splatting for Dynamic Scene Reconstruction

针对动态变形物体的复杂场景重建以实现新视角合成是一项极具挑战性的任务。近期研究通过引入三维高斯泼溅技术(3D Gaussian Splatting),在静态场景的高质量快速重建方面取得了显著进展,其核心在于为高斯斑点的形变设计了专用模块。然而,如何设计一个能够有效融入适当时空归纳偏置的形变模块仍是一个亟待解决的问题。为此,本文提出SplineGS方法,通过采用非均匀有理B样条(NURBS)——B样条的扩展形式——来表征时间维度上的平滑形变。该方法基于NURBS学习一组代表性轨迹,并通过这些轨迹的线性组合来表达各高斯斑点的个体运动轨迹,从而确保空间平滑性。组合权重的优化则依托于以高斯斑点位置为键值的多分辨率哈希表和MLP网络协同完成。得益于这种创新设计,本方法无需对运动轨迹施加正则化约束即可实现高效训练。实验结果表明,所提方法在保持训练时间大幅缩短的同时,其性能较现有方法具有显著竞争力。

PAMD: Plausibility-Aware Motion Diffusion Model for Long Dance Generation

计算舞蹈生成在艺术、人机交互、虚拟现实和数字娱乐等众多领域至关重要,尤其是在生成连贯且富有表现力的长舞蹈序列方面。基于扩散模型的音乐到舞蹈生成已取得显著进展,但现有方法仍难以生成物理上合理的运动。为解决此问题,我们提出了合理性感知运动扩散模型 (PAMD),这是一个用于生成既与音乐对齐又物理逼真的舞蹈框架。

PAMD的核心在于合理运动约束 (PMC),它利用神经距离场 (NDFs) 来建模真实的姿态流形,并将生成的运动引导至物理上有效的姿态流形。为了在生成过程中提供更有效的引导,我们引入了先验运动引导 (PMG),它将站立姿态作为辅助条件,与音乐特征一起使用。为了进一步增强复杂运动的真实感,我们提出了基于足地接触的运动优化 (MRFC) 模块,该模块通过弥合关节线性位置空间中的优化目标与非线性旋转空间中的数据表示之间的差距,来解决脚滑伪影问题。

大量实验表明,PAMD显著提高了音乐对齐度,并增强了生成运动的物理合理性。本项目页面地址为:https://mucunzhuzhu.github.io/PAMD-page/。

PMG: Progressive Motion Generation via Sparse Anchor Postures Curriculum Learning

在计算机动画、游戏设计以及人机交互领域,如何生成符合用户意图的人体运动始终是一项重大挑战。现有方法存在显著局限性:基于文本描述的方法能够提供高层语义指导,但难以准确描述复杂动作;基于轨迹的技术虽然能直观控制全局运动方向,却常无法生成精确或定制化的角色动作;而锚点姿态引导的方法通常仅限于生成简单运动模式。

为实现更高控制精度和更精细的运动生成,我们提出ProMoGen(渐进式运动生成框架) —— 一种将轨迹引导与稀疏锚点动作控制相结合的全新框架。全局轨迹保证了空间方向与位移的连贯性,而稀疏锚点动作仅传递精确的动作指导(不含位移信息)。这种解耦设计使得两者能够独立优化,从而实现更高可控性、高保真度与复杂运动合成。ProMoGen在统一训练流程中支持双控制范式(轨迹+锚点)与单控制范式(仅轨迹或仅锚点)的灵活切换。

此外,针对稀疏动作直接学习存在固有不稳定性的问题,我们提出SAP-CL(稀疏锚姿态课程学习策略)。该课程学习方法通过渐进式调整引导锚点数量,实现了更精准稳定的收敛效果。大量实验表明,ProMoGen在预定义轨迹与任意锚点帧的引导下,能够生成生动多样的运动。我们的方法将个性化动作与结构化引导无缝融合,在多种控制场景下显著优于当前最先进的方法。

LengthAware Motion Synthesis via Latent Diffusion

合成人体运动的时长是一个关键属性,需要对运动动力学和风格进行建模控制。加速动作执行并不仅仅是简单的快进播放。然而,目前最先进的人类行为合成技术在目标序列长度控制方面存在局限。我们提出了从文本描述生成长度感知的3D人体运动序列这一新课题,并提出了一种新颖模型来合成可变目标时长的运动,称之为"长度感知潜在扩散"(LADiff)。LADiff包含两个新模块:1)长度感知变分自编码器,通过长度相关的潜在代码学习运动表征;2)长度顺应潜在扩散模型,其生成运动的细节丰富度会随着所需目标序列长度的增加而提升。在HumanML3D和KIT-ML两个权威基准测试中,LADiff在大多数现有运动合成指标上显著超越了当前最先进技术。

IKMo: Image-Keyframed Motion Generation with Trajectory-Pose Conditioned Motion Diffusion Model

现有基于轨迹与姿态输入的人体运动生成方法通常对这两种模态进行全局处理,导致输出结果次优。本文提出 IKMo(基于图像关键帧的运动生成方法),这是一种基于扩散模型的运动生成方法,其核心在于解耦轨迹与姿态输入。轨迹和姿态输入经过一个两阶段条件化框架进行处理:

- 第一阶段:应用专门的优化模块对输入进行精细化处理。

- 第二阶段:轨迹和姿态并行通过一个轨迹编码器(Trajectory Encoder)和一个姿态编码器(Pose Encoder)进行编码。随后,一个运动控制网络(ControlNet)处理融合后的轨迹与姿态数据,引导生成具有高空间保真度与语义保真度的运动。

基于 HumanML3D 和 KIT-ML 数据集的实验结果表明,在轨迹-关键帧约束下,所提方法在所有指标上均优于现有最优方法。此外,我们实现了基于多模态大语言模型(MLLM)的智能体来预处理模型输入。给定用户提供的文本和关键帧图像,这些智能体能够提取运动描述、关键帧姿态和轨迹作为优化后的输入,输入到运动生成模型中。我们进行了包含 10 名参与者的用户研究,实验结果证明,基于 MLLM 的智能体预处理使生成的运动更符合用户预期。我们相信,所提出的方法显著提升了扩散模型在运动生成方面的保真度与可控性。

UniMoGen: Universal Motion Generation

动作生成是计算机图形学、动画、游戏和机器人技术的基石,能够实现逼真且多样化的角色动作创作。现有方法的一个显著局限是它们依赖于特定的骨骼结构,这限制了它们在不同角色间的通用性。

为克服此局限,我们提出了 UniMoGen,一种新颖的、基于 UNet 架构的扩散模型,专为骨架无关的动作生成而设计。UniMoGen 可训练来自不同角色(如人类和动物)的动作数据,且无需预定义最大关节数量。通过仅动态处理每个角色必需的关节,我们的模型同时实现了骨架无关性和计算高效性。

UniMoGen 的关键特性包括:通过风格和轨迹输入实现可控性,以及从过往帧延续动作的能力。我们在 100style 数据集上验证了 UniMoGen 的有效性,其在多样化角色动作生成方面优于最先进的方法。此外,当在使用了不同骨骼的 100style 和 LAFAN1 数据集上联合训练时,UniMoGen 在两种骨骼上都实现了高性能和更高的效率。

这些结果突显了 UniMoGen 的潜力:通过为广泛的角色动画提供灵活、高效且可控的解决方案,推动动作生成技术的进步。

AMD: Anatomical Motion Diffusion with Interpretable Motion Decomposition and Fusion

根据文本描述生成逼真的人体运动序列是一项具有挑战性的任务,需要同时捕捉自然语言和人体运动的丰富表现力。尽管扩散模型的最新进展推动了人体运动合成领域的重大突破,但现有方法在处理描述复杂或长时间运动的文本输入时仍存在困难。本文提出可适应运动扩散(AMD)模型,通过利用大语言模型(LLM)将输入文本解析为一系列与目标运动相对应的简洁可解释的解剖学脚本。该过程充分发挥了LLM为复杂运动合成提供解剖学指导的能力。我们设计了一种双分支融合方案,在反向扩散过程中平衡输入文本与解剖学脚本的影响,自适应地确保合成运动的语义保真度与多样性。我们的方法能有效处理包含复杂或长序列运动描述的文本,而现有方法在此类场景中往往表现不佳。在包含相对复杂运动的数据集(如CLCD1和CLCD2)上的实验表明,AMD模型显著优于现有最先进方法。

Flame: Free-form language-based motion synthesis & editing

Human Motion Diffusion as a Generative Prior

最近研究表明,去噪扩散模型在人体运动生成(包括文本驱动运动生成)方面具有巨大潜力。然而,现有方法受限于标注运动数据匮乏、仅关注单人动作生成以及缺乏精细控制能力。本文基于扩散先验提出三种组合模式:序列组合、并行组合与模型组合。通过序列组合,我们解决了长序列生成难题,提出DoubleTake推理方法——仅通过短片段训练的扩散先验,即可生成由提示区间及其过渡组成的长动画序列。借助并行组合,我们在双人生成任务上取得突破性进展:基于两个固定先验及少量双人训练样本,我们开发了轻量级通信模块ComMDM,用于协调两个生成动作间的交互。通过模型组合,我们首先训练独立先验模型以生成符合指定关节约束的动作,进而提出DiffusionBlending插值机制,有效融合多个此类模型,实现灵活高效的关节级与轨迹级精细控制与编辑。我们采用现成的运动扩散模型对三种组合方法进行评估,并将生成结果与针对特定任务专门训练的模型进行对比验证。

Text-driven Human Motion Generation with Motion Masked Diffusion Model

文本驱动的人体运动生成是一项多模态任务,旨在根据自然语言描述合成人体运动序列。该任务要求模型在多样化条件输入下满足文本描述,同时生成合理逼真且具有高度多样性的人类动作。基于扩散模型的方法在生成的多样性和多模态性方面表现突出,但与在推理前训练运动编码器的自回归方法相比,扩散方法在拟合人体运动特征分布方面存在不足,导致FID评分不理想。一个重要发现是,扩散模型缺乏通过上下文推理学习时空语义间运动关系的能力。为解决这一问题,本文提出运动掩码扩散模型(MMDM),通过新颖的人体运动掩码机制显式增强扩散模型从运动序列上下文关节中学习时空关系的能力。此外,针对人体运动数据具有动态时间特征和空间结构的特点,我们设计了两种掩码建模策略:时间帧掩码和身体部位掩码。在训练过程中,MMDM会对运动嵌入空间中的特定标记进行掩码处理,随后设计的扩散解码器在每个采样步骤中学习从掩码嵌入还原完整运动序列,使模型能够从不完整表征中恢复完整序列。在HumanML3D和KIT-ML数据集上的实验表明,我们的掩码策略能有效平衡运动质量与文本-运动一致性。

ReMoDiffuse: RetrievalAugmented Motion Diffusion Model

三维人体运动生成在创意产业中具有关键作用。基于生成模型与领域知识的文本驱动运动生成技术近年来取得显著进展,在常规动作捕捉方面成效卓著。然而,面对更复杂的多样化动作时,现有方法仍表现欠佳。本研究提出ReMoDiffuse——一种融合检索机制的扩散模型运动生成框架,通过优化去噪过程提升生成效果。ReMoDiffuse通过三项核心设计增强文本驱动运动生成的普适性与多样性:1)混合检索机制从语义相似度与运动学特征相似度双重维度在数据库中寻找合适参考;2)语义调制变换器选择性吸收检索知识,自适应调整检索样本与目标运动序列间的差异;3)条件混合机制在推理阶段更高效利用检索数据库,克服无分类器引导中的尺度敏感问题。大量实验表明,ReMoDiffuse在文本-运动一致性与运动质量之间取得卓越平衡,尤其在多样化运动生成任务上超越现有最优方法。

MotionLCM: Real-time Controllable Motion Generation via Latent Consistency Model

本研究提出MotionLCM,将可控运动生成提升至实时水平。现有文本条件运动生成中的时空控制方法存在显著运行效率低下的问题。为解决此问题,我们基于运动潜在扩散模型,首次提出用于运动生成的运动潜在一致性模型(MotionLCM)。通过采用单步(或少步)推理,我们进一步提升了运动潜在扩散模型在运动生成中的运行效率。为确保有效可控性,我们在MotionLCM的潜在空间中引入运动ControlNet,使原始运动空间中的显式控制信号(即初始运动)能够为训练过程提供额外监督。应用这些技术后,我们的方法能够实时生成符合文本和控制信号的人类运动。实验结果表明,MotionLCM在保持实时运行效率的同时,展现出卓越的生成与控制能力。

ReAlign: Bilingual Text-to-Motion Generation via Step-Aware Reward-Guided Alignment

双语文本到运动生成通过双语文本输入合成3D人体运动,在游戏、影视和机器人等跨语言应用领域具有巨大潜力。然而,该任务面临两大关键挑战:缺乏双语运动-语言数据集,以及扩散模型中文本与运动分布的不对齐问题,导致生成运动存在语义不一致或质量低下的情况。为应对这些挑战,我们提出了BiHumanML3D双语人体运动数据集,为双语文本到运动生成模型建立了重要基准。此外,我们开发了双语运动扩散模型(BiMD),通过跨语言对齐表征捕捉语义信息,实现统一的双语建模。在此基础上,我们提出了奖励引导的采样对齐方法(ReAlign),包含用于评估采样过程中对齐质量的步态感知奖励模型,以及引导扩散过程向最优对齐分布演进的奖励引导策略。该奖励模型融合步态感知标记,结合保证语义一致性的文本对齐模块和提升真实性的运动对齐模块,通过在每一步优化噪声运动,平衡概率密度与对齐效果。实验表明,相较于现有最优方法,我们的方法在文本-运动对齐质量和运动生成质量上均有显著提升。项目主页:https://wengwanjiang.github.io/ReAlign-page/。

Absolute Coordinates Make Motion Generation Easy

当前最先进的文本到动作生成模型依赖于由 HumanML3D 推广的运动学感知、局部相对动作表示方法。该方法通过相对于骨盆和前一帧对动作进行编码,并带有内置冗余。虽然这种设计简化了早期生成模型的训练,但它却给扩散模型带来了关键限制,并阻碍了其在下游任务中的应用。

在这项工作中,我们重新审视了动作表示方法,并为文本到动作生成提出了一种经过彻底简化且被长期弃用的替代方案:全局空间中的绝对关节坐标。通过对设计选择的系统分析,我们发现,即使仅使用简单的 Transformer 主干网络且无需辅助的运动学感知损失函数,这种表述方式也能实现显著更高的动作保真度、改进的文本对齐能力以及强大的可扩展性。

此外,我们的方法天然支持下游任务,例如文本驱动的动作控制以及时间/空间编辑,无需额外的任务特定工程改造,也无需根据控制信号进行成本高昂的分类器引导生成。

最后,我们展示了其良好的泛化能力,能够直接从文本生成运动中的 SMPL-H 网格顶点,为未来的研究和动作相关应用奠定了坚实基础。

Seamless Human Motion Composition with Blended Positional Encodings

条件式人体运动生成是一个重要的研究课题,在虚拟现实、游戏和机器人技术等领域具有广泛应用。现有研究多集中于基于文本、音乐或场景引导的运动生成,但这些方法通常只能生成短时孤立的运动片段。本文致力于解决根据连续变化的文本描述生成长时间连续运动序列的问题。为此,我们提出了FlowMDM——首个基于扩散模型的、无需后处理或冗余去噪步骤即可生成无缝人体运动组合(HMC)的方法。我们创新性地提出了混合位置编码技术,在去噪链中同时利用绝对位置编码和相对位置编码。具体而言,绝对编码阶段重建全局运动一致性,而相对编码阶段则构建平滑逼真的动作过渡。在Babel和HumanML3D数据集上的实验表明,我们的方法在动作准确性、真实感和流畅度方面均达到了最先进水平。得益于其以动作为核心的交叉注意力机制,FlowMDM在仅使用单个描述训练的情况下,仍能有效应对推理时多变的文本输入。最后,针对现有HMC评估指标的局限性,我们提出了两个新指标:峰值加加速度和加加速度曲线下面积,用以检测运动中的突变转换。

FineMoGen: Fine-Grained Spatio-Temporal Motion Generation and Editing

随着扩散模型的出现,文本驱动动作生成已取得显著进展。然而,现有方法在生成符合细粒度描述的复杂动作序列时仍存在困难——这些描述需要描绘精确的时空动作细节。这种精细可控性的缺失限制了动作生成技术向更广泛受众的推广。为解决这些挑战,我们提出FineMoGen,这是一个基于扩散模型的运动生成与编辑框架,能够根据用户指令进行时空组合,生成细粒度动作。具体而言,FineMoGen在扩散模型基础上构建了名为时空混合注意力(SAMI)的新型Transformer架构。SAMI从两个角度优化全局注意力模板的生成:1)显式建模时空组合的约束条件;2)利用稀疏激活的专家混合机制自适应提取细粒度特征。为促进这一新型细粒度动作生成任务的大规模研究,我们构建了HuMMan-MoGen数据集,包含2,968个视频和102,336条细粒度时空描述。大量实验证明,FineMoGen在动作生成质量上显著优于现有最优方法。值得注意的是,借助现代大语言模型(LLM),FineMoGen进一步实现了零样本动作编辑能力,能够通过细粒度指令精准操控动作序列。项目页面:https://mingyuan-zhang.github.io/projects/FineMoGen.html

Fg-T2M: Fine-Grained Text-Driven Human Motion Generation via Diffusion Model

基于文本的人体动作生成在计算机视觉领域兼具重要性与挑战性。然而,现有方法仅能生成确定性或不够精确的动作序列,难以有效控制时空关系以契合给定文本描述。本研究提出一种细粒度条件生成方法,可依据精准文本描述生成高质量人体运动序列。我们的方案包含两个核心组件:1)语言结构辅助模块——通过构建精准完整的语言特征以充分挖掘文本信息;2)上下文感知渐进推理模块——借助浅层与深层图神经网络分别学习局部与全局语义语言学特征,实现多步推理。实验表明,本方法在HumanML3D和KIT测试集上超越现有文本驱动动作生成方法,并能根据文本条件生成视觉表现更优的运动序列。

Make-An-Animation: Large-Scale Text-conditional 3D Human Motion Generation

基于文本引导的人体动作生成技术因其在动画与机器人领域的广泛应用而备受关注。近年来,扩散模型在动作生成中的应用显著提升了生成动作的质量。然而,现有方法受限于对较小规模动作捕捉数据的依赖,导致在面对多样化真实场景提示时表现不佳。本文提出Make-An-Animation这一文本条件化人体动作生成模型,通过从大规模图文数据集中学习更丰富的姿态与提示信息,实现了性能上的重大突破。

该模型采用两阶段训练策略:首先利用从图文数据集中提取的(文本,静态伪姿态)配对数据进行大规模预训练,随后在动作捕捉数据上通过新增时序建模层进行微调。与现有基于扩散模型的动作生成方法不同,Make-An-Animation采用类似最新文生视频模型的UNet架构。在动作真实性与文本契合度的人工评估中,本模型达到了文本驱动动作生成领域的最先进水平。生成样本可访问https://azadis.github.io/make-an-animation 查看。

StableMoFusion: Towards Robust and Efficient Diffusion-based Motion Generation Framework

得益于扩散模型强大的生成能力,人体动作生成领域近年来发展迅速。现有的基于扩散模型的方法采用了各不相同的网络架构和训练策略,各个组件设计的具体影响尚不明确。此外,迭代去噪过程需要消耗大量计算资源,这对虚拟角色和人形机器人等实时应用场景而言难以承受。为此,我们首先对网络架构、训练策略及推理过程进行了全面研究,基于深入分析为高效高质量的人体动作生成量身优化每个组件。尽管优化后的模型表现出色,但仍存在脚部滑动现象——这是基于扩散的解决方案中普遍存在的问题。为消除脚部滑动,我们通过识别足地接触关系并在去噪过程中修正脚部运动,将这些精心设计的组件有机整合,提出了稳健高效的人体动作生成框架StableMoFusion。大量实验结果表明,我们的StableMoFusion在性能上优于当前最先进方法。项目页面:https://h-y1heng.github.io/StableMoFusionpage/。

EMDM: Efficient Motion Diffusion Model for Fast and High-Quality Motion Generation

本文提出高效运动扩散模型(EMDM),旨在实现快速、高质量的人体运动生成。当前最先进的生成式扩散模型虽能产生令人印象深刻的结果,但在保持质量的同时难以实现快速生成。一方面,诸如运动潜在扩散等方法为提升效率在潜在空间中进行扩散,但学习此类潜在空间本身需要大量计算资源;另一方面,若直接采用增大采样步长的方式(如DDIM)加速生成,则因难以逼近复杂的去噪分布往往导致质量下降。为解决这些问题,我们提出的EMDM模型能够在扩散模型的多步采样过程中有效捕捉复杂分布,从而大幅减少采样步骤并显著加速生成过程。该模型通过条件去噪扩散GAN技术,在任意(可能更大)步长条件下根据控制信号捕捉多模态数据分布,实现高保真度、多样化的少步数运动采样。为减少不良运动伪影,我们在网络学习过程中引入几何约束损失。实验表明,EMDM可实现实时运动生成,在保证高质量运动生成的同时,较现有方法显著提升了运动扩散模型的效率。研究成果发表后代码将开源发布。

Motion Mamba: Efficient and Long Sequence Motion Generation

摘要:人体运动生成是生成式计算机视觉领域的重要研究方向,然而实现长序列且高效的运动生成仍面临挑战。近年来,状态空间模型(SSMs)尤其是Mamba的进展,通过硬件感知的高效设计在长序列建模中展现出巨大潜力,这为构建运动生成模型指明了重要方向。然而,由于缺乏针对运动序列建模的专用架构,将SSMs应用于运动生成仍存在障碍。为此,我们提出Motion Mamba——一种简单高效的方法,率先构建了基于SSMs的运动生成模型。具体而言,我们设计了分层时序Mamba(HTM)模块,通过在对称U-Net架构中集成不同数量的独立SSM模块来处理时序数据,以保持帧间运动一致性;同时开发了双向空间Mamba(BSM)模块,通过双向处理潜在姿态来增强时序帧内的运动生成精度。在HumanML3D和KIT-ML数据集上的实验表明,本方法相较于现有最佳扩散模型方法,FID指标提升最高达50%,推理速度提升达4倍,充分证明了其在高质量长序列运动建模与实时人体运动生成方面的强大能力。

状态空间模型SSN和Mamba

首先,需要区分两个概念:经典控制论中的状态空间模型 和 深度学习新模型(如Mamba)所指的状态空间模型。它们思想同源,但设计和目标不同。

1. 经典状态空间模型(控制论/时序分析)

在传统意义上,SSM是一个用于描述动态系统的数学模型,它由两个方程组成:

- 状态方程(过程模型):描述系统内部状态如何随时间演变。

x(t) = A * x(t-1) + B * u(t) + w(t) - 观测方程(测量模型):描述我们如何从外部观测到系统的状态。

y(t) = C * x(t) + D * u(t) + v(t)

其中:

x(t):系统在时刻t的内部状态(通常无法直接观测)。u(t):在时刻t的输入/控制信号。y(t):在时刻t的观测/输出信号。A:状态转移矩阵,描述状态如何自行演变。B:输入矩阵,描述输入如何影响状态。C:输出矩阵,描述状态如何被我们观测到。D:直通矩阵,描述输入如何直接影响输出(通常可忽略)。w(t),v(t):过程噪声和观测噪声。

应用场景:卡尔曼滤波、目标跟踪、经济预测、机器人导航等。其核心思想是通过嘈杂的观测数据,来估计一个动态系统的内部真实状态。

2. 深度学习中的状态空间模型(如Mamba, S4)

您论文中提到的SSM,特指的是一类近年来在深度学习领域复兴的序列模型。它们从经典SSM中汲取了核心思想,但将其重新设计为适用于通用序列建模(如自然语言、音频、运动)的可训练神经网络模块。

核心思想:

将这些模型看作一个将输入序列 u(t) 映射到输出序列 y(t) 的系统。它们通过一个隐含状态 x(t) 来记忆和整合过去的信息。

关键特点与优势:

-

连续系统离散化:

- 经典的SSM是定义在连续时间上的。为了处理离散的序列数据(如文本、运动帧),需要将其离散化。这会引入两个关键参数

∆(步长)和Ā, B̄(离散化后的状态矩阵)。 - Mamba的贡献之一是让

∆和B, C成为输入依赖的,使得模型能够根据当前输入动态调整行为,从而更关注相关信息。

- 经典的SSM是定义在连续时间上的。为了处理离散的序列数据(如文本、运动帧),需要将其离散化。这会引入两个关键参数

-

循环模式 vs. 卷积模式:

- 循环模式:按照时间步一步步计算,状态

x(t)依赖于x(t-1)。这非常高效(固定计算量/步),类似于RNN,但无法并行训练。 - 卷积模式:通过数学推导,可以将整个序列的输出

y表示为输入u和一个卷积核K的卷积结果。这允许高效并行训练,但卷积核长度受限于训练长度,无法直接推广到更长的序列。

- 循环模式:按照时间步一步步计算,状态

-

核心优势:

- 长序列建模:由于隐含状态的存在,理论上它可以记住非常长的上下文信息,避免了Transformer在长序列上的二次复杂度问题。

- 计算效率:无论是循环模式的高效推理,还是卷积模式的高效训练,SSM在计算和内存上都比Transformer更轻量。

- 硬件感知设计(Mamba的核心):Mamba模型通过其选择性扫描机制,避免了 materializing 巨大的中间矩阵,实现了比其前身(S4模型)更快的速度,并保持了处理长序列的能力。

总结对比

| 特性 | 经典状态空间模型 | 深度学习状态空间模型(如Mamba) |

|---|---|---|

| 目标 | 估计动态系统的内部状态 | 通用的序列建模与表示学习 |

| 应用领域 | 控制、滤波、预测 | NLP、语音、视频、运动生成 |

| 参数 | 通常固定,由系统决定 | 可训练的神经网络参数 |

| 核心机制 | 卡尔曼滤波/平滑 | 离散化 + 并行化卷积 + 硬件优化 |

| 与Transformer关系 | 无关 | 替代/补充Transformer,解决其长序列、低效率问题 |

简单来说,在论文语境中:

状态空间模型(SSM)是一种新兴的深度学习架构,它通过一个可学习的、不断演变的“内部状态”来理解和处理序列信息。这种设计让它特别擅长处理像长序列运动数据这样的任务,因为它既能捕捉长距离依赖,又比传统的Transformer模型更高效。Mamba则是目前该系列中最先进的模型之一。

M2D2M: Multi-Motion Generation from Text with Discrete Diffusion Models

摘要:本文提出多动作离散扩散模型(M2D2M),这是一种利用离散扩散模型优势、从多动作文本描述生成人体运动的新方法。该方法巧妙解决了生成多动作序列的挑战,能确保动作间流畅过渡及系列动作的连贯性。M2D2M的核心优势在于其离散扩散模型中的动态转移概率机制——该机制根据运动标记的邻近性自适应调整转移概率,有效促进不同模态间的混合。结合包含独立去噪与联合去噪的两阶段采样策略,M2D2M仅需使用单动作生成训练的模型,即可有效生成长期、平滑且上下文连贯的人体运动序列。大量实验表明,M2D2M在文本描述生成运动任务上超越了当前最先进的基准模型,其在语言语义解析与动态逼真运动生成方面的效能得到了充分验证。

T2LM: Long-Term 3D Human Motion Generation from Multiple Sentences

本文致力于解决长期3D人体运动生成这一挑战性难题,重点研究如何从多语句(即段落)输入中生成平滑衔接的连续动作序列。现有的长期运动生成方法多基于循环神经网络架构,以前序生成的运动片段作为后续输入。然而该方法存在双重缺陷:1)依赖成本高昂的序列化数据集;2)逐步生成的运动片段间存在失真间隙。为应对这些问题,我们提出了一种简洁高效的T2LM框架——无需序列化数据即可训练的连续长期生成系统。该框架包含两个核心组件:训练用于将运动压缩为潜在向量序列的一维卷积VQVAE,以及基于Transformer的文本编码器(可根据输入文本预测潜在序列)。在推理阶段,语句序列被转换为连续的潜在向量流,经由VQVAE解码器重构为运动序列;通过采用具有局部时间感受野的一维卷积,有效避免了训练与生成序列间的时间不一致性。这种对VQ-VAE的简易约束使其仅需短序列训练即可实现更平滑的过渡效果。T2LM不仅显著优于现有长期生成模型并突破序列数据依赖的局限,在单动作生成任务上也达到了与当前最优模型相媲美的性能。

AttT2M:Text-Driven Human Motion Generation with Multi-Perspective Attention Mechanism

基于文本描述生成三维人体运动一直是近年来的研究热点。该任务要求生成的运动兼具多样性、自然性,并符合文本描述。由于人体运动固有的复杂时空特性,以及文本与运动间跨模态关系学习的难度,文本驱动运动生成仍是一个具有挑战性的问题。为解决这些难题,我们提出AttT2M——一种融合多视角注意力机制的双阶段方法:身体部位注意力与全局-局部运动-文本注意力。前者从运动嵌入视角出发,通过在VQ-VAE中引入身体部位时空编码器,学习更具表现力的离散潜在空间;后者基于跨模态视角,用于学习句子层级和词汇层级的运动-文本跨模态关联。最终通过生成式变换器实现文本驱动运动的合成。在HumanML3D和KIT-ML数据集上的大量实验表明,本方法在定性与定量评估上均优于当前最优成果,实现了细粒度合成和动作到运动的精准生成。代码详见:https://github.com/ZcyMonkey/AttT2M。

自回归模型通过施加因果约束,在序列依赖关系建模方面表现出色,但其单向特性导致难以捕捉复杂的双向模式。相比之下,基于掩码的模型能利用双向上下文实现更丰富的依赖关系建模,但其预测过程常假设标记相互独立,这削弱了对序列依赖关系的刻画能力。此外,通过掩码或吸收操作对序列进行的破坏可能引入不自然的失真,增加学习难度。为应对这些挑战,我们提出双向自回归扩散模型(BAD),这一创新方法融合了自回归与基于掩码的生成模型优势。BAD采用基于排列的序列破坏技术,在通过随机排序保持因果依赖的同时维护自然序列结构,从而有效捕捉序列与双向关系。综合实验表明,BAD在文本到动作生成任务中优于自回归和基于掩码的模型,为序列建模提供了创新的预训练策略。BAD代码库已发布于https://github.com/RohollahHS/BAD。

MMM: Generative Masked Motion Model

基于扩散模型与自回归模型的文本驱动动作生成技术近期取得显著进展,但其性能往往难以兼顾实时性、高保真度与动作可编辑性。为突破这一局限,我们提出MMM——一种基于掩码动作模型的全新简易动作生成范式。该框架包含两个核心组件:(1)动作分词器:将三维人体动作转换为潜空间中的离散标记序列;(2)条件掩码动作变换器:基于预计算文本标记,学习预测随机掩码的动作标记。通过全方位感知动作与文本标记的关联,MMM显式捕获了动作标记间的内在依赖性及动作-文本标记间的语义映射关系。在推理阶段,这种机制支持并行迭代解码生成与细粒度文本描述高度契合的多个动作标记,从而同步实现高保真与高速率的动作生成。此外,MMM具备天然的动作编辑能力:只需在待编辑位置设置掩码标记,模型即可自动填充内容,并确保编辑与非编辑片段间的平滑过渡。在HumanML3D和KIT-ML数据集上的大量实验表明,MMM生成的动作质量超越当前主流方法(其FID分数分别达到0.08和0.429),同时支持身体局部编辑、动作插帧及长序列生成等高级功能。在单块中端GPU上,MMM的运算速度比可编辑动作扩散模型快两个数量级。项目页面详见:https://exitudio.github.io/MMM-page/

Priority-Centric Human Motion Generation in Discrete Latent Space

文本驱动动作生成是一项极具挑战的任务,其目标是生成既符合输入文本描述,又遵循人体运动规律与物理定律的人类动作。尽管扩散模型已取得显著进展,但其在离散空间中的应用仍待深入探索。现有方法往往忽视不同动作的重要性差异,对其进行均等处理。需要认识到的是,并非所有动作都与特定文本描述具有同等关联度——某些更具显著性和信息量的动作应在生成过程中被优先考虑。为此,我们提出了以优先级为核心的动作离散扩散模型(M2DM):该模型采用基于Transformer的VQ-VAE架构,通过全局自注意力机制与正则化项构建紧凑的离散动作表示,有效防止代码坍塌;同时设计了一种创新的运动离散扩散模型,通过分析动作令牌在整体序列中的重要性来制定噪声调度策略。这种方法在逆向扩散过程中保留最显著的动作特征,从而生成语义更丰富、多样性更强的动作序列。此外,我们融合文本与视觉指标提出两种动作令牌重要性评估策略。在HumanML3D和KIT-ML数据集上的综合实验表明,本模型在生成真实性与多样性方面均超越现有技术,尤其对于复杂文本描述场景具有显著优势。

AvatarGPT: All-in-One Framework for Motion Understanding, Planning, Generation and Beyond

大型语言模型(LLM)在统一几乎所有自然语言处理任务方面展现出卓越的涌现能力。然而在与人体运动相关的研究领域,学者们仍在为每个任务开发孤立模型。受InstructGPT[16]与Gato[27]通用智能理念的启发,我们提出AvatarGPT——一个集运动理解、规划、生成以及中间帧合成等任务于一体的全能框架。该框架将各类任务视为基于共享大语言模型进行指令微调的不同变体,所有任务通过语言这一通用接口无缝衔接,形成闭环系统。

具体实现包含三个关键步骤:首先将人体运动序列编码为离散标记,作为大语言模型的扩展词汇表;随后开发无监督流程,从真实场景视频中自动生成人体动作序列的自然语言描述;最终进行多任务联合训练。大量实验表明,AvatarGPT在底层任务上达到顶尖水平,在高层任务中亦展现出良好性能,验证了所提一体化框架的有效性。更值得注意的是,AvatarGPT首次通过闭环系统内任务的迭代遍历,实现了无限长序列运动合成的理论突破。项目主页:https://zixiangzhou916.github.io/AvatarGPT/

MotionGPT: Human Motion as a Foreign Language

尽管预训练大语言模型不断发展,但如何构建一个能够统一处理语言与运动等多模态数据的模型至今仍是一个尚未探索的挑战性课题。值得庆幸的是,人类运动与人类语言具有相似的语义耦合特性,常被视为一种身体语言形式。通过将语言数据与大规模运动模型相融合,能够提升运动相关任务性能的运动-语言预训练技术已成为可能。受此启发,我们提出MotionGPT——一个统一、通用且用户友好的运动语言模型,用于处理多种运动相关任务。具体而言,我们采用离散向量量化技术将人体运动转化为运动标记,其生成过程类似于文本标记的生成。基于该"运动词汇表",我们以统一的方式对运动和文本进行语言建模,将人体运动视为特殊形式的语言。此外受提示学习启发,我们采用运动-语言混合数据对MotionGPT进行预训练,并基于提示问答任务进行微调。大量实验表明,MotionGPT在文本驱动运动生成、运动描述、运动预测及运动补全等多个任务上均达到了领先水平。

Action-GPT: Leveraging Large-scale Language Models for Improved and Generalized Action Generation

本文提出Action-GPT——一种即插即用框架,旨在将大语言模型(LLM)融入基于文本的动作生成模型。当前运动捕捉数据集中的动作短语通常只包含最精简的核心信息。通过为大语言模型精心设计提示模板,我们能够生成更丰富、更细粒度的动作描述。研究证明,使用这些详细描述替代原始动作短语可有效提升文本空间与动作空间的对齐效果。我们提出了一种通用方法,可同时兼容随机性(如基于VAE)与确定性(如MotionCLIP)的文生动作模型,并支持使用多个文本描述进行生成。实验结果表明:(1)合成动作质量在定性与定量评估中均有显著提升;(2)使用多个LLM生成描述具有增益效应;(3)提示函数设计合理有效;(4)所提方法具备零样本生成能力。相关代码、预训练模型及示例视频将发布于https://actiongpt.github.io。

PoseGPT: Quantization-based 3D Human Motion Generation and Forecasting

本文研究动作条件引导下的人体运动序列生成问题。现有研究主要分为两类:基于观测历史运动的预测模型,或仅依赖动作标签与时长的生成模型。与此不同,我们实现了任意观测长度(包括零观测)条件下的运动生成。针对这一广义问题,我们提出PoseGPT——一种基于自回归变换器的模型,其内部通过量化潜在序列对人体运动进行压缩编码。我们首先通过自编码器将人体运动映射至离散空间的潜在索引序列,并实现反向重构。受生成式预训练变换器(GPT)启发,我们训练了适用于该离散空间的类GPT模型进行索引预测,使PoseGPT能够输出未来运动的概率分布,且无需依赖历史运动观测。潜在序列的离散压缩特性使类GPT模型能聚焦长期运动特征,有效消除输入信号中的低频冗余。离散索引预测还规避了连续值回归中常见的“平均姿态”预测陷阱——因为离散目标的平均值本身并非有效目标。实验结果表明,我们所提方法在HumanAct12(标准小规模数据集)、BABEL(新兴大规模运动捕捉数据集)及GRAB(人物交互数据集)上均达到了最先进水平。

Incorporating Physics Principles for Precise Human Motion Prediction

众多现实应用都依赖于基于历史观察数据对三维人体运动进行精确预测。虽然现有方法已取得显著进展,但其在亚秒级时间跨度内的预测误差仍可能达到数厘米级别。本文提出,要实现精确的人体运动预测,必须深入理解支配人体运动的基础物理原理。我们创新性地引入了PhysMoP——一个融合物理原理的人体运动预测框架。该框架通过求解欧拉-拉格朗日方程(一组描述物理运动规律的常微分方程)来估计下一帧的人体姿态。为缓解随时间累积的固有误差问题,PhysMoP采用数据驱动模型,并通过融合模块对基于物理的预测进行迭代修正。大量实验表明,PhysMoP在亚秒级预测区间内显著优于现有方法。例如在80毫秒的预测区间上,PhysMoP相较传统数据驱动方法的误差降低幅度达到10倍以上。

PIMNet: Physics-infused Neural Network for Human Motion Prediction

摘要:人体运动预测(HMP)旨在根据历史姿态序列预测未来人体姿态序列。近年来,该技术在计算机视觉和机器人领域备受关注,因其能帮助机器理解人类行为、规划目标动作并优化交互策略。现有HMP方法主要基于纯物理模型或统计模型,但二者均存在局限性:物理模型计算复杂且易产生误差,统计方法则需要大量数据且缺乏物理一致性。为克服这些缺陷,我们提出一种物理融合神经网络(PIMNet),将物理模型与统计方法相结合。我们首先通过基于物理的人体动力学模型计算每个姿态的接触力与关节力矩,随后将其输入编码器-解码器机器学习架构中以预测未来运动。该方法使PIMNet同时具备计算高效性与物理一致性。在Human 3.6M数据集上的大量实验表明,所提出的PIMNet在短期和长期预测中均能准确预测人体运动。即使采用基础LSTM作为机器学习模型,其预测精度仍达到或超越了最先进水平。

PhysDiff: Physics-Guided Human Motion Diffusion Model

去噪扩散模型在生成多样且逼真的人体动作方面前景广阔。然而,现有动作扩散模型在生成过程中普遍忽略物理规律,常产生存在明显物理异常的动作——如身体漂浮、脚步滑动、地面穿透等问题。这不仅严重影响生成动作的质量,更限制了其在实际场景中的应用。为解决这一难题,我们提出了一种新型物理引导动作扩散模型(PhysDiff),将物理约束融入扩散过程。具体而言,我们设计了一个基于物理的动作投影模块,通过物理仿真器中的动作模拟,将每个扩散步骤去噪后的动作投影至符合物理规律的状态。经物理修正的动作将在后续扩散步骤中引导去噪过程。从机理上看,这种物理机制的引入能持续将动作迭代牵引至物理合理的空间,这是传统后处理方法无法实现的。基于大规模人体动作数据集的实验表明,我们的方法在动作质量上达到最优水平,并将物理合理性全面提升(所有数据集提升幅度>78%)。

NRDF: Neural Riemannian Distance Fields for Learning Articulated Pose Priors

对关节空间进行精确建模是一项关键任务,它既能实现真实姿态的恢复与生成,也始终是公认的难题。为此,我们提出了神经黎曼距离场(NRDF)——一种数据驱动的先验模型,通过高维四元数积空间中的神经场零水平集来表征合理关节空间。为仅基于正样本训练NRDF,我们提出一种新型采样算法,确保测地距离遵循目标分布,从而构建理论严密的距离场学习范式。继而设计投影算法,通过自适应步长黎曼优化器将任意随机姿态映射至水平集,并始终遵循关节旋转构成的产品流形。NRDF可通过反向传播计算黎曼梯度,通过数学类比与新兴生成模型黎曼流匹配建立理论关联。我们在姿态生成、图像姿态估计和逆运动学求解等多类下游任务中,对NRDF与其他姿态先验模型展开系统评估,结果凸显了NRDF的卓越性能。除人体姿态外,NRDF的通用性更延伸至手部与动物关节建模,因其能有效表征任意关节系统。

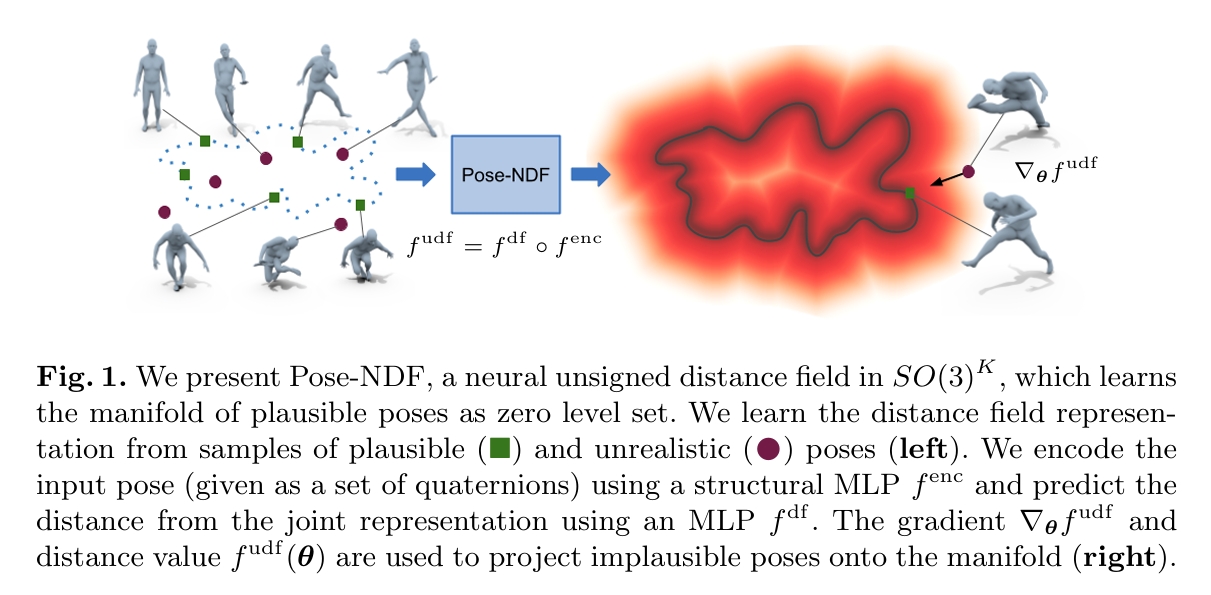

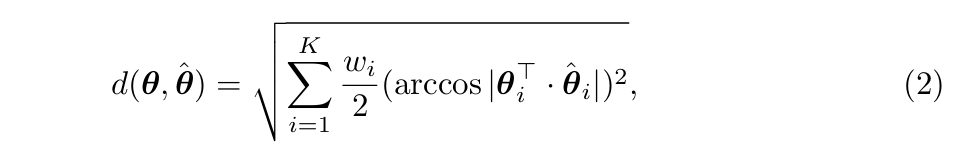

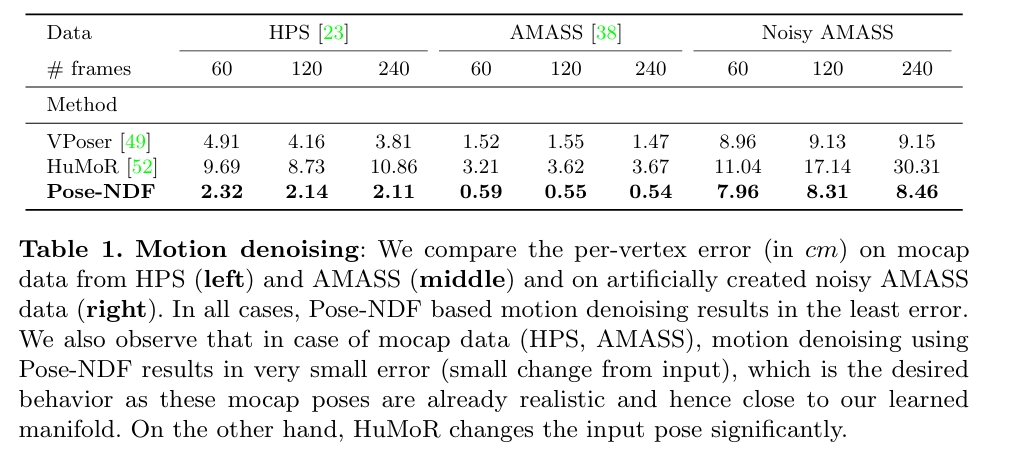

Pose-NDF: Modeling Human Pose Manifolds with Neural Distance Fields

本文提出Pose-NDF——一种基于神经距离场(NDF)的连续型人体姿态概率模型。姿态或运动先验对于生成真实的新姿态,以及从含噪声或局部观测数据中重建精确姿态至关重要。Pose-NDF通过神经隐函数的零水平集学习合理姿态流形,将三维隐式曲面建模思想拓展至高维空间SO(3)^K(人体姿态由K个四元组构成的单数据点定义)。所得高维隐函数可对输入姿态求导,从而通过在三维超球面上执行梯度下降,将任意姿态投影至该流形。与现有基于VAE、将姿态空间转换为高斯分布的方法不同,本方法直接建模真实姿态流形并保持姿态间距离。实验表明,在去噪真实动作捕捉数据、遮挡姿态恢复、图像至三维姿态重建等下游任务中,Pose-NDF作为先验模型均优于当前最优方法。此外,通过随机采样与投影,本方法能比基于VAE的方法生成更多样化的姿态。我们将公开代码与预训练模型以供进一步研究,详见https://virtualhumans.mpi-inf.mpg.de/posendf/。

主要方法

数据定义

θ = {θ1, ..., θK}

其中θk是每个关节在其父坐标系下的四元数表达

距离定义

训练

---

title: NDF训练过程

---

flowchart LR

θ[("动作数据")]

noise["add noise"]

θ1..k(["每个关节的动作数据"])

hat_θ(["加噪数据"])

d_gt(["d_gt"])

v1..k(["关节1..k Latent Code"])

d(["Unsigned Distance"])

Loss(["Loss"])

θ --> noise --> hat_θ

hat_θ --> θ1..k -->Encoder1..k --> v1..k --> MLP --> d

θ & hat_θ --> 动作距离公式 --> d_gt

d & d_gt --> Loss

Loss e1@-->Encoder1..k

Loss e2@-->MLP

e1@{ animation: fast }

e2@{ animation: fast }

优化

---

title: 基于NDF的推断过程

---

flowchart LR

θ[("动作数据")]

θ1..k(["每个关节的动作数据"])

v1..k(["关节1..k Latent Code"])

d(["Unsigned Distance"])

θ --> θ1..k -->Encoder1..k --> v1..k --> MLP --> d

d e1@-->θ

e1@{ animation: fast }

效果

Geometric Neural Distance Fields for Learning Human Motion Priors

我们提出神经黎曼运动场(NRMF)——一种创新的三维生成式人体运动先验模型,能够实现鲁棒、时序一致且物理合理的三维运动重建。与现有的VAE或扩散模型方法不同,我们提出的高阶运动先验显式地将人体运动建模为对应姿态、转移(速度)和加速度动态的神经距离场(NDF)零水平集。该框架具有严谨的理论基础:我们的NDF构建在关节旋转、角速度及角加速度的乘积空间上,严格遵循底层关节结构的几何特性。我们进一步引入:(1)一种新型自适应步长混合算法,用于在合理运动集合上进行投影计算;(2)一种创新几何积分器,在测试时优化和生成过程中实现真实运动轨迹的"展开"。实验结果表明显著且一致的性能提升:在AMASS数据集上训练后,NRMF能够出色地泛化至多种输入模态,并适应去噪、运动插值、基于部分二维/三维观测的运动拟合等多样化任务。项目页面详见此处。

神经黎曼运动场

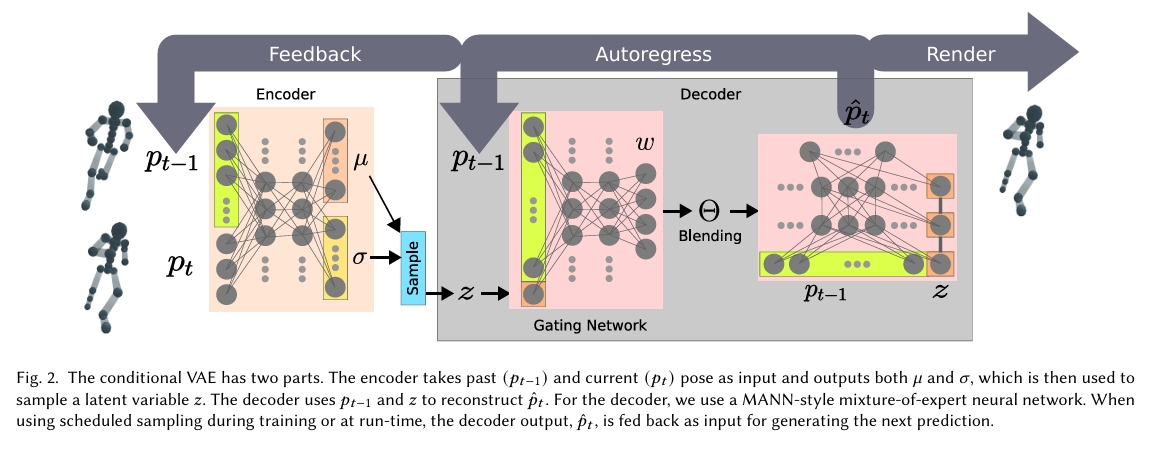

Character Controllers Using Motion VAEs

计算机动画的一个基本问题是,在给定足够丰富的运动捕捉片段集合的情况下,如何实现有目的性且逼真的人体运动。我们采用自回归条件变分自编码器(即运动VAE)来学习数据驱动的人体运动生成模型。经过学习的自编码器其潜在变量定义了运动的动作空间,从而控制运动随时间推移的演变。规划或控制算法随后可利用该动作空间来生成期望的运动。特别地,我们运用深度强化学习来训练能够实现目标导向运动的控制器。我们通过多项任务验证了该方法的有效性,进一步评估了系统设计的不同方案,并阐述了当前运动VAE存在的局限性。

构造先验

采用自回归条件变分自编码器(即运动VAE)来学习数据驱动的人体运动模型,作为后续生成模型的先验。

规避后验坍塌。

- 可以使用单帧姿态作为条件输入,也可采用连续历史姿态序列(即𝑝𝑡−𝑘...𝑝𝑡−1)作为条件。

实验结论:使用多帧条件能提升MVAE的重构质量,但会降低输出姿态的多样性。极端情况下,解码器可能学会忽略编码器输出,即出现后验坍塌问题。 - 后验坍塌问题是指,解码器忽略编码器输出,仅复现原始运动捕捉数据。

解决方法:

(1)使用较少的历史帧作为条件。实验表明,采用一至两帧连续姿态作为条件即可获得良好效果,但最优选择通常需综合考虑运动数据库的多样性与质量。

(2)将潜变量z输入专家网络的所有层级来强化其重要性。实证研究表明该技巧能有效降低后验坍塌的发生概率。

(3)其他影响后验坍塌概率的设计决策包括:解码器网络规模、KL散度损失的权重(在𝛽-VAE中)以及潜维度数量。

运动质量与泛化能力的平衡

- 平衡源自重构损失与KL散度损失的权重分配

(1)过度侧重运动质量时,系统仅会复现原始运动捕捉序列

(2)若过度强调运动泛化,则可能生成不符合物理规律的动作姿态

实验表明:当MVAE的重构损失与KL散度损失在收敛时保持同一数量级,即可作为衡量质量与泛化间适当平衡的有效指标。

自回归的预测失稳问题

问题原因:不断累积的重构误差会迅速导致模型进入状态空间中不可恢复的新区域

解决方法:计划采样技术

具体方法:为每个训练周期定义采样概率𝑝,当完成姿态预测后,以1−𝑝的概率将预测结果作为下一时间步的输入(而非使用训练数据中的真实姿态)。整个训练过程包含三个模式:监督学习模式(𝑝=1)、计划采样模式(𝑝值衰减)和自回归预测模式(𝑝=0)。

训练片断

使用T帧作为一个训练片断,T帧的切割方式有两种:

(1)任何帧都可被视为序列的起始或结束姿态,切割方法:运动片段被自由划分为等长子序

(2)需要固定起止姿态的特定运动,切割方法:通过填充序列至最长序列长度来处理变长输入

语言都是用第二种,动作通常用第一种。

基于先验的生成

随机生成

控制条件:无

生成方式:自回归

表示方式:连续表示(VAE)

生成模型:VAE

以单帧输入作为起始帧,随机采样下一帧,可以生成以下效果的运动:

- 当初始角色状态取自短跑周期的中间帧时,MVAE将持续重构短跑周期动作;

- 当初始状态为静止姿态(多数运动片段的起始通用姿态)时,角色可自然过渡到行走、奔跑、跳跃或静止等不同运动模式。

当随机行走在大量采样后仍无法实现运动过渡时,就意味着需要补充额外的运动捕捉数据(特别是过渡动作)

可控生成

控制条件:目标位置

生成方式:自回归

表示方式:连续表示(VAE)

生成模型:VAE

方法

在固定时间步长(𝐻)内执行多次蒙特卡洛推演(𝑁),从所有采样轨迹中选取最优路径的首个动作作为当前时间步的角色控制指令,该过程循环执行直至任务完成或终止。

效果

- 在简单运动任务(如目标追踪§6.1)中表现尚可。

- 当采用𝑁=200、𝐻=4参数时,角色通常能朝向目标移动并绕其盘旋,同时适应目标位置的突变(详见补充视频)。

局限性

- 难以引导角色抵达目标两英尺范围内。

- 对于更复杂的任务无法达成预期目标。

- 需要精细调参。

- 需要更高的运行时计算量。

动作先验与强化学习

[?] 这一部分没有看懂

Improving Human Motion Plausibility with Body Momentum

许多研究将人体运动分解为附着在根关节上的局部坐标系中的局部运动,以及世界坐标系中根关节的全局运动,并对二者分别处理。然而这两个组成部分并非相互独立:全局运动源于与环境的相互作用,而环境交互又是由身体姿态的变化驱动的。运动模型往往无法精确捕捉局部与全局动力学之间的这种物理耦合关系,而从关节扭矩和外部力推导全局轨迹又存在计算成本高、复杂度大的问题。为解决这些挑战,我们提出使用全身线性和角动量作为约束条件,将局部运动与全局运动联系起来。由于动量反映了关节层面动力学对身体空间运动的整体影响,它提供了将局部关节行为与全局位移相关联的物理基础方法。基于这一见解,我们引入了一种新的损失项,用于强制生成动量曲线与真实数据中观测到的动量曲线保持一致。采用我们的损失函数可减少脚部滑动和抖动,改善平衡性,并保持恢复运动的准确性。代码与数据详见项目页面https://hlinhn.github.io/momentum_bmvc。

MoGlow: Probabilistic and controllable motion synthesis using normalising flows

基于数据的运动建模与合成是一个活跃的研究领域,其在动画、游戏和社交机器人等领域具有广泛应用。本文提出了一类基于归一化流的新型概率化、生成式且可控的运动数据模型。此类模型能够描述高度复杂的分布,且与生成对抗网络(GAN)或变分自编码器(VAE)不同,它可以通过精确的最大似然估计进行高效训练。我们提出的模型采用自回归结构,并利用长短期记忆网络(LSTM)实现任意长的时间依赖性。重要的是,该模型具有因果性,即输出序列中的每个姿态生成时均不依赖未来时间步的姿态或控制输入;这种零算法延迟的特性对于需要实时运动控制的交互应用至关重要。该方法原则上可适用于任何运动类型,因为它不对运动特征或角色形态施加限制性的任务特定假设。我们在人类和四足动物运动的动作捕捉数据集上评估了模型性能。主客观实验结果均表明,本方法随机采样的运动效果优于任务无关的基线模型,其运动质量接近录制的动作捕捉数据。

Modi: Unconditional motion synthesis from diverse data

神经网络的出现彻底改变了运动合成领域。然而,学习从给定分布中无条件合成运动仍然具有挑战性,尤其是在运动高度多样化的情况下。本研究提出MoDi——一种在无监督设置下,从极其多样化、非结构化和无标签的数据集中训练得到的生成模型。在推理过程中,MoDi能够合成高质量、多样化的运动。尽管数据集缺乏任何结构,我们的模型仍能产生规整且高度结构化的潜空间,该空间可进行语义聚类,构成强大的运动先验,有助于实现语义编辑和群组模拟等多种应用。此外,我们提出一种编码器,可将真实运动映射到MoDi的自然运动流形中,为解决前缀补全和空间编辑等不适定问题提供解决方案。定性与定量实验均达到领先水平,超越了近年来的SOTA技术。代码和训练模型详见https://sigalraab.github.io/MoDi。

MotionDiffuse: Text-Driven Human Motion Generation with Diffusion Model

核心问题是什么?

直接基于自然语言生成人体运动

现有方法及局限性

如何根据多样化文本输入实现细腻且精细的运动生成仍具挑战性。

本文方法及优势

MotionDiffuse——首个基于扩散模型的文本驱动运动生成框架,其展现出超越现有方法的三大特性:

1)概率性映射。通过注入变异的多步去噪过程生成运动,取代确定性语言-运动映射;

2)真实合成。擅长复杂数据分布建模并生成生动运动序列;

3)多级操控。支持身体部位的细粒度指令响应,以及基于时变文本提示的任意长度运动合成。

实验表明MotionDiffuse在文本驱动运动生成和动作条件运动生成方面显著优于现有SoTA方法。定性分析进一步证明框架在综合运动生成方面的强大可控性。项目主页:https://mingyuan-zhang.github.io/projects/MotionDiffuse.html

方法

实验

KIT-ML, HumanML3D

效果SOTA

A deep learning framework for character motion synthesis and editing

核心问题是什么?

开创了Deep Learning Based运动生成的先河

大致方法

第一步:Building the Motion Manifold

| 输入 | 输出 | 方法 |

|---|---|---|

| 动作数据,T*D1 | latent data,T*D2(256) | 一维(时间维度)卷积 Based Encoder |

| latent data,T*D2(256) | 重建动作数据,T*D1 | 一维(时间维度)卷积 Based Decoder |

| 动作数据 重建动作数据 网络参数 | Loss | L2 Loss + L1正则化 |

关键创新:Max Pooling。实验表明Max Pooling对结果起到了较大的提升作用。

---

title: Building the Motion Manifold

---

flowchart LR

Input[("动作数据")]

Encoder

Latent(["Latent Code"])

Decoder

Output(["Output"])

Loss(["Loss"])

Input-->Encoder-->Latent-->Decoder-->Output

Input & Output --> Loss

Loss e1@-->Encoder

Loss e2@-->Decoder

e1@{ animation: fast }

e2@{ animation: fast }

第二步:Mapping High Level Parameters to Human Motions

| 输入 | 输出 | 方法 |

|---|---|---|

| 高级控制参数,例如轨迹 frequency | 触地信息,T * 4 | 正弦函数 |

| 高级控制参数,例如轨迹 触地信息,T * 4 | latent data,T*D2(256) | 卷积based网络 |

| latent data,T*D2(256) | 重建动作数据,T*D1 | 一维(时间维度)卷积 Based Decoder,fixed |

| 重建动作数据 GT | Loss |

---

title: Mapping High Level Parameters to Human Motions

---

flowchart LR

Input[("控制信息")]

NN["input curve T -> parameters"]

Wave(["Wave Parameters"])

SquareWaves["square waves"]

F(["触地信息"])

FF["Feedforward Network"]

Latent(["Latent Code"])

Decoder

Output(["Output"])

GT[("GT")]

Loss(["Loss"])

Input-->NN-->Wave-->SquareWaves-->F

Input & F --> FF --> Latent-->Decoder-->Output

Output & GT --> Loss

Loss e1@-->FF

e1@{ animation: fast }

应用

Applying Constraints in Hidden Unit Space

---

title: Applying Constraints in Hidden Unit Space

---

flowchart LR

Init(["初始Lantet Motion"])

Decoder

Output(["Output"])

Constrain[("约束")]

Loss(["Loss"])

Init-->Decoder-->Output

Output & Constrain --> Loss

Loss e1@-->Init

e1@{ animation: fast }

Motion Stylization in Hidden Unit Space

---

title: Motion Stylization in Hidden Unit Space

---

flowchart LR

Init(["初始Lantet Motion"])

Style[("风格条件")]

Content[("内容条件")]

LatentContent(["latent内容条件"])

LatentStyle(["latent风格条件"])

GMStyle(["输入风格的Gram matrix"])

GMMotion(["当前Motion风格的Gram matrix"])

LossContent(["内容Loss"])

LossStyle(["风格Loss"])

Loss(["Loss"])

Encoder1["Encoder"]

Encoder2["Encoder"]

GM1["计算Gram Matrix"]

GM2["计算Gram Matrix"]

Content --> Encoder1 --> LatentContent

Style --> Encoder2 --> LatentStyle

Init & LatentContent --> LossContent

Init --> GM1 --> GMMotion--> LossStyle

LatentStyle --> GM2 --> GMStyle --> LossStyle

LossContent & LossStyle --> Loss

Loss e1@-->Init

e1@{ animation: fast }

实验

数据集

- CMU

- 自采数据 + 重定向

数据预处理流程

-

时序标准化:统一降采样至60FPS保证时序一致性

-

空间表征转换:将关节角度表示→3D关节位置(局部坐标系)

-

坐标系构建:以根关节地面投影为原点,通过肩/臀部向量计算前进方向(Z轴)

-

运动学参数增强:添加全局速度(XZ平面)、旋转速度(Y轴)和足部接触标签

-

数据归一化:减去均值/除以标准差(分别处理姿态、速度、接触标签)

总结

核心价值:第一篇基于AI的3D骨骼动作生成工作

成本分析:需要特定角色的大量数据

落地瓶颈:需要特定角色的大量数据,生成动作也只能用于特定角色,没有角色之间的泛化性。

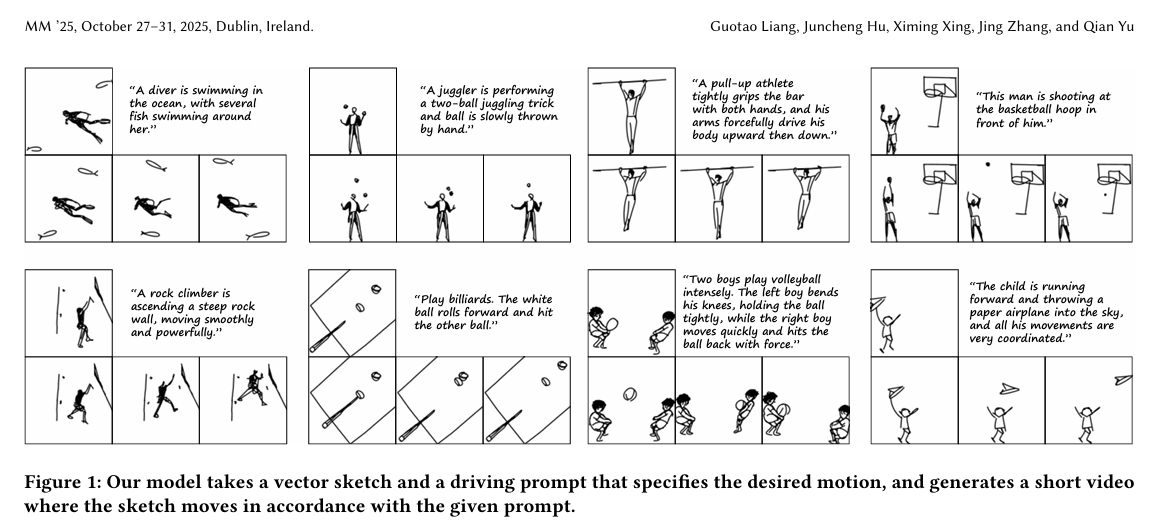

Multi-Object Sketch Animation with Grouping and Motion Trajectory Priors

核心问题是什么?

矢量草图动画,能处理多对象交互和复杂运动

现有方法及局限性

现有方法难以应对这些场景,要么仅限于单对象情况,要么存在时间不一致和泛化能力差的问题。

本文方法及优势

GroupSketch采用包含运动初始化和运动优化的两阶段流程:

第一阶段通过交互式将输入草图划分为语义组并定义关键帧,通过插值生成粗粒度动画;

第二阶段提出基于组的位移网络(GDN),利用文本-视频模型的先验知识预测组别位移场以优化粗动画。GDN还整合了上下文条件特征增强(CCFE)等专用模块来提升时间一致性。

大量实验表明,本方法在为复杂多对象草图生成高质量、时间一致的动画方面显著优于现有方法,从而拓展了草图动画的实际应用。

参考材料

https://hjc-owo.github.io/GroupSketchProject/

TRACE: Learning 3D Gaussian Physical Dynamics from Multi-view Videos

核心问题是什么?

输入:动态多视角视频,及每个视角的相机参数,无需其它任何人工标注

输出:

- 建模三维场景的几何、外观

- 估计场景中对象的物理信息

- 基于物理信息预测续写视频

现有方法及局限性

现有工作通常通过将基于物理的损失作为软约束或将简单物理模型集成到神经网络中来实现,但往往难以学习复杂的运动物理规律,或者需要额外的标注(如物体类型或遮罩)。

本文方法及优势

我们提出了一个名为 TRACE 的新框架来建模复杂动态三维场景的运动物理规律:

- 将每个三维点建模为空间中具有大小和方向的刚性粒子

- 直接为每个粒子学习一个平动-旋转动力学系统,显式地估算出一整套物理参数来控制粒子随时间的运动。

在三个现有动态数据集和一个新创建的具有挑战性的合成数据集上进行的大量实验表明,我们的方法在未来帧外推任务中相对于基线模型具有卓越的性能。我们框架的一个优良特性是,只需对学习到的物理参数进行聚类,即可轻松分割多个物体或部件。我们的数据集和代码可在 https://github.com/vLAR-group/TRACE 获取。

主要方法

输入:具有已知相机位姿和内参的动态多视角RGB视频

三维场景表示模块旨在学习一组三维高斯核,用于在规范空间中表示三维场景的几何和外观

辅助变形场旨在根据当前训练时间t预测每个高斯核的位移和畸变

平动-旋转动力学系统旨在为每个三维刚性粒子学习一组物理参数,以控制其随时间变化的运动动力学

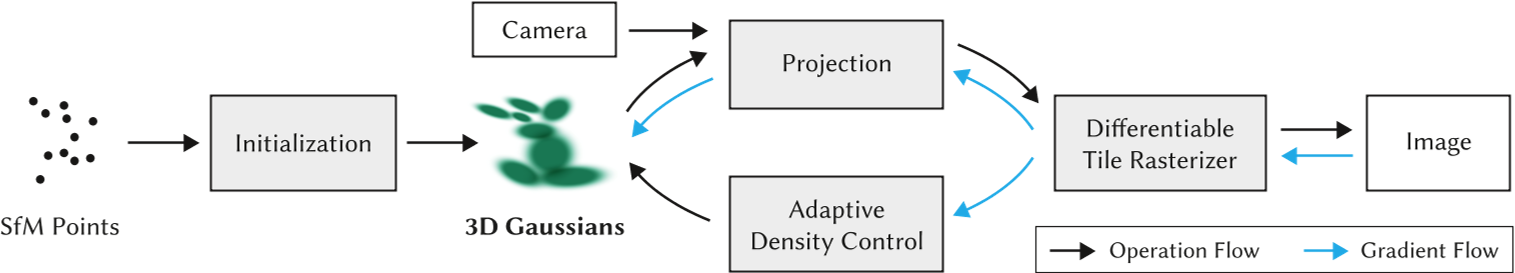

Canonical 3D Gaussians

准备

输入:t=0时刻的N个视角的图像、N个视角的相机参数

假设每个高斯核的不透明度 σ 和颜色 c 不会随时间更新

三维高斯核 G₀的表征:

- 三维位置 x₀

- 由四元数 r₀ 和缩放 s₀ 导出的协方差矩阵

- 不透明度 σ

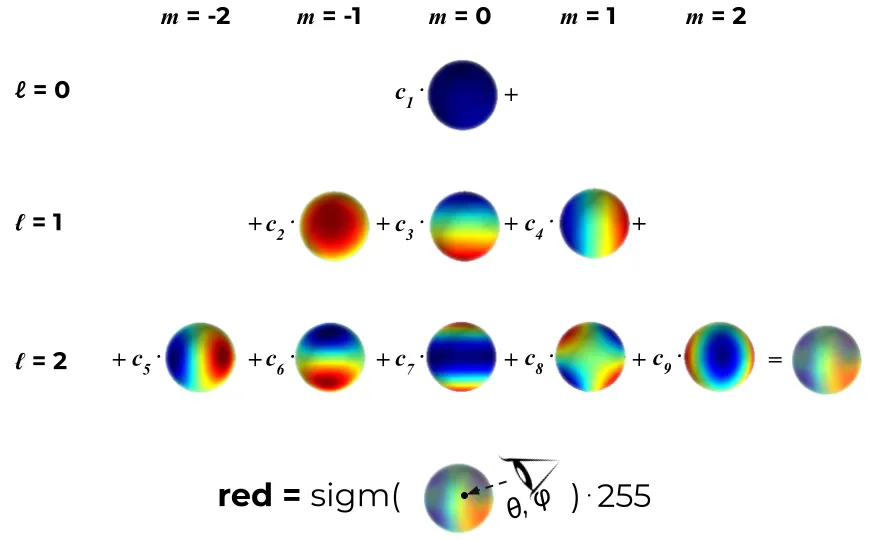

- 由球谐函数计算的颜色 c 初始化:随机初始化或SfM初始化

优化过程

将高斯核投影到相机空间

将投影后的高斯核渲染到图像空间

通过 3DGS 中使用的 ℓ₁ 损失和 ℓₛₛᵢₘ 损失优化所有核参数

辅助变形场

它是一个基于 MLP 的网络。

输入是规范位置 x₀ 和时间 t。

输出是几何变化量 (δx, δr, δs),用于将规范高斯核 G₀ 扭曲到时间 t 的状态 Gₜ。

xₜ = x₀ + δx,

rₜ = r₀ ◦ δr,

sₜ = s₀ ⊙ δs,

σ, c(保持不变)

平动-旋转动力学系统

将复杂场景离散化为刚性粒子(即高斯核),并聚焦于学习每个粒子的独立动力学。

依据经典力学,将每个粒子的运动分解为绕一个运动的旋转中心进行的转动,同时该旋转中心自身也在平动。

模块输出: 为每个粒子学习两组物理参数 参数组 #1 - 旋转中心参数: 包括:

- 中心位置 P_c ∈ R³,

- 中心速度 v_c ∈ R³,

- 中心加速度 a_c ∈ R³(在世界坐标系下)。

旋转中心可以是任意位置,不一定是粒子所在的位置

参数组 #2 - 刚性粒子旋转参数: 包括:

- 刚性粒子相对于其旋转中心 P_c 的旋转矢量 w_p ∈ R³,

- 刚性粒子的角加速度 ϵ_p ∈ R³。

通过两组参数,得出粒子的合成速度为:

由于在网络推断的过程中 P_c 和 V_c 难以解耦,把 P_c 和 V_c 合并成 \(\bar v_c^t\)

因此MLP的实际输入输出为:

仅需在某个特定时间 t 学习一次这个完整的平动-旋转动力学系统,随后该粒子的未来运动将由学习到的动力学系统根据力学定律来支配。

训练

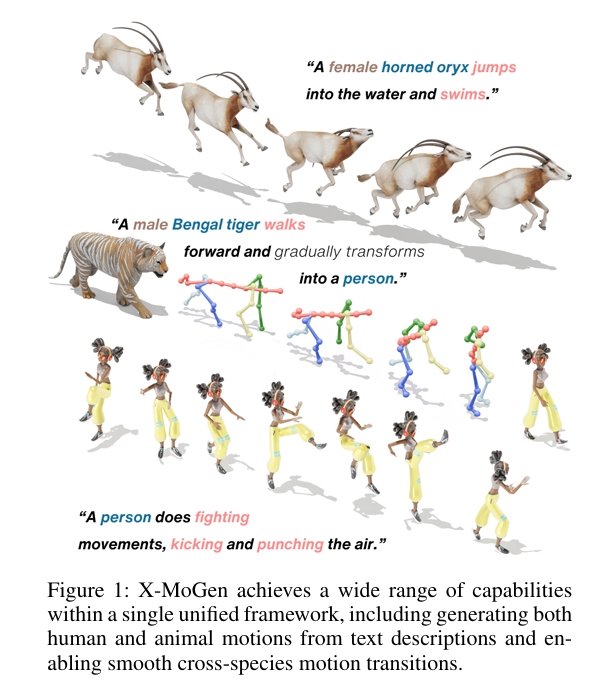

X-MoGen: Unified Motion Generation across Humans and Animals

核心问题是什么?

文生人类动作和动物动作

现有方法及局限性

- 分别建模人类与动物动作

- 联合跨物种方法具备统一表征与更强泛化性等关键优势,但由于物种间形态差异,常导致动作失真。

本文方法及优势

X-MoGen:首个覆盖人类与动物的统一跨物种文本驱动动作生成框架。

第一阶段:条件图变分自编码器学习规范T姿态先验,同时自编码器将动作编码至由形态学损失正则化的共享潜空间;

第二阶段:通过掩码动作建模生成基于文本描述的动作嵌入。

训练中采用形态一致性模块保障跨物种骨骼合理性。为支持统一建模,我们构建了包含115个物种、11.9万动作序列的大规模数据集UniMo4D,在共享骨骼拓扑下整合人/动物动作进行联合训练。UniMo4D上的大量实验表明,X-MoGen在已知/未知物种上均超越现有最优方法。

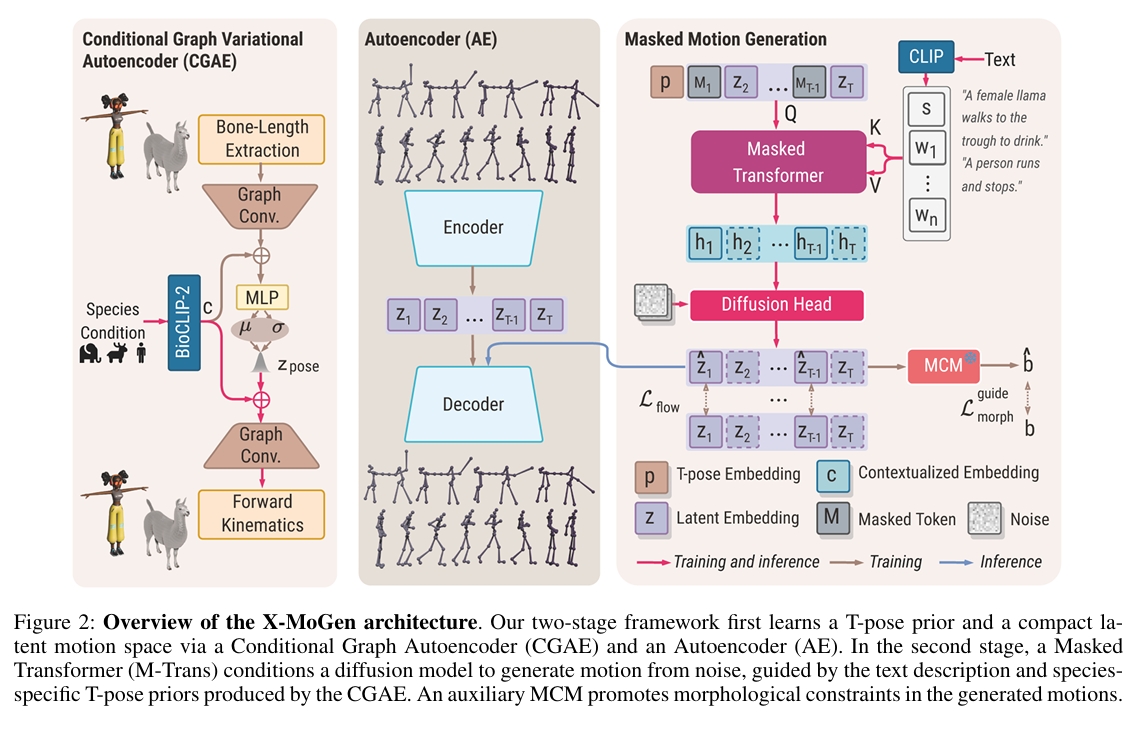

主要方法

图2:X-MoGen架构概览 我们的两阶段框架首先通过条件图自编码器(CGAE) 和自编码器(AE) 学习T姿态先验与紧凑动作潜空间。第二阶段中,掩码Transformer(M-Trans) 引导扩散模型从噪声生成动作,该过程以文本描述及CGAE生成的物种特定T姿态先验为条件。辅助的形态一致性模块(MCM) 对生成动作施加形态学约束。

Stage 1: Feature Modeling

T-pose Modeling via CGAE

[?]

- 本文要求所有物理的骨骼拓扑是一一致的。只是长度的朝向的差异。

- CGAE中只编码了骨骼长度的信息,怎么约束朝向信息呢?

- CGAE中的BioCLIP-2部分只对一个物种信息编码,怎么实现跨物种的效果?

Motion Representation via AE

[?] 这里为什么是AE而不是VAE

Stage 2: Masked Motion Generation

Masked Motion Modeling

Diffusion-based Completion Head

[?]为什么需要输入T-pose Embedding?Latent Embedding足以恢复信息。 [?]蒙皮权重与Mesh的影响不考虑进去?

Morphological Consistency Module

- MCM是怎么做的?从哪里获取角度极限的信息?

- MCM是什么时候训练的?

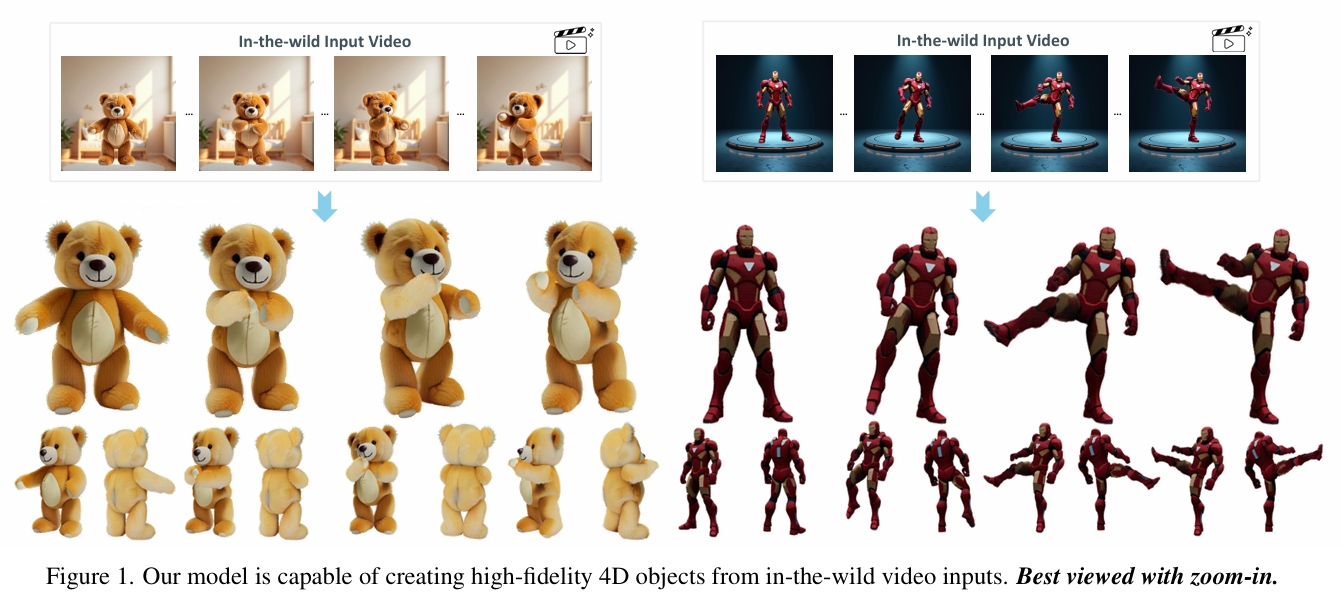

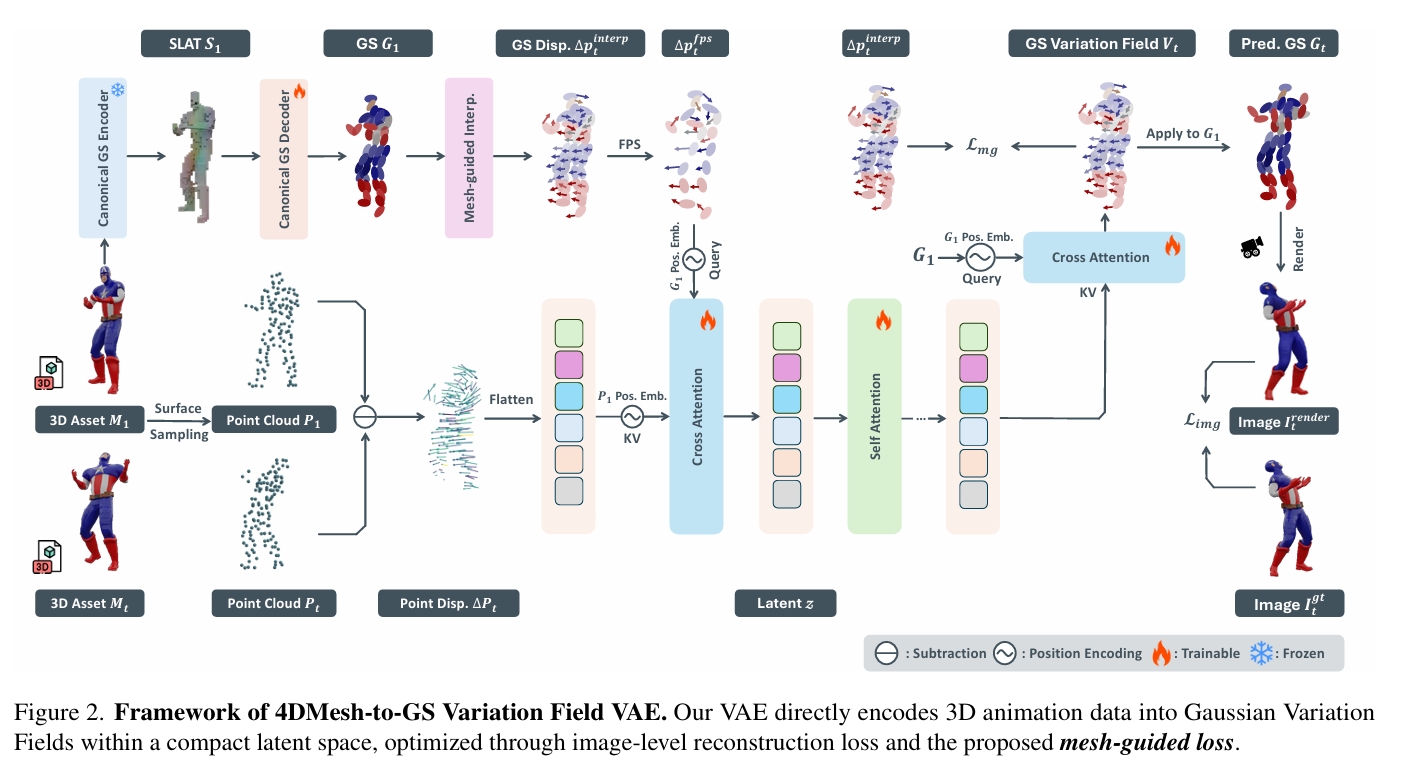

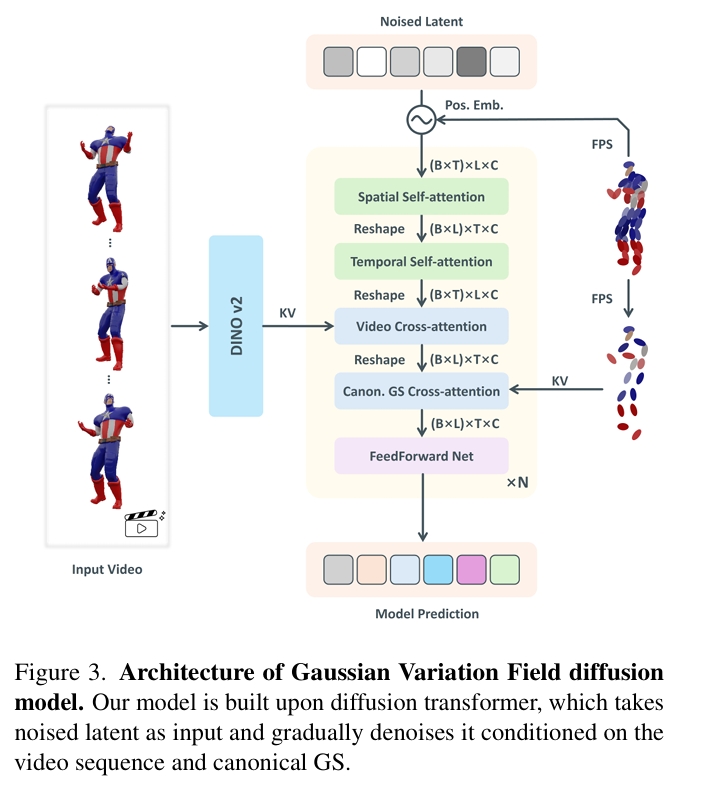

Gaussian Variation Field Diffusion for High-fidelity Video-to-4D Synthesis

核心问题是什么?

视频到4D生成框架,可从单段视频输入中创建高质量动态3D内容。

现有方法及局限性

直接进行4D扩散建模因数据构建成本高昂,且需联合表征3D形状、外观与运动的高维特性而极具挑战性。

本文方法及优势

直接4D网格-高斯场变分自编码器(Direct 4DMesh-to-GS Variation Field VAE):无需逐实例拟合,直接从3D动画数据中编码规范高斯溅射点(GS)及其时序变化,将高维动画压缩至紧凑潜空间。

高斯变分场扩散模型:该模型采用时序感知型扩散Transformer架构,以输入视频和规范GS作为条件。

通过在Objaverse数据集精选的可动画3D对象上训练,本模型相较现有方法展现出更优的生成质量。尽管仅使用合成数据训练,其对真实场景视频输入仍表现出卓越的泛化能力,为高质量动态3D内容生成开辟了新路径。项目页面:GVFDiffusion.github.io。

主要方法

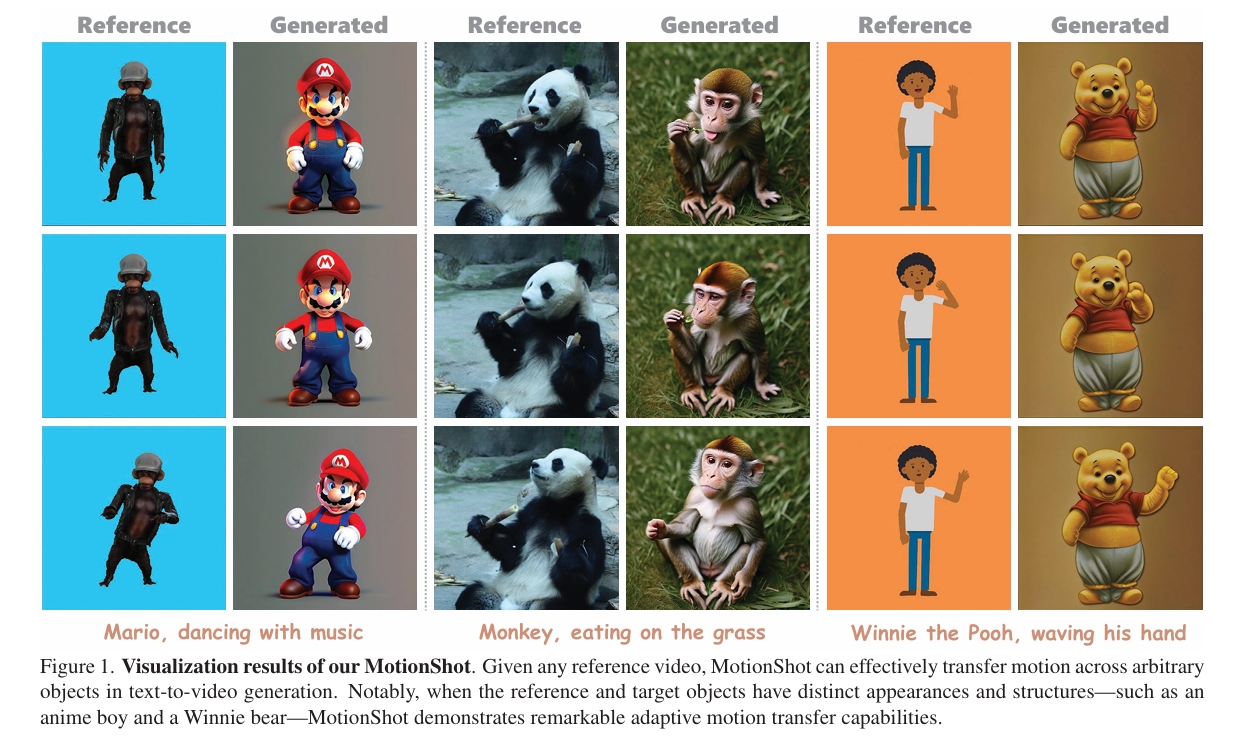

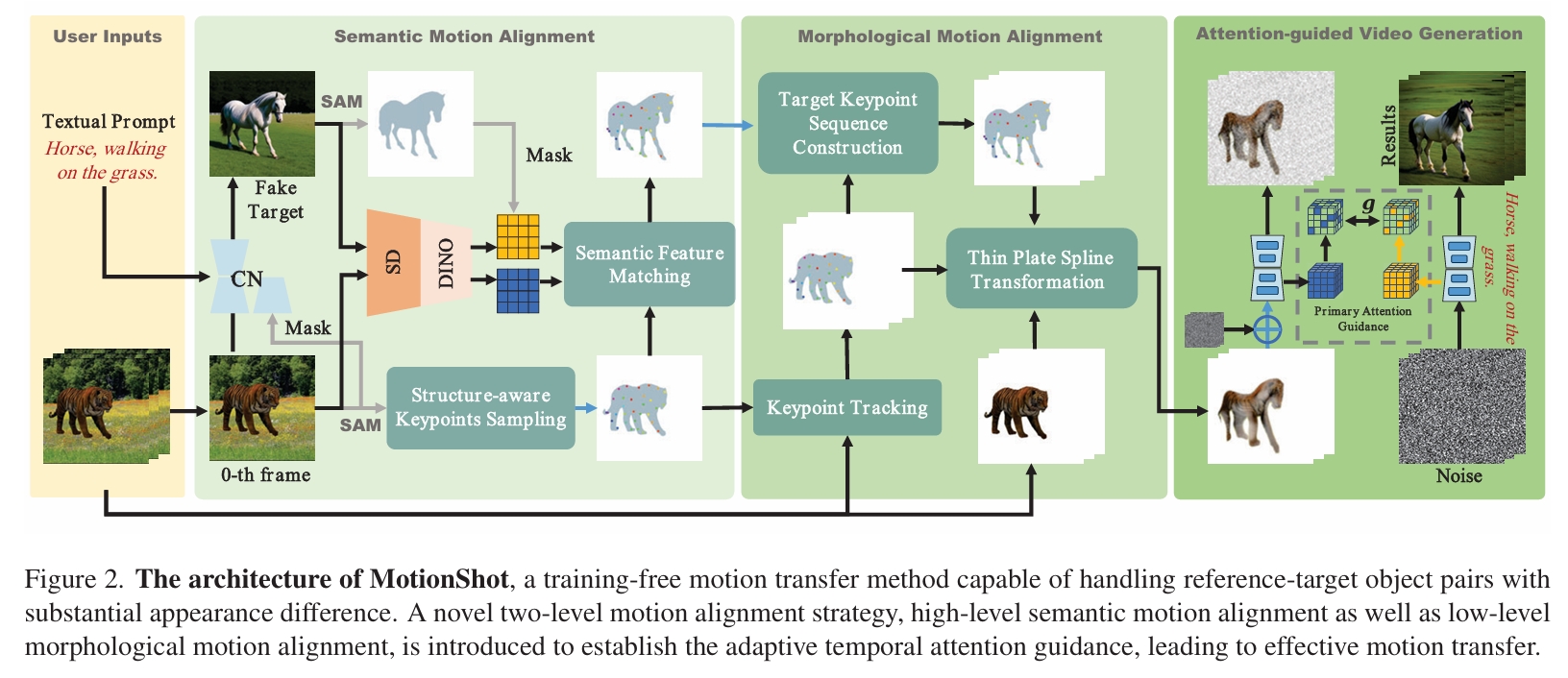

MotionShot: Adaptive Motion Transfer across Arbitrary Objects for Text-to-Video Generation

核心问题是什么?

文本到视频生成,且参考对象(动作信息来自图像)与目标对象(外观信息来自文本)外观或结构差异显著

现有方法及局限性

现有的方法在这种情况下,难以实现运动的平滑迁移。

本文方法及优势

MotionShot——一个无需训练的框架,能够以细粒度方式解析参考-目标对象的对应关系,在保持外观连贯性的同时实现高保真运动迁移。

- 首先通过语义特征匹配确保参考与目标对象的高层对齐

- 继而通过参考到目标的形状重定向实现底层形态对齐。

通过时序注意力机制编码运动,我们的方法能连贯地跨对象迁移运动,即使存在显著的外观与结构差异,大量实验已验证其有效性。项目页面详见:https://motionshot.github.io/。

主要方法

通过对Source Image(动作信息来源)做Warp,得到与『目标对象做特定动作』大致相似的图像做为condition,引导最终的生成。

源和目标虽然差距比较大,但在生理结构上仍具体语义相似性。作者利用这种相似性实现大致轮廓上迁移。

DINO:用于提取外观特征。

Semantic Feature Matching:用于识别生理结构上相似部位的匹配。

Thin Plate Spline Transformation:利用相似性实现轮廓迁移。

实验

Base Model: AnimateDiff

Drop: Dynamics responses from human motion prior and projective dynamics

合成能够动态响应环境的逼真人运动,是角色动画领域的长期目标,在计算机视觉、体育和医疗保健领域具有应用价值,可用于运动预测和数据增强。最近的基于运动学的生成式运动模型在建模海量运动数据方面展现出令人印象深刻的可扩展性,但缺乏对物理进行推理和交互的接口。虽然仿真器在环(simulator-in-the-loop)学习方法能够实现高度物理逼真的行为,但训练中的挑战常常影响其可扩展性和采用率。我们提出了DROP,一个利用生成式运动先验(generative motion prior)和投影动力学(projective dynamics)来建模人体动力学响应(Dynamics Responses)的新框架。DROP可视为一个高度稳定、极简的基于物理的人体模拟器,并与基于运动学的生成式运动先验对接。利用投影动力学,DROP能够灵活、简单地将学习到的运动先验作为投影能量(projective energies)之一进行集成,从而将运动先验提供的控制无缝地融入牛顿动力学(Newtonian dynamics)中。DROP作为一个与模型无关(model-agnostic)的插件,使我们能够充分利用生成式运动模型的最新进展,实现基于物理的运动合成。我们在不同运动任务和各种物理扰动下对我们的模型进行了广泛评估,证明了其响应的可扩展性和多样性。

研究背景与问题

要解决的问题

合成能够动态响应环境的逼真人运动。

现有方法及问题

- 基于运动学的生成式运动模型在建模海量运动数据方面展现出令人印象深刻的可扩展性,但缺乏对物理进行推理和交互的接口。

- 虽然仿真器在环学习方法能够实现高度物理逼真的行为,但训练中的挑战常常影响其可扩展性和采用率。

本文方法及优势

我们提出了DROP,一个利用生成式运动先验和投影动力学来建模人体动力学响应的新框架。DROP可视为一个高度稳定、极简的基于物理的人体模拟器,并与基于运动学的生成式运动先验对接。利用投影动力学,DROP能够灵活、简单地将学习到的运动先验作为投影能量之一进行集成,从而将运动先验提供的控制无缝地融入牛顿动力学中。

DROP作为一个与模型无关的插件,使我们能够充分利用生成式运动模型的最新进展,实现基于物理的运动合成。

主要方法

投影动力学(Projective Dynamics):用约束定义能量,通过最小化一个能量函数来求解系统的状态。

投影动力学框架的核心是其能量最小化过程。DROP巧妙地将学习到的生成式运动先验模型的输出视为一种投影能量项。这个额外的能量项表达了“角色应该如何运动才自然”的期望(由数据驱动的先验知识)。在优化最小化总能量的过程中,系统会自然地趋向于满足这个期望,同时满足物理约束,从而有效地为角色提供了控制力。

基于IPC的Ragdoll系统

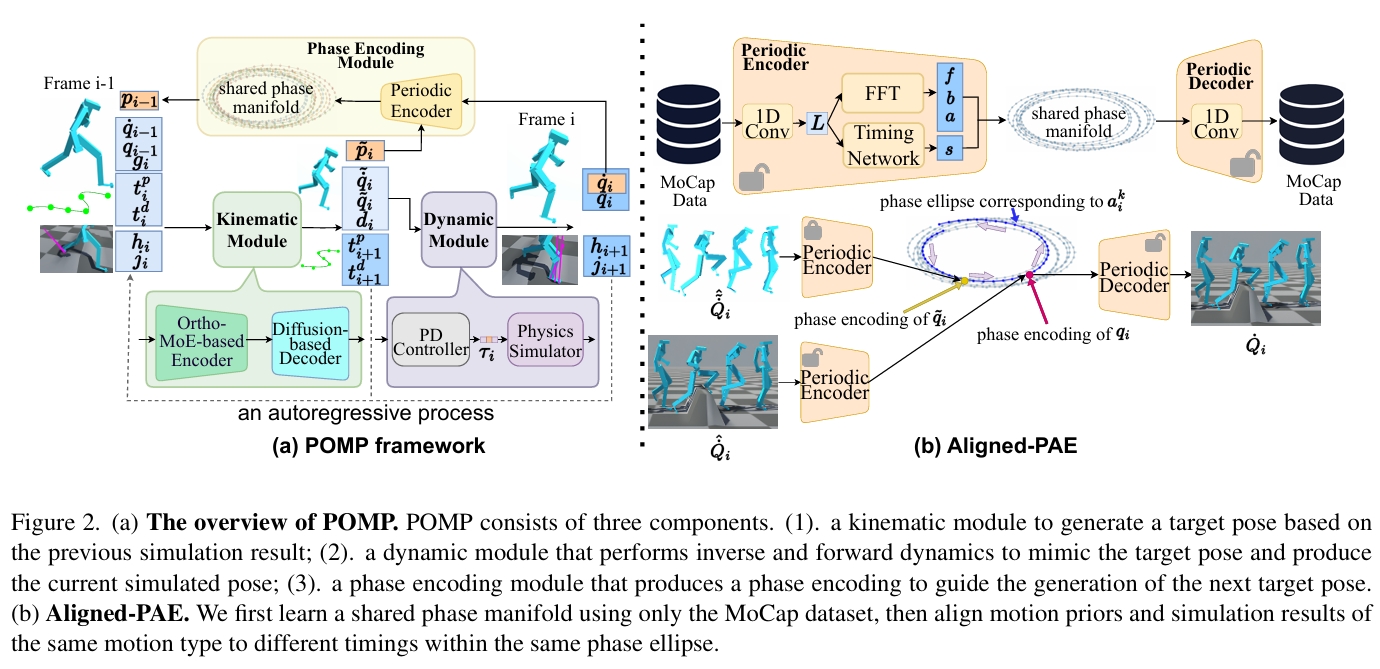

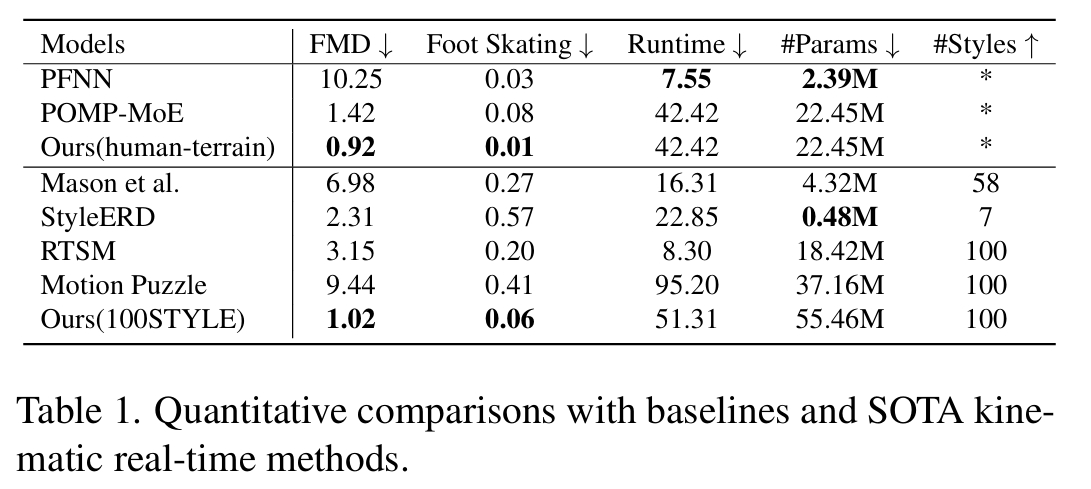

POMP: Physics-constrainable Motion Generative Model through Phase Manifolds

大量关于实时运动生成的研究主要聚焦于运动学层面,这常常导致物理上失真的结果。在本文中,我们提出了POMP("Physics-consistent Human Motion Prior through Phase Manifolds",即"通过相流形实现物理一致的人体运动先验"),这是一个新颖的、基于运动学的框架。它利用相流形来对齐运动先验与物理约束,从而合成物理一致的运动。

POMP作为一个逐帧的自回归模型运行,包含三个核心组件:一个基于扩散的运动学模块、一个基于仿真的动力学模块和一个相位编码模块。在每一时间步,运动学模块先生成一个初始目标姿态,随后该姿态由动力学模块进行优化(通过模拟人-环境交互)。虽然物理仿真确保了遵循物理定律,但它可能会损害姿态的运动学合理性。因此,直接将仿真结果用于后续帧预测可能会导致误差累积。

为了解决这个问题,相位编码模块在相流形中进行语义对齐。此外,我们提出了一套在Unity引擎中实现的流程,用于生成地形图并从现有的运动捕捉(MoCap)数据中提取全身运动冲量。所收集的地形拓扑和运动冲量数据促进了POMP的训练,使其能够稳健地响应基础接触力和施加的动力学。

广泛的评估表明,POMP在各种情境、地形和物理交互中均表现出色。

研究背景与问题

要解决的问题

物理合理的实时运动生成

本文方法

这是一个基于运动学的框架,它利用相流形将运动先验与物理约束对齐,从而合成物理上真实的运动。

POMP 作为一个逐帧的自回归模型运行,包含三个核心组件:一个基于扩散的运动学模块、一个基于仿真的动力学模块和一个相位编码模块。 在每个时间步,

- 运动学模块:通过学到的运动先验生成一个目标姿态;

- 动力学模块:强制执行动态约束并产生一个仿真姿态(不可微);

- 相位编码模块:将仿真姿态投影回运动先验,并获取其相位位置编码 。

- 这些处理后的状态向量递归地输入后续的姿态生成。

因为仿真步骤会引起的运动学畸变,累积的误差可能使结果偏离运动学模块学习到的运动先验,导致后续运动生成失败。为了解决这个问题,相位编码模块在相流形中应用语义对齐,将仿真结果投影回运动先验。

本文优势

-

它将计算密集型的动力学模块置于基于梯度的训练循环之外,从而降低了计算复杂度。

-

它在相流形中进行语义对齐,从而解决了领域鸿沟问题 。

-

它允许更广泛的应用,能够实现准物理效果,而无需特定于模拟器的专业知识。

主要贡献

- 一种新颖的基于运动学的生成模型,能够实时对物理扰动进行主动和被动响应。

- 首次采用基于相位的语义对齐方法来解决运动学运动先验与仿真姿态之间的领域鸿沟。

- 开发了一个流程,用于从动捕数据集中进行地形重建和全身运动冲量提取。

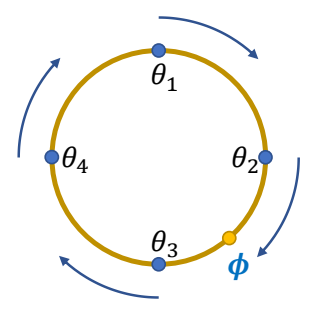

主要方法

运动表示

第 i 帧的运动变量 (motion variables) xi 由四部分组成:角色状态、环境信息、相位变量和轨迹位置。

角色状态

- 身体关节的位置

- 身体关节的速度

- 根关节(通常指骨盆或臀部在 x-z 平面上的速度

- 根关节绕 y 轴的旋转角速度

- 独热编码步态向量,指示角色的步态类型(例如:站立、行走、慢跑、蹲下、跳跃、撞击、躺下、起身)。

环境信息

- 周围地形高度

- 全身接触冲量

相位变量

- 整个时间窗口上的相位编码

- 时间窗口未来一半的输出相位变量

相位编码由 aligned-PAE 模块生成(或提取)

轨迹位置

- 用户控制的整个时间窗口的轨迹位置投影到 2D x-z 平面上表示

- 用户控制的整个时间窗口的方向投影到 2D x-z 平面上表示

- 预测的轨迹变量的轨迹位置投影到 2D x-z 平面上表示

- 预测的轨迹变量的方向投影到 2D x-z 平面上表示

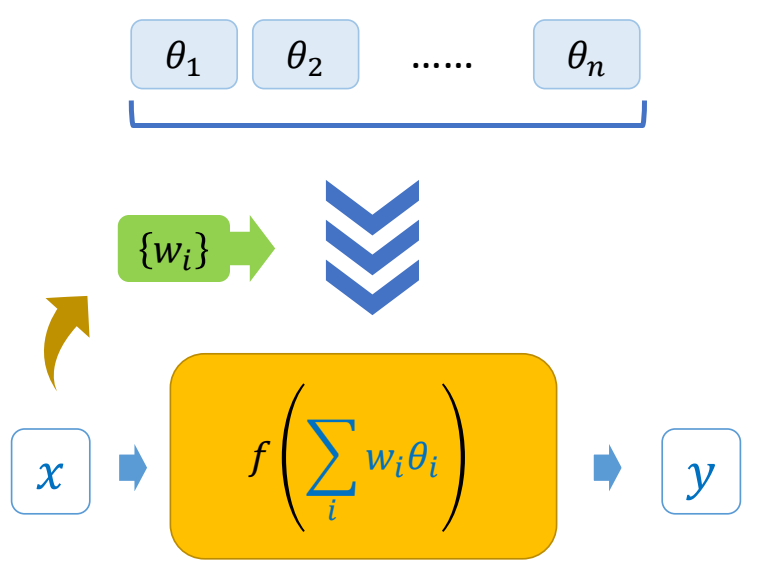

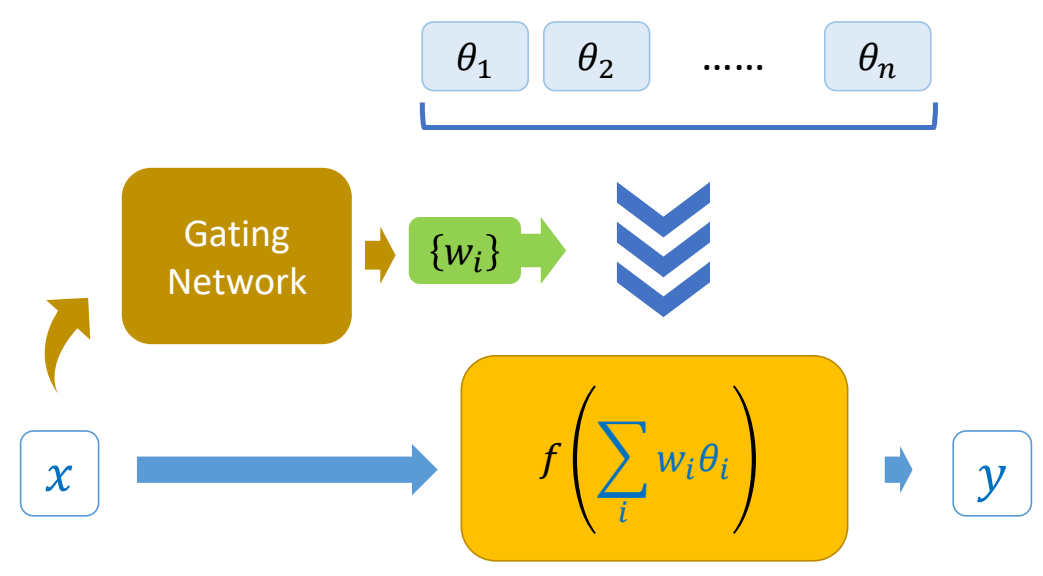

运动学模块

OrthoMoE-based Encoder

xi:包含运动表示中的全部输入信息,共541维

wk:1024维

| 输入 | 输出 | 方法 |

|---|---|---|

| xi中的相位变量 | 混合系数a | 门控网络Eg |

| xi | 相位编码wk | Em中的八个专家网络 |

| 相位编码 | 每个专家对应的相位编码和混合系数 | 加权求各 |

约束:各个专家网络的输出互相正交

Diffusion based Decoder

w:条件,1024W

zi:输出,包含xi中h,j以外的信息,8 * 388维

yi = ∑^8_{k=1} α_k z_k

为了在不牺牲质量的前提下加速逆向过程,从 Analytic-DPM 获得灵感,将方程 (3) 中的协方差项\( λ^2_{τ_n} I \) 替换为一个解析估计

动力学模块

逆动力学 (控制)

使用比例微分(PD) 控制器,根据运动学模块提供的目标姿态和角色的当前状态(姿态和速度),计算所需的关节力/扭矩 τ

前向动力学 (仿真)

物理引擎接收 τ 和当前状态,结合环境力(如重力、接触力、碰撞力),计算角色的瞬时加速度。

计算出的加速度用于更新运动状态(姿态和速度)

相位编码模块

动力学模块生成的物理上合理的姿态可能落在运动学运动先验之外,导致在基于 qi 生成下一个目标姿态 q^{i+1} 时破坏运动的连续性。

周期性自编码器 = Periodic Autoencoder = PAE,负责从运动数据中学习一个紧凑的相流形表示。

| 输入 | 输出 | 方法 |

|---|---|---|

| 纯净的 MoCap 数据 | 运动学速度序列,维度:T * 3NJ | |

| 速度序列,维度:T * 3NJ T=121 | 低维的latent embedding,维度:T * 5 5 对应流形的五个通道 假设每个通道 (t=0..4) 都可以近似看作一个正弦波。 | 1D 卷积层 1D Conv 擅长捕捉时间序列中的局部模式和特征。 |

| 低维的latent embedding,维度:T * 5 | a_i:振幅 f_i:频率 b_i:偏移 | 可微FFT层 |

| 低维的latent embedding,维度:T * 5 | s_i:相移 | 使用一个 MLP单独预测 |

| a_i, f_i, b_i, s_i | 重构的latent embedding | Li = ai · sin(2π · (fi · T - si)) + bi |

| 重构的latent embedding | 速度曲线 | 1D 反卷积层 |

| 输入的速度序列 输出的速度序列 | Loss | MSE |

训练完成后,相位编码pei ∈ R^{10} 通过以下方式计算:

pei(2t) = a_i^{(t)} · cos(2π · s_i^{(t)})

pei(2t+1) = a_i^{(t)} · sin(2π · s_i^{(t)})

其中 t 是通道索引 (channel index)(t = 0, 1, 2, 3, 4)。

训练

增强 MoCap 数据

基于 MoCap 数据的地形重建

采用 PFNN 提出的地形拟合方法,计算每帧角色周围的轨迹高度。然后,我们初始化一个零值高度图,并使用运动轨迹的逐步“扫描”并更新该高度图,最终形成全面的地形数据。

通过物理模拟器进行接触力获取和姿态仿真

将 MoCap 数据导入 Unity 场景,利用Unity中的物理模拟器: (1) 收集真实接触冲量ji,用于训练运动学模块 (2) 生成真实仿真姿态qi,用于训练后续的相位编码模块

推断

运动学模块预测的输出相位变量 pi 包含两个部分:

- pe ∈ 2×C×T,C=5,T=0.5L+1=7

- {f, a, b} ∈ 3×C×T

用于计算重建的速度序列

输入给 PAE 的速度序列的数据由三部分组成:

- 过去 (i-60:i): 使用真实仿真速度。

- 近期未来 (i+1:i+20): 使用人工仿真速度。

- 较远未来 (i+21:i+60): 使用目标速度。

人工仿真速度是指基于前面的物理仿真的加速度计算得到的速度。

实验

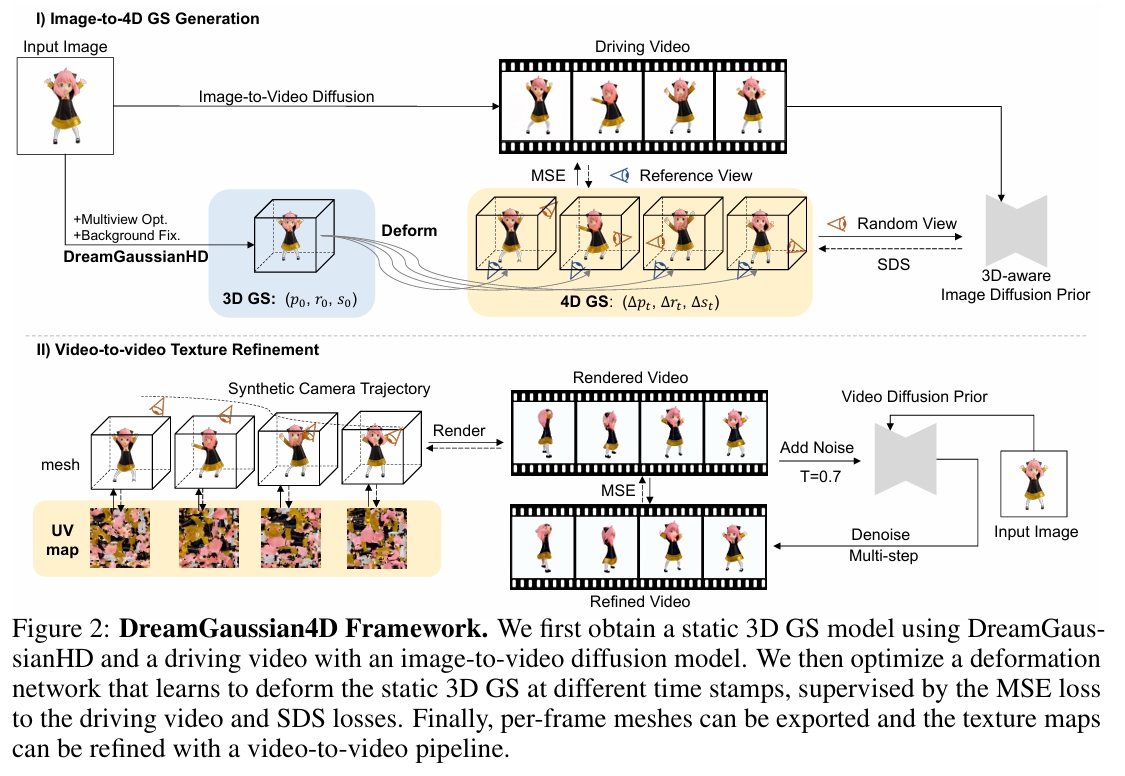

Dreamgaussian4d: Generative 4d gaussian splatting

近日,四维内容生成领域取得了显著进展。然而,现有方法仍存在优化耗时过长、运动可控性不足以及细节质量欠佳等问题。本文提出DreamGaussian4D(DG4D)——一个基于高斯溅射(GS)的高效四维生成框架。我们的核心思路是:将空间变换的显式建模与静态GS相结合,构建出高效且强大的四维生成表征。此外,视频生成方法能够提供有价值的时空先验,从而提升四维生成的质量。具体而言,我们提出了包含两大核心模块的完整框架:1)图像到四维GS转换——首先生成静态GS,随后通过基于HexPlane的动态生成与高斯形变实现动态建模;2)视频到视频纹理优化——利用预训练的图像到视频扩散模型对生成的UV空间纹理图进行时序一致性优化。值得关注的是,DG4D将优化时间从数小时缩短至几分钟,实现了生成三维运动的可视化控制,并产出了可在三维引擎中实现逼真渲染的动画网格。

开源

研究背景与问题

任务

输入:单张图像

输出:图像对应的静态GS模型,t时刻相对于静态GS的位移、旋转、缩放。

本文方法及优势

| 要解决的问题 | 当前方法及存在的问题 | 本文方法及优势 |

|---|---|---|

| 表示方式 | 隐式表示 (NeRF) 场景重建与驱动都非常低效。 | 用 3D GS 显式、高效地表示静态基础,用 HexPlane 显式、高效地表示动态位移。 3DGS相对于Nerf的优缺点 |

| 运动信息来自 | 依赖 Video SDS (视频分数蒸馏) 来从视频扩散模型中“蒸馏”运动信息。 这种方法具有固有的随机性和不稳定性。 | 直接从一段“驱动视频”中学习运动模式。 监督方式还是SDS |

| 静态几何与动态运动之间的关系 | 耦合关系:动态几何建模Nerf 优化慢、运动不规则 | 解耦关系:静态几何建模(GS)+ 动态运动建模(HexPlane位移) 通过优化HexPlane预测每个高斯点在时间轴上的位移,将运动高效地“注入”到高质量的静态场景中 |

| 纹理优化 | 未涉及 | 利用预训练的图像到视频扩散模型,对生成的UV空间纹理贴图进行优化,同时增强其时间一致性。 |

主要贡献

- 一个系统性的图像到4D生成框架,它协同利用了图像条件化的3D生成模型和视频生成模型。这允许直接控制和选择期望的3D内容及其运动,从而实现高质量且多样化的4D生成。

- 显式地表示4D场景:使用 3D GS 表示基础场景,并使用 HexPlane 表示不同时间戳下的形变。这种空间变换的显式建模将4D生成时间从数小时显著缩短至仅需几分钟。

- 一种视频到视频纹理优化策略,通过保持时间一致性,进一步提升了导出的动画网格的质量,使得该框架在实际应用部署中更加友好。

主要方法

阶段1 从图像生成动态几何

DreamGaussianHD 生成静态3D GS

输入: 单张图像。

输出:使用 DreamGaussianHD 从输入图像生成高质量的静态 3D GS。

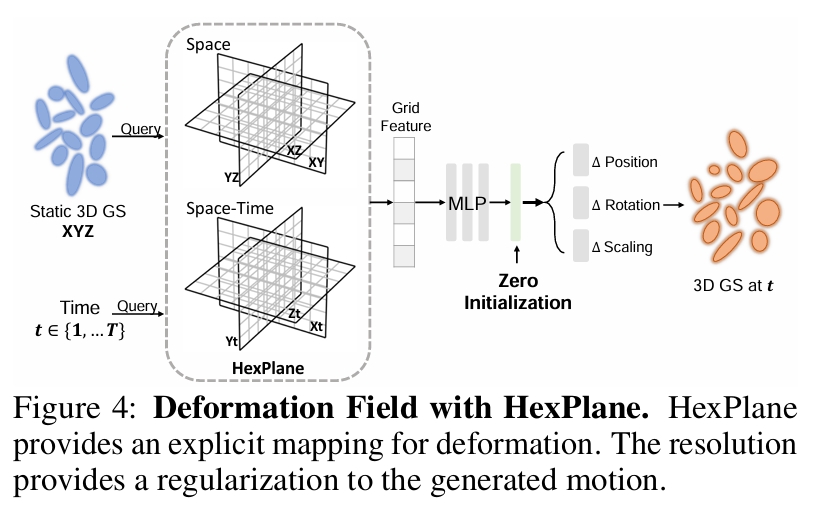

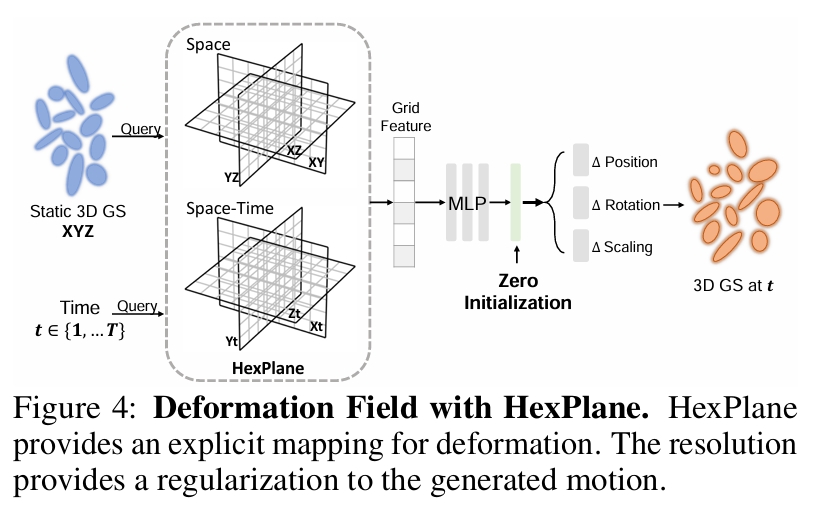

Gaussian Deformation for Dynamic Generation

在静态 GS 基础上,优化一个时间相关的形变场(核心是 HexPlane)。预测每个高斯点在每个时间戳的形变。

生成driving video

driving video来源: 图像到视频模型(如 SVD/Sora)根据同一张输入图像生成 使用driving video可避免了 SDS 的随机性和低效。

用于 4D 表示的 HexPlane

输入:x,y,z,t

输出:delta positon, delta rotation, delta scaling at t

HexPlane 将一个 4D 场分解为六个特征平面,这些平面跨越每一对坐标轴(例如 XY, XZ, XT, YZ, YT, ZT)。

Hexplane: A fast representation for dynamic scenes

这种分解将 4D 场表示为一组可学习的 4D 基函数的加权和。

静态到动态的初始化

形变模型应被初始化为在训练开始时预测零形变。

为了预测零形变,同时不影响梯度更新,我们采用以下策略:

- 对最后几个线性层进行零初始化(zero-initialization)。

- 采用若干残差连接。

形变场优化

优化目标:

- 参考视角监督:渲染图像与驱动视频对应帧之间的均方误差

- 多视角监督:SDS

为了将运动从参考视角传播到整个 3D 模型(特别是参考视角下被遮挡的部分),我们利用 Zero-1-to-3-XL 来预测未见部分的形变。

优化参数(两种策略):

- 冻结静态 3D GS 的参数,只优化形变场 ϕ

- 选择性地在优化过程中对静态 3D GS 进行微调

输出: 动画网格序列

阶段2 Video-to-Video Texture Refinement

Base Model: SVD

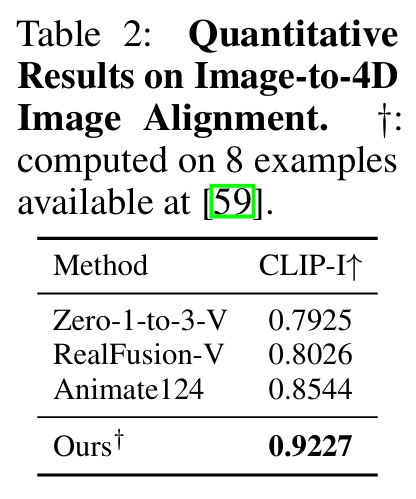

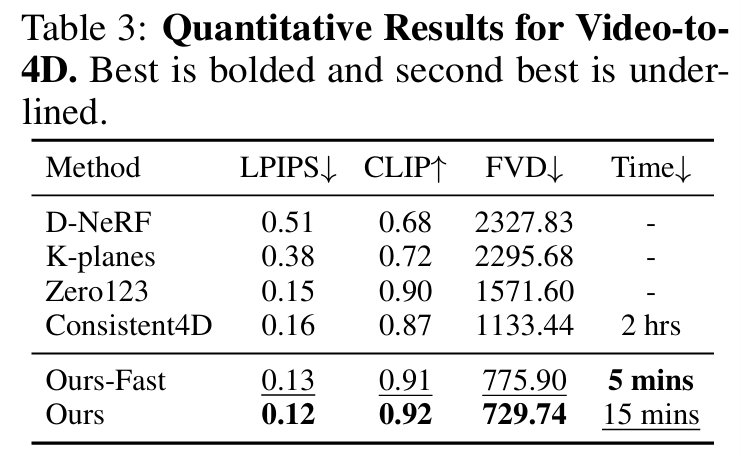

实验

图像 TO 4D

视频 TO 4D

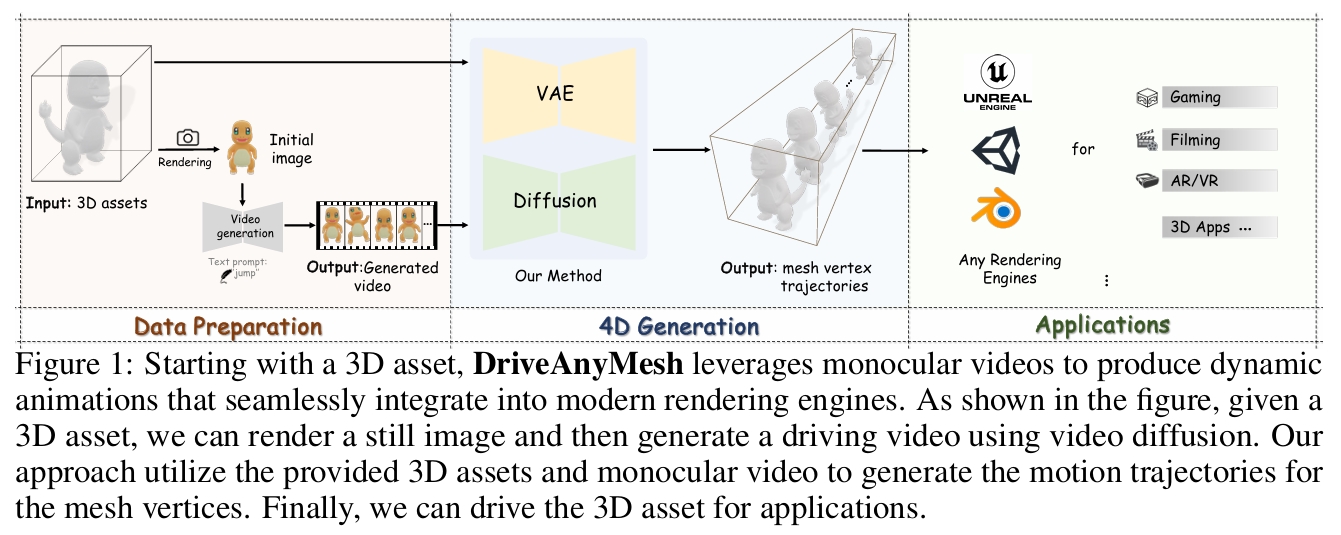

Drive Any Mesh: 4D Latent Diffusion for Mesh Deformation from Video

研究背景与问题

要解决的问题

对现有 3D Mesh进行动画化

本文方法及优势

- 输入 1:初始几何 - 一个表示目标物体的初始点云

P1。它包含N个三维点(pi ∈ R³),通常通过对用户提供的静态 3D 网格进行采样获得。P1定义了物体的初始形状。 - 输入 2:运动参考 - 一个单目视频

V。它包含T帧图像(It),由固定相机拍摄。视频提供了期望的运动模式或姿态序列参考。 - 输出:运动轨迹序列 - 一个点云序列

P = {P1, P2, ..., PT}。 - 实现手段: 使用一个 4D 潜在扩散模型 来建模和学习这个条件分布

p(P|P1, V)。该模型的核心功能是进行条件去噪:从一个噪声版本的点云序列开始,在P1和V的引导下,逐步去噪,最终得到干净的、代表目标动画的点云轨迹序列P。

主要贡献

一种新颖的 4D 生成方法,利用单目视频为 3D 资产生成动画;

一个大规模 4D 资产数据集,包含多视角视频和网格顶点序列;

一种新的基于潜在扩散模型的方法,配备了专为 4D 生成设计的新型 VAE 架构和扩散结构。

主要方法

数据准备

从庞大的 Objaverse 数据集 [5, 4] 中精心策划了一个新的 4D 数据集,该数据集包含大量带标注的 3D 对象。

基于点云轨迹的运动表示

核心思想: 将物体的运动表示为其网格顶点随时间的移动路径(轨迹)。

优点: 输出是显式的点云序列 {Pt},其中 Pt 是时间 t 时的顶点位置。这种表示天然兼容所有现代渲染引擎,因为引擎可以直接读取和渲染顶点位置序列定义的网格动画。

关键挑战:不同 3D 网格模型的顶点数量 (N) 差异很大。

解决方案:潜在集 (Latent Sets)

3DShape2VecSets

基于 Transformer 的 VAE

目标: 学习一个紧凑的 4D 潜在表示(即潜在集 F),它能充分编码形状和运动信息,并能被高效地生成和重建。

- 4D 运动编码器: 输入初始点云 P1(几何形状)和多视角动画图像序列(视觉外观和运动信息)。压缩这些时空信息,输出潜在集 F。

- KL 正则化块: 在训练过程中,它约束学习到的潜在集 F 的分布接近一个先验分布(通常是标准正态分布)。(VAE标准操作)。

- 4D 运动解码器: 输入是潜在集 F。响应查询(顶点索引 i 和时间 t),输出顶点 i 在时间 t 的位置,从而重建或生成对应的点云轨迹序列。

使用扩散模型进行运动生成

输入: 用户提供 P₁ (初始网格点云) 和 V (单目参考视频)。

Denoiser 利用空间、条件(几何+外观)和时间注意力机制,预测出更干净的潜在序列{Ẑₜ}ᵗ⁼₁ᵀ。

VAE 将 {Ẑₜ}ᵗ⁼₁ᵀ 输入到 VAE 的解码器中。输出预测的点云轨迹序列 P = {P₁, P₂, ..., Pₜ},即最终的 4D 网格动画。

后处理

基于欧氏距离的阈值滤波机制,用于消除抖动。

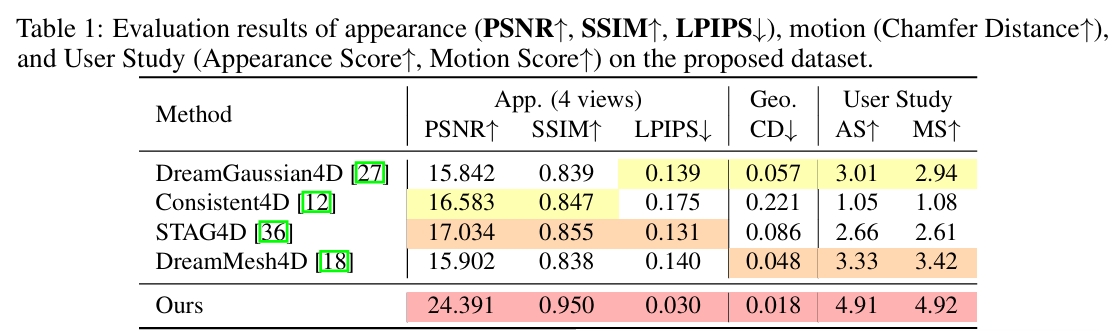

实验

测试指标

从视觉质量上评估:

峰值信噪比 (PSNR)、结构相似性指数 (SSIM) 和学习感知图像块相似度 (LPIPS)

横向对比

DreamGaussian4D [27], Consistent4D [12], STAG4D, DreamMesh4D

消融实验

在训练变分自编码器 (VAE) 时,仅使用均方误差 (MSE) 损失无法快速收敛到令人满意的结果。因此引入欧氏距离损失 (DIS)。 在相同的优化时间内,结合两种损失函数能得到更好的结果。

相似工作对比(原创)

AnimateAnyMesh是同期相似的工作。相同点:

- 驱动任意拓扑与内容的Mesh。

- 把Mesh序列分解为初始点云和每个顶点的运动路径,通过重建顶点的运动路径,叠加到初始点云后,得到被驱动的Mesh。

- 以顶点顺序、数量无关的方法对Mesh进行编码,表达为隐空间向量。生成模型在隐空间是完成。

- 提供了一个4D Mesh数据集。

不同点:

| 本文 | AnimateAnyMesh | |

|---|---|---|

| Mesh编码方式 | Self Attention + Cross Attention + VAE | Latent Set + Transformer VAE |

| 生成模型 | 修正流 | diffusion |

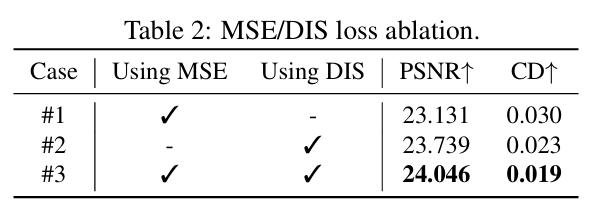

AnimateAnyMesh: A Feed-Forward 4D Foundation Model for Text-Driven Universal Mesh Animation

研究背景与问题

要解决的问题

根据文本驱动对任意3D网格进行动画化

本文方法及优势

- 采用了一种新颖的 DyMeshVAE 架构,通过将空间特征和时间特征解耦,并保留局部拓扑结构,从而有效地压缩并重建动态网格序列。

- 为了实现高质量的文本条件生成,我们在压缩后的潜在空间中采用了一种基于修正流(Rectified Flow) 的训练策略。 贡献了一个名为 DyMesh Dataset 的大规模数据集,包含超过400万个带有文本标注的多样化动态网格序列。

实验结果表明,AnimateAnyMesh能够在几秒钟内生成语义准确且时间连贯的网格动画,在质量和效率方面均显著优于现有方法。

主要方法

DyMeshVAE

顶点编码

给定一个动态网格序列 \( \mathcal{D} \subset { F \in \mathbb{R}^{M\times3},\ V \in \mathbb{R}^{T\times N\times3} } \)

首先将顶点序列 \( V \) 分解为初始帧顶点 \( V_0 \in \mathbb{R}^{N\times3} \) 和相对运动轨迹 \( V_T \in \mathbb{R}^{N\times(T\cdot3)} \),满足以下关系:

$$ V^t = V^0_t + V^t_T,\quad \text{其中 } t = 1, 2, \dots, T $$

其中 \( t \) 表示时间序列的索引。

将顶点序列 V 拆分为 V0 和 VT 是DyMeshVAE 的关键建模思想之一。这种分解方式有助于实现形状与运动的解耦建模,同时使得运动分布更接近一个均值为零的正态分布。

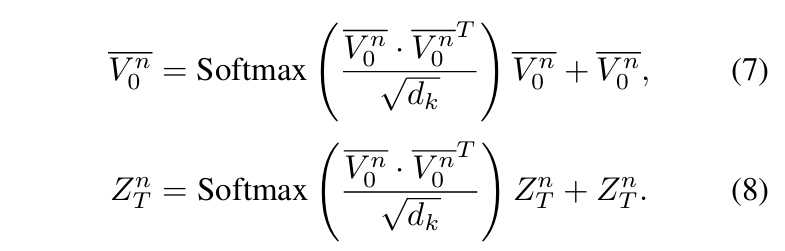

位置编码

目的:增强轨迹重建的稳定性并防止粘连效应

方法:对 \( V_0 \) 和 \( V_T \) 使用不同的位置编码策略,从而得到编码后的特征 \( \hat V_{0} \) 和 \( \hat V_{T} \)。

拓扑编码

从输入网格的面片信息 F 中构建一个邻接矩阵 Adj。该邻接矩阵随后作为自注意力层中的注意力掩码,使每个顶点能够聚合其相邻顶点的信息:

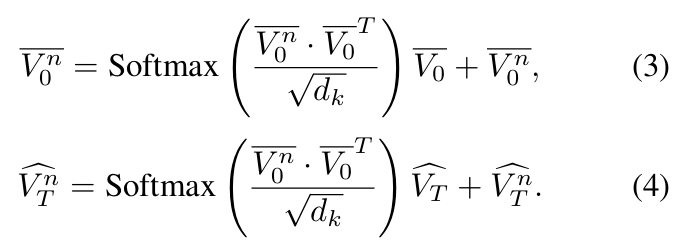

$$ \bar V_0 = \text{Softmax}\left( \frac{\hat V_{0} \cdot \hat V_{0}^T \odot \text{Adj}}{\sqrt{d_k}} \right)\hat V_{0} + \hat V_{0} \tag{2} $$

捕捉运动模式之间的相关性

对拓扑感知顶点特征 \(\bar \V_0\)应用最远点采样(Farthest Point Sampling, FPS)55,得到\(\bar \V_0^n\)

attention map

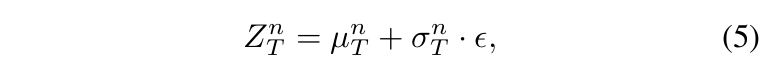

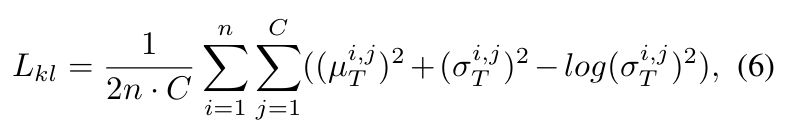

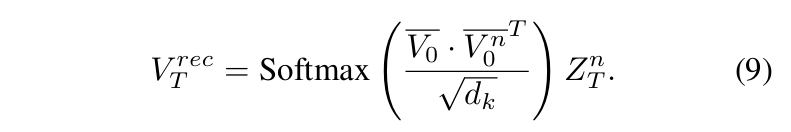

KL Regularization

目的:对相对轨迹 \(\hat \V_T^n\) 的分布进行建模。

- 在潜空间采用 KL 正则化以调控特征多样性。即:

通过两个全连接层对 \(\hat \V_T^n\) 进行线性投影,预测其分布的均值和标准差 - 随后按以下方式对 VAE 潜变量进行采样:

- 正则化约束为:

DyMeshVAE Decoder

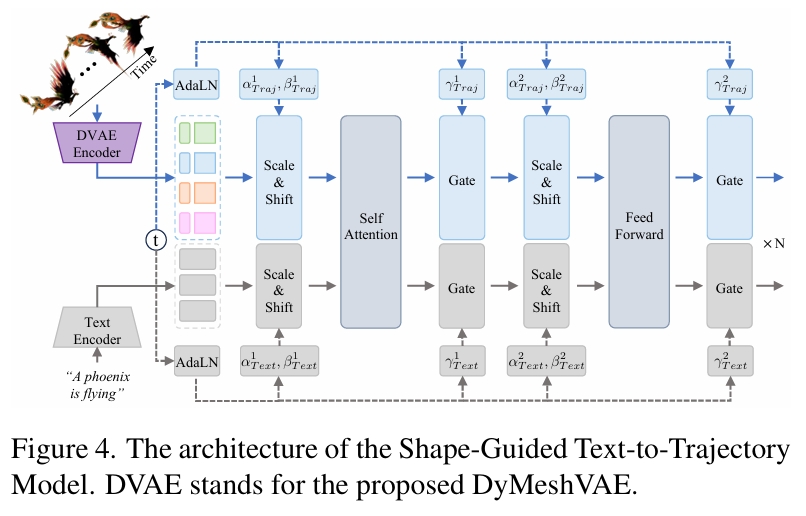

形状引导的文本到轨迹模型

目的:在给定初始网格和文本提示的条件下估计相对轨迹的后验分布。

每个动态网格序列 \( \mathcal{D} \) 被编码为一对潜表示 \( {V_n^0, Z_n^T} \)。

- 使用全局统计量(均值 \( \mu_0, \mu_T \) 和标准差 \( \sigma_0, \sigma_T \))标准化潜变量以消除数值差异

- 沿通道维度拼接标准化特征 → 形成综合轨迹嵌入

- 通过预训练CLIP文本编码器获取文本嵌入

- 采用时间步 \( t \) 相关的独立自适应层归一化(AdaLN)参数分别调制轨迹嵌入和文本嵌入

- 重缩放后的特征拼接进行自注意力计算

- 多注意力块处理后,分解输出特征并基于保存的统计量 \( \mu_0, \mu_T, \sigma_0, \sigma_T \) 还原原始尺度

训练

训练

遵循修正流(Rectified Flow, RF)[42]的扩散范式,我们旨在最小化预测流与真实流之间的均方误差。

修正流:Flow straight and fast: Learning to generate and transfer data with rectified flow

推断

基于流式的常微分方程(ODE)公式实现修正流的采样过程。

采样完成后,将生成的轨迹特征 \( Z_n^T \) 与拓扑感知顶点特征 \( V_n^0 \) 输入解码器生成相对轨迹,最终通过将解码的顶点位移应用于给定网格,生成动态网格序列。

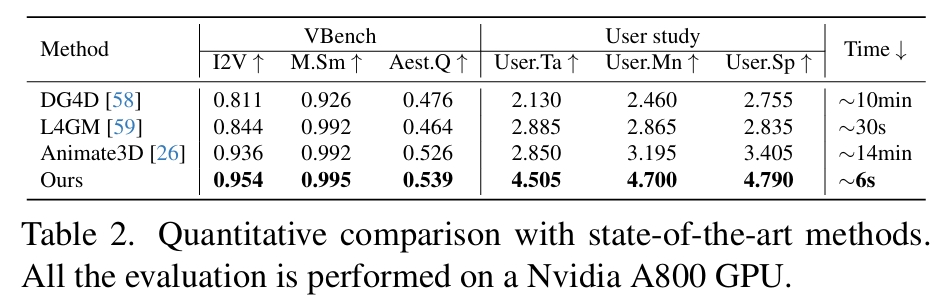

实验

估计指标

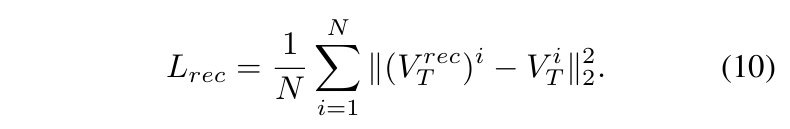

- 重建质量评估:计算重建顶点轨迹与真实轨迹间的逐帧平均 L2 距离

- 从固定视角渲染动画网格,并从视觉质量上评估

- 人工评估

横向对比

- DG4D [58]:基于微分几何的变形模型

- L4GM [59]:潜在空间网格运动生成器(使用 DynamiCrafter [86] 作为视频生成组件)

- Animate3D [26]:神经渲染驱动的动画框架

| 方法 | 技术缺陷 | 本方案解决策略 |

|---|---|---|

| DG4D | 视频蒸馏导致3D表示退化 • 高斯球参数无法精确描述拓扑变化 | ✅ 直接操作网格顶点 • 保留显式几何结构 |

| L4GM | 视频生成依赖背景信息 • 孤立物体缺乏纹理线索 → 运动估计失真 | ✅ 端到端轨迹学习 • 无需中间视频表示 |

| Animate3D | 多阶段误差传递 网格→高斯→视频→轨迹的转换损失 | ✅ 单阶段预测框架 • 消除累计误差 |

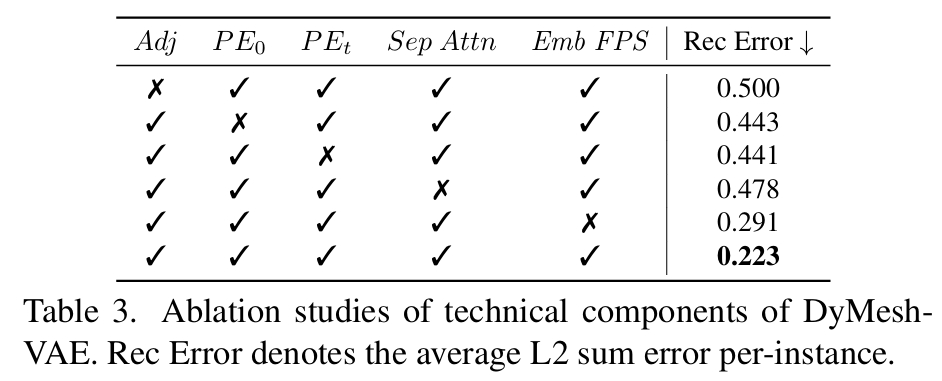

消融实验

| 组件 | 输入对象 | 核心功能 | 失效后果 |

|---|---|---|---|

| Adj | 网格边连接关系 | 建立顶点语义边界(如手指关节 vs 手掌) | 跨语义区域粘连(图 7) |

| PE₀ | 初始顶点坐标 | 编码空间位置信息 → 增强静态特征区分度 | 对称部位运动混淆 |

| PEₜ | 轨迹向量 | 描述运动方向/幅度 → 提升时序建模能力 | 运动轨迹抖动(图 8) |

| Sep Attn | 初始特征 \(V_n^0\) | 仅基于拓扑计算注意力 → 强化 "结构-运动" 关联规则 | 局部运动协调性下降 23% |

| Emb FPS | 邻域增强特征 | 保留语义信息的采样 → 512 令牌覆盖关键运动区域 | 重建误差上升 15.7% |

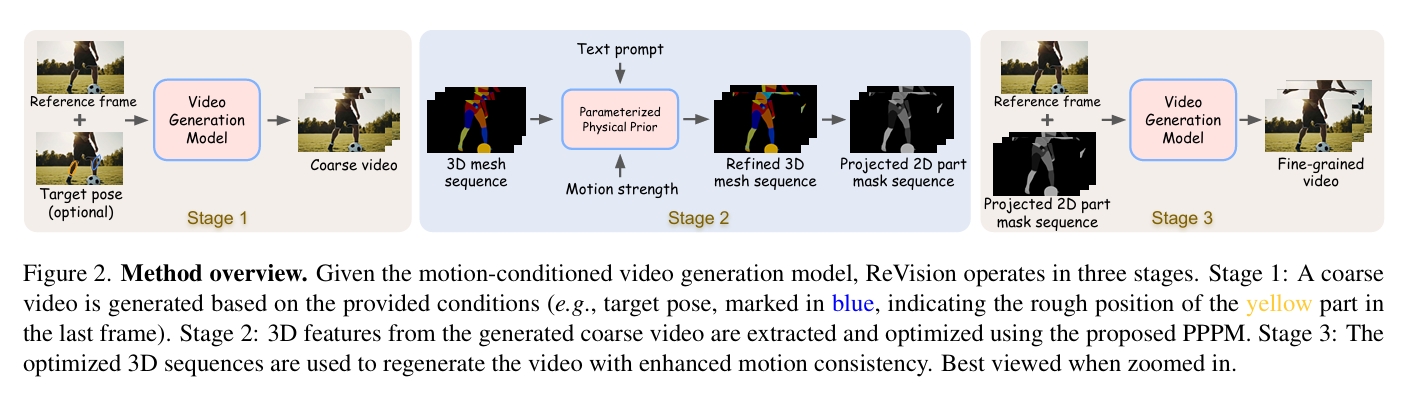

ReVision: High-Quality, Low-Cost Video Generation with Explicit 3D Physics Modeling for Complex Motion and Interaction

研究背景与问题

要解决的问题

生成包含复杂动作和交互的视频

本文方法及优势

首先,使用一个视频扩散模型生成一个粗糙的视频。

接着,从该粗略视频中提取一组 2D 和 3D 特征,构建一个以对象为中心的 3D 表示,并通过我们提出的参数化物理先验模型对其进行优化,生成精确的 3D 动作序列。

最后,这一优化后的动作序列被反馈到同一个视频扩散模型中作为额外的条件输入,使得即使在涉及复杂动作和交互的情况下,也能生成运动一致的视频。

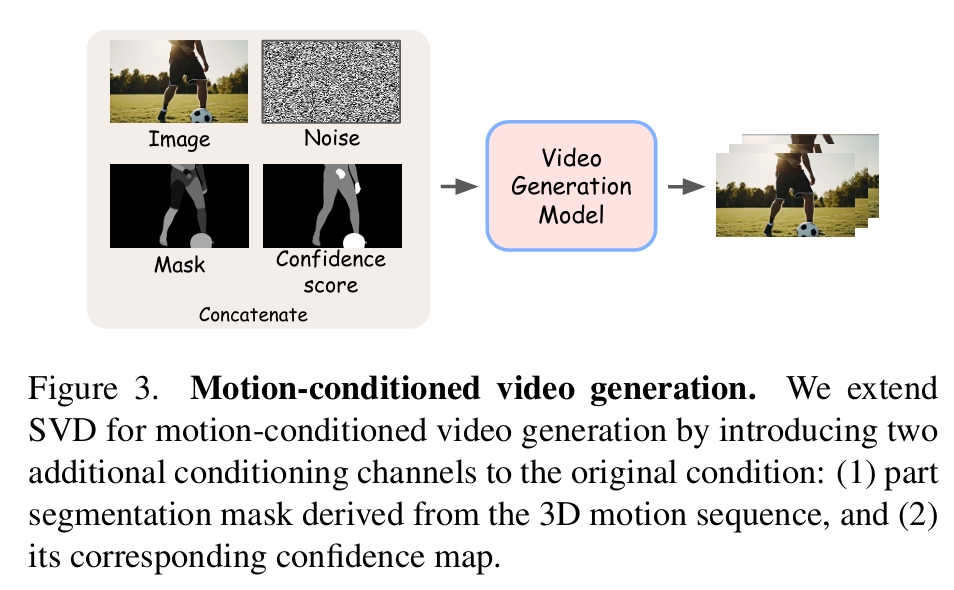

主要方法

基于运动条件的视频生成

从预训练的 SVD 模型出发,在原始条件输入中额外拼接了两个通道:

- 3D 运动序列的部件级分割掩码

- 该掩码可靠性的置信度图

| 场景 | 数据来源 | 占训练样本百分比 | 置信度分数 |

|---|---|---|---|

| 场景一 | 运动序列的部件级掩码由从 3D 参数化网格模型投影的所有 2D 部件分割掩码合并生成 | 40 | 1 |

| 场景二 | 用户通过简单的草图(如圆形或椭圆形)指示特定目标或部件(如手或手臂)的最终位置 | 30 | 0.5 |

| 场景三 | 空部件掩码 | 30 | 0 |

ReVision

S1:粗略视频生成

输入:第一帧和可选的用户指定的目标姿态(最终帧中的运动)

输出: 视频

由于生成过程仅依赖于最终帧的目标运动或空运动,而非完整的运动序列,因此生成的视频通常运动质量较差,存在改进空间。因此,称此阶段为粗略视频生成。

S2:以对象为中心的 3D 优化

利用 3D 参数化网格模型(用于人类和动物 [32, 49, 80])、边界框 [57]、分割掩码 [40, 71] 和深度估计 [69](用于通用对象)对目标进行 3D 参数化。

3D参数化方法:

- 人使用SMPL

- 动作使用SMAL

- 其它物体使用BBox、分割掩码和深度估计。

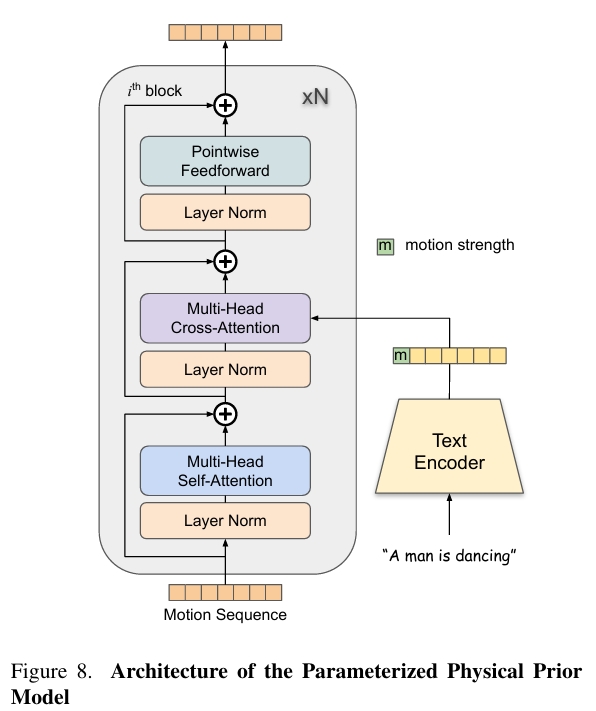

使用参数化物理先验模型(PPPM),基于文本信息和运动强度对 3D 运动序列进行优化。

PPPM把 3D 参数化运动序列 变为优化后的 3D 参数化运动序列,再转为 3D 网格序列,并投影为 2D 部件分割掩码和置信度图。

S3:细粒度视频生成

以S2输出的在 3D 空间中优化的完整运动序列作为部件掩码为condition生成视频。

训练

数据集

作者自己标注了object-centric annotations的视频数据集。

| 输入 | 输出 | 方法 |

|---|---|---|

| 视频 | 筛选高质量运动视频、人和动物的分割掩码 | 大型语言模型(Qwen2) 和开放词汇分割模型(Convolutions die hard) |

| 所选视频、字幕 | 字幕是提到的对象 | 边界框检测(Yolov8)、掩码分割(Convolutions die hard) |

| 包含人类的视频 | 精确的人体掩码 | YOLOv8 |

| 包含人类的视频 | 每个人的面部关键点 | RTMPose |

| 包含人类的视频 | SMPL参数、MANO参数 | 4D-Human 和 HaMeR |

| SMPL参数、MANO参数 | SMPLX参数 | 整合 |

| 3D SMPL-X 人体Mesh | 部件掩码及标签 | 投影 |

| 以上人体标注输出 | 质量验证和过滤 | |

| 包含动物的视频 | 动物掩码 | Grounded SAM 2 |

| 包含动物的视频 | 视频中相机的内参和外参 | VGGSfM,同时过渡低质量数据 |

| 包含动物的视频 | SMAL参数 | AnimalAvatar、Animal3D |

| 以上动物标注输出 | 质量验证和过滤 |

优点:

- 利用现成模型(如 YOLOv8、RTMPose、SMPL-X、AnimalAvatar)生成高质量标注,而非人工标注。

- 结合语言模型(LLMs)筛选含运动的视频,提升数据相关性。

- 多阶段的过滤筛选

- 从视频筛选到标注生成的全流程自动化。

训练

不同的条件输入策略:

- 40% 的视频片段包含每帧的精确部件掩码

- 30% 包含最终帧中随机部件的多边形掩码

- 剩余片段无额外条件输入。

实验

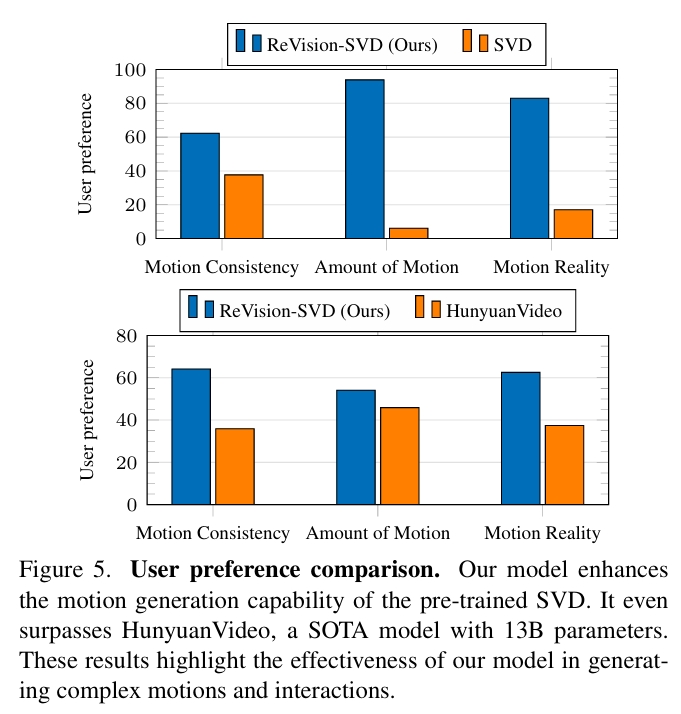

实验一:现通用生成模型对比

- SVD:使用GPT-4o生成『人类和动物从事日常活动』的文本描述。再用GPT-4o对描述生成参考图像。以此作为输入生成视频。

- HunyuanVideo:直接使用相同的文件提示生成视频。

- ReVision:使用相同的文件提示,使用HunyuanVideo生成视频的首帧作为reference,以此作为输入生成视频。

结论:

ReVision显著提升了 SVD 的运动生成能力,生成的视频在运动量、一致性和真实感上均优于 SVD。甚至在运动质量上超越了 13B 参数 的 SOTA 模型 HunyuanVideo。这些结果证明了ReVision在复杂动作和交互生成中的有效性。

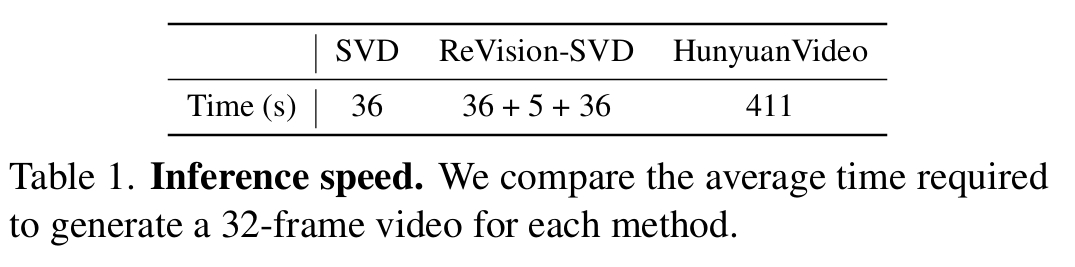

尽管 ReVision 采用了三步流程(pipeline),但额外的 3D 检测和运动优化模块在单张 A100 显卡上仅增加了 5 秒 的推理时间。因此 ReVision 仍显著更快。

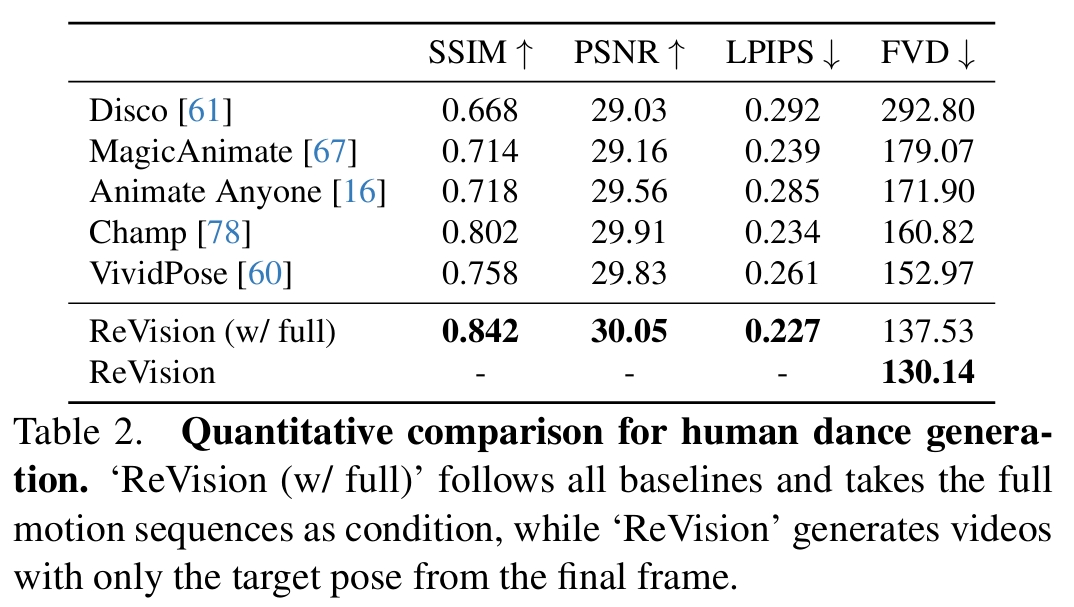

实验二:与人体图像动画化模型对比

ReVision:使用 TikTok Dancing 数据集微调原始SVD

- ReVision在所有指标上SOTA。

- FVD(Fréchet Video Distance) 指标上观察到了显著的提升,表明视频生成质量有明显改善。

- 其它基线方法都依赖于真实的运动序列(ground truth motion sequences),而在实际场景中获取这些数据是相当困难的,这限制了它们的实用性。相比之下,但ReVision需提供输入图像和目标姿态,即可生成真实且高质量的视频。

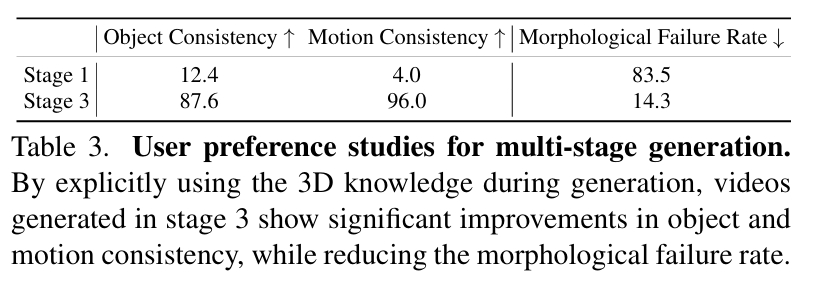

Ablation Study

- 通过引入来自 3D 网格模型的人类和动物先验知识,可以大幅缓解这些结构上的(例如“一个人有三条手臂”)不准确性,从而实现对目标更精确的表示。

- Stage3的主观效果与客观指标均明显优于Stage1

相似工作对比(原创)

FinePhys也是类似的想法,都是在3D空间优化人体动作,然后以优化后的人体动作作为控制信号进行视频生成。

区别在于

| 本文 | FinePhys | |

|---|---|---|

| 输入 | 参考图像+目标动作,因此是图生视频任务 | 视频提供参考动作,生成视频,因此是2D动作驱动的视频生成任务 |

| 物理先验的来源 | 没有显式地提取物理参数,仍然是从视频数据中学习物理先验 | 显示地使用了物理公式,通过提取物理参数再运用物理参数的过程,强制优化后的动作是物理的 |

| 适用范围 | 使用了SMPL、SMAL、bbox等不同的方法来把2D内容参数化,因此适用范围更广 | 依赖于2D关键点检测与2D->3D lifting,只能用于人的优化 |

| 结果可控性 | 从数据是自动地学习物理先验,结果更可控,但依赖高质量数据。 | 依赖物理参数的优化,如果参数没优化好,结果就不对,因此可控性差一点 |

| 控制信号 | Mesh投影的分段mask,引导效果更好 | 2D火柴人,更考验生成能力 |

相同点:

- 物理优化的过程是可导的,因为可以把物理优化作为其中一个环节进行端到端训练。

Text2Video-Zero: Text-to-Image Diffusion Models are Zero-Shot Video Generators

Use Stable Diffusion to generate videos without any finetuning

✅ 完全没有经过训练,使用 T2I Base Model(stable diffusion Model) 生成视频。

Motivation: How to use Stable Diffusion for video generation without finetuning?

- Start from noises of similar pattern

- Make intermediate features of different frames to be similar

P103

Step 1

- Start from noises of similar pattern: given the first frame’s noise, define a global scene motion, used to translate the first frame’s noise to generate similar initial noise for other frames

✅ 在 noise 上对内容进行编辑,即定义第一帧的 noise,以及后面帧的 noise 运动趋势。

P104

Step2

- Make intermediate features of different frames to be similar: always use K and V from the first frame in self-attention

✅ 保证中间帧尽量相似。

P105

Step3

- Optional background smoothing: regenerate the background, average with the first frame

✅ 扣出背景并 smooth.

Force Prompting: Video Generation Models Can Learn and Generalize Physics-based Control Signals

研究背景与问题

要解决的问题

模拟现实世界力的物理有意义交互的视频生成

现在有方法及其局限性

| 方法 | 核心技术 | 优势 | 局限性 |

|---|---|---|---|

| 振动模态建模(Davis et al., 2015) | 2D振动序列 | 适合周期性运动 | 无法处理复杂运动(如线性运动) |

| 物理求解器+生成模型(PhysGen/PhysMotion) | 3D物理引擎+视频生成器 | 高物理精度 | 依赖3D几何,泛化能力差 |

| Force Prompting | 力提示(vector fields)+合成数据 | 无需3D模型,低成本 | 复杂物理现象建模不足 |

本文方法及优势

我们探索将物理力作为视频生成的控制信号,并提出了“力提示”(force prompts),使用户能够通过局部点力(如轻触植物)和全局风力场(如风吹动织物)与图像进行交互。

- 通过利用原始预训练模型的视觉和运动先验,这些力提示能够使视频对物理控制信号做出逼真响应,且在推理过程中无需使用任何3D资产或物理模拟器。

- 作者发现,即使使用Blender生成的简单合成数据(如旗帜、球体的运动),模型仍能通过以下策略实现跨领域泛化。

- 仅需约15k合成样本(远低于传统方法的数百万级数据),单日训练即可完成(使用四张A100 GPU)。

主要贡献

- 通过两种模型将物理力作为视频生成的条件信号:一种用于局部点力(localized point forces),另一种用于全局风力(global wind forces)。

- 我们发现,视频模型即使在极少量训练数据(15k视频)和有限计算资源(四张A100 GPU一天)下,也能执行精确的力提示,并在不同场景、物体、几何形状和功能性(affordances)中表现出广泛泛化能力。我们还尝试理解这种泛化的来源,并对训练数据进行了仔细的消融实验,发现两个关键要素:与控制信号相关的视觉多样性,以及训练过程中特定文本关键词的使用,这些要素似乎有助于激发模型对力控制信号的理解。

- 我们展示了基于力条件的模型具有一定程度的质量理解能力:相同的力可以导致较轻物体移动得更远,而较重物体则移动得更近。 我们已在项目页面(https://force-prompting.github.io/)公开所有数据集、代码和模型。

主要方法

输入:

- 文本提示 τ:描述场景或动作

- 初始帧 ϕ:提供视觉上下文

- 物理控制信号 π:

- 风力模型:方向和强度

- 点力模型:方向、强度及作用点坐标

输出:

- 视频 v:f帧 × c通道 × h高度 × w宽度

合成训练数据

全局风力数据集:使用物理模拟器生成旗帜在风中飘动的视频

局部点力数据集 - 刚体:使用物理模拟器生成球体在地面上滚动的视频

局部点力数据集 - 弹性体:使用一个结合3D高斯分布和物理模拟器的模型PhysDreamer生成植物被轻触的视频

力的表示

全局力编码策略

输入:力 \( F \in [0, 1] \) 、角度 \( \theta \in [0, 360) \)

输出:\( \tilde{\pi} \in \mathbb{R}^{f \times c \times h \times w} \),其中 \( f = 49 \) 是帧数,\( c = 3 \) 是颜色通道数,\( h = 480 \) 和 \( w = 720 \) 是生成视频的高度和宽度。

编码方法:将\( \tilde{\pi} \) 的第一个通道定义为 \( -1 + 2 \cdot F \in [-1, 1]\),第二个通道为 \( \cos \theta \),第三个通道为 \( \sin \theta \)。

局部点力编码

输入:力的强度 \( F \in [0, 1] \) 、角度 \( \theta \in [0, 360) \) 、像素坐标 \( (x, y) \in {0, \dots, w-1} \times {0, \dots, h-1} \)

输出:\( \tilde{\pi} \in \mathbb{R}^{f \times c \times h \times w} \)

方法: 高斯斑点从像素位置 \( (x, y) \) 开始,并以恒定速度沿方向 \( \theta \) 移动,总位移与力 \( F \) 成仿射比例(详见附录A.3)。对于局部力,当力 \( F = 0 \) 时,高斯斑点的位移非零,因为训练数据集的约定是 \( F = 0 \) 表示微小力。

点力提示与轨迹控制的区别:高斯斑点的初始化位置为受力点,但其随后的位置只是表明这个瞬时力的大小的方向。高斯斑点的后续移动既不表示物理持续受力,也不表示物体要移动的位置。

训练

基模型

CogVideo + ControlNet

实验

- 尽管模型仅在球体滚动(线性)和植物触碰(复杂)场景上训练,我们的力提示模型在所有运动类别中均表现出强大的泛化能力。

- 仅在束缚运动(旗杆上的旗帜飘动)标签视频上训练的全局风力控制模型,仍能对空气动力学和流体运动实现泛化控制

- 在单种康乃馨数据上训练后,能够显著泛化到其他植物。虽然不能替代基于物理的模拟方法,但这种纯神经方法提供了卓越的泛化能力,并生成符合“直观物理”的响应。

Think Before You Diffuse: LLMs-Guided Physics-Aware Video Generation

研究背景与问题

要解决的问题

实现物理正确且照片级真实的视频生成。

现在有方法及其局限性

- 现有视频扩散模型在生成视觉上吸引人的视频方面表现优异。便难以直接从海量数据中学习这些复杂的物理规律。因此在生成视频中合成正确、符合物理规律的效果方面存在困难,尤其是在处理复杂的现实世界运动、物体间相互作用和动力学时。

- 通过神经网络从视觉输入中提取物理表示,用于下游的推理或模拟。尽管这些方法在图形学、机器人和科学计算等领域有效,但它们通常依赖于基于规则的手工求解器,这限制了其表达能力和可扩展性,并且需要大量的手动调整。此外,它们通常局限于合成数据,无法扩展到复杂的、真实世界的视频生成。

本文方法及优势

- 利用LLM进行物理推理,显式地分析用户提供的文本提示,并生成一个全面的物理上下文,详细描述文本提示中隐含或涉及的物理规律(如重力、碰撞、流体、材料属性等)。

- 将LLM推理出的物理上下文信息注入到扩散模型(即视频生成模型)中,指导其生成过程。

- 利用MLLM监督与训练目标

- 构建了一个新的高质量物理视频数据集,该数据集包含多样化的物理动作和事件

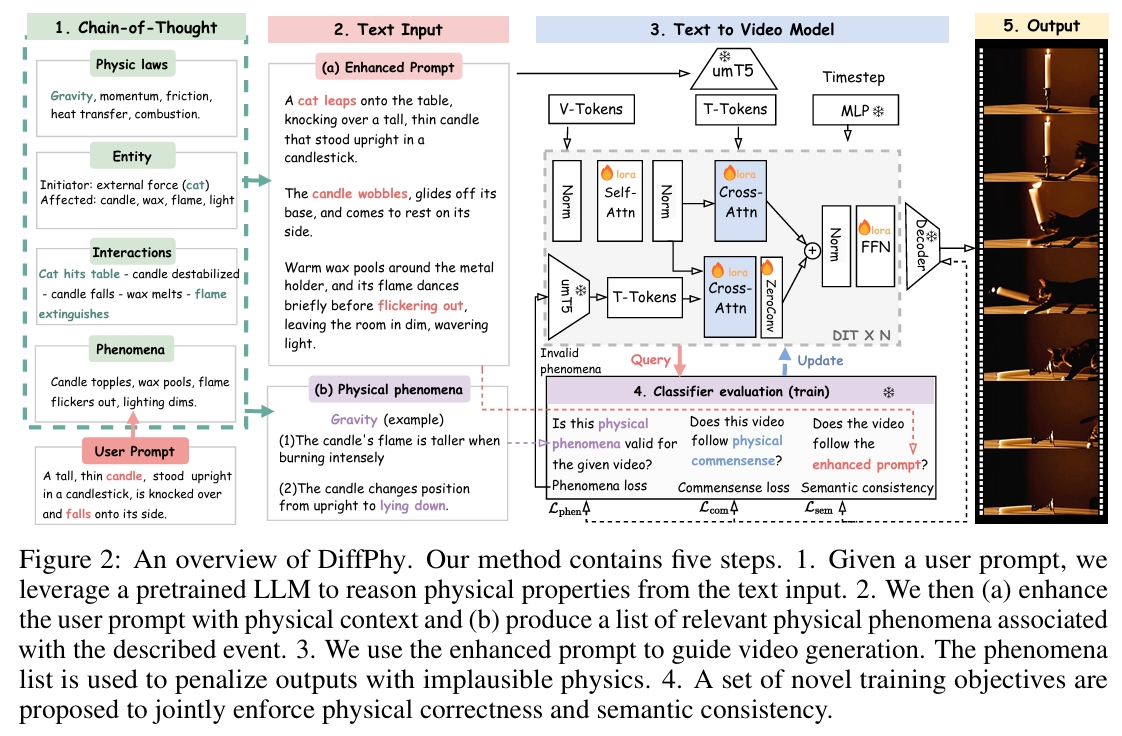

主要方法

给定用户提示:

- 利用预训练的大型语言模型 (LLM) 从文本输入中推理物理属性。

- (a) 利用物理语境增强用户提示,并 (b) 生成一个与所描述事件相关的物理现象清单。

- 使用增强后的提示来指导视频生成。同时,物理现象清单被用来惩罚包含不合理物理现象的输出。

将文本描述锚定于物理语境

利用预训练的 LLM 来推理物理语境,并获取三种类型的文本描述: (1) 一个物理属性清单,用于捕捉角色(起因/结果)、相互作用和物理规律; (2) 一个包含场景和物理细节的增强提示; (3) 一个与事件相关的物理现象清单。

物理属性推理

使用思维链 (Chain-of-Thought, CoT) [54] 提示技术来引导一个预训练的大型语言模型:

(1) 识别所涉及的关键物理原理;

(2) 确定哪些实体发起动作,哪些实体受到影响;

(3) 推理这些实体如何相互作用;

(4) 记录任何由此产生的物理现象。

最终,获得一个既全面又有效的物理属性清单。

增强文本提示

基于提取出的物理属性,提示 LLM “生动地描述场景,包括物体、动作和氛围”。不仅捕捉了场景的力学方面,还捕捉了其叙事深度。

允许 LLM 通过引入新的实体(产生外力)以保证逻辑一致性。

物理现象

生成一个与目标事件相关联的『物理现象』清单。其中『物理现象』是由事件状态变化引起的事实。

这些『物理现象』清单用于指导训练过程。当事实被满足时,可以奖励扩散模型;当事实缺失或错误时,则可以惩罚它。

物理感知模型训练

目标

如何训练扩散模型以有效利用文本描述中丰富的物理语境,并精确生成期望的物理效果:

(1)

(2) 尊重作为自然视频的常识;

(3) 生成符合文本描述的期望内容。

物理现象 Loss

验证生成的结果是否包含物理现象清单中列出的期望事实

在训练期间,在采样的时间步 t,

- 将预测的潜在片段 xt ∈ R^{m×c×h×w}解码为像素空间视频 vt。

- 用一个多模态大型语言模型 (MLLM) [7] 来逐一评估 vt 与物理现象集合 F = {f1, ..., fn} 中每个事实 fi 的对齐程度。

MLLM输出两个值:

- li ∈ {0, 1}描述第i个事实是否被匹配

- zk描述与单词k相关联的logit值。其中单词k ∈ {“未匹配”或“已匹配”}

Loss定义为:

$$ E(li) = Σ_{l∈{0,1}} $$

$$ L_{phen} = Σ_{f_i∈F} ||E(l_i) - 1||^2_2 $$

引入了一个额外模块来处理未匹配的事实 \( f_i \),该模块:

- 将 \( f_i \) 编码为文本嵌入

- 以图 2-(3) 所示的方式,对DiT中的Cross Attention层使用ControlNet + LoRA的技术向原始的DiT注入条件

物理常识 Loss

使用同一个预训练的多模态大型语言模型 (MLLM)来给出 1 到 5 的评分,用于评估生成的视频 vt 的合理性得分。

$$ L_{\text{com}} = \left| \frac{E(s_{\text{com}})}{\tau} - 1 \right|_2^2, $$

语义一致性损失

使用同一个预训练的多模态大型语言模型 (MLLM)来给出 1 到 5 的评分,用于评估生成的视频 vt 与输入文本提示之间的语义一致性。

$$ L_{\text{sem}} = \left| \frac{E(s_{\text{sem}})}{\tau} - 1 \right|_2^2, $$

训练

训练目标

- 去噪分数匹配 \( L_\epsilon \):扩散模型的核心目标,通过最小化噪声预测误差来学习数据分布。

- 现象损失 \( L_{\text{phen}} \):修正生成过程中违反物理规律的现象(例如物体穿透、重力失效)。

- 物理常识损失 \(L_{\text{com}} \):确保生成内容符合物理常识(例如物体下落、液体流动)。

- 语义一致性损失 \( L_{\text{sem}} \):保证生成内容与输入文本提示的语义一致(例如“猫跳上桌子”需包含猫和桌子)。

$$ L = L_\epsilon + \beta(L_{\text{phen}} + L_{\text{com}} + L_{\text{sem}}). $$

训练策略

- 冻结原始 DIT,仅训LoRA部分

- 当检测到失败事实,基于该事实的文本嵌入重新注入扩散步骤,强制模型修正错误。

- 随机不激活注入分支的训练,防止模型过度依赖注入的监督信号,保留原始扩散模型的生成能力。

基模型

Wan2.1-14B,一种基于 DiT 的开源文生视频模型

DiffPhy 支持多种模型架构(backbones),此处以 Wan2.1-14B 为例进行展示。

实验

数据集

训练数据:

通过对VIDGEN-1M数据集加工得到的HQ-Phy数据集

测试数据:

VideoPhy2、PhyGenBench

评估指标

PhyGenBench 基准的评估指标:

- 关键现象检测(Key Phenomena Detection):检测生成视频中是否包含符合物理规律的关键现象(如重力、弹性等)。

- 物理顺序验证(Physical Order Verification):验证事件的时间顺序是否符合物理因果关系(如“物体先下落再碎裂”)。

- 平均质量评分(Average Scores):使用 GPT-4o [1] 和开源模型(如 CLIP [43]、InternVideo2 [53]、LLaVA [32])综合评估视频整体质量。

VideoPhy2中的 VideoCon-Physics 评估器:

- 物理常识(PC, Physical Commonsense):评分范围 1-5,评估视频的物理合理性。

- 语义一致性(SA, Semantic Adherence):评分范围 1-5,衡量视频与输入提示的语义对齐程度。

人工评估

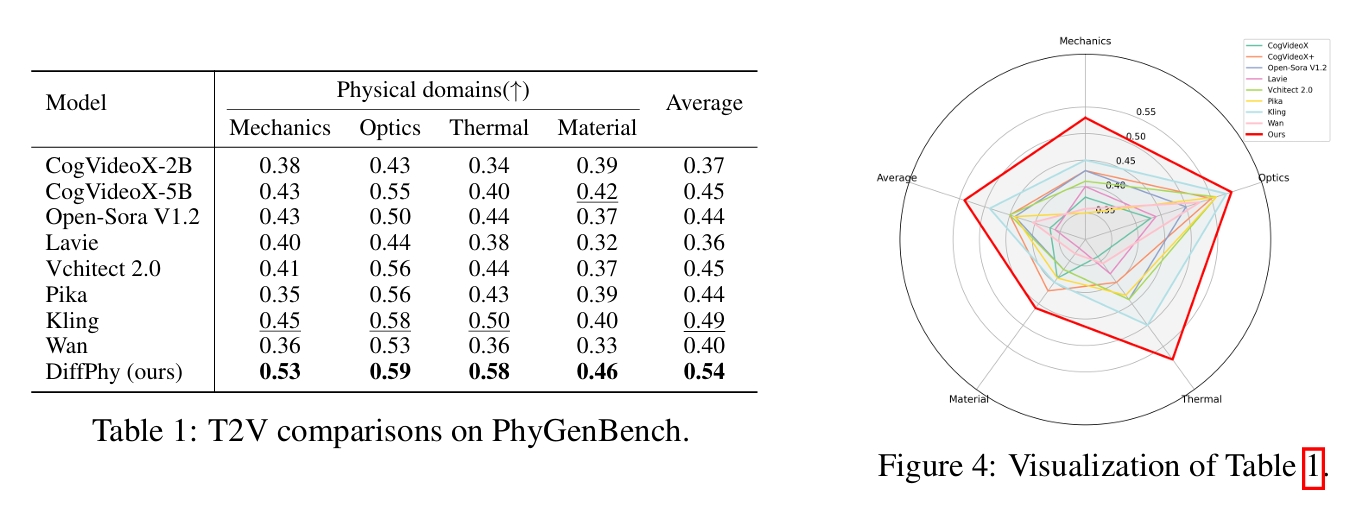

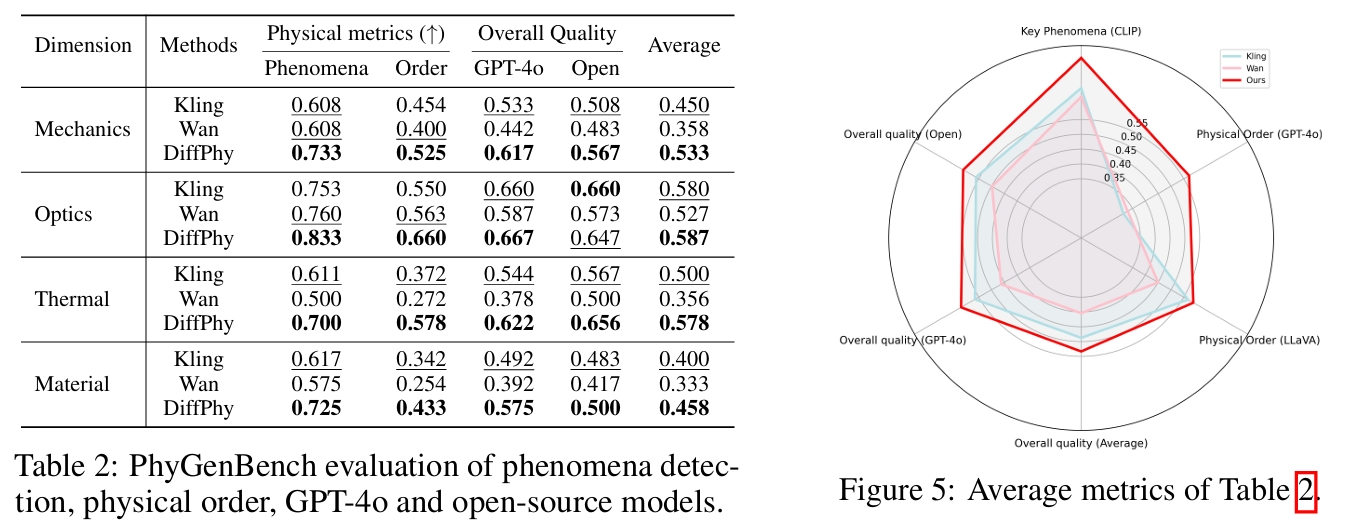

横向对比

开源模型:Wan2.1-14B [50]、CogVideoX5B [63]、VideoCrafter2 [10]、HunyuanVideo-13B [27]、Cosmos-Diffusion-7B [2]。

闭源模型:OpenAI Sora [40]、Luma Ray2 [35]、LaVie [52]、Vchitect [13]、Pika [42]、Kling [26]。

官方 PhyGenBench 排行榜:

作者自己测的客观评分:

Generating time-consistent dynamics with discriminator-guided image diffusion models

研究背景与问题

要解决的问题

基于T2I模型实现文生视频

现有方法及局限性

视频扩散模型 (VDMs) 是目前生成高质量时间动态的最佳技术。但从头训练 VDM 计算成本高昂且复杂。

本文方法及优势

不重新训练或修改现有的大型图像扩散模型(这些模型通常资源丰富且已训练好),而是利用一个额外的时间一致性判别器。该判别器在采样推理阶段(即用训练好的图像模型生成视频序列时)引导生成过程。

- 在时间一致性方面,新方法达到了与专门训练的 VDM 同等的水平。

- 新方法能更好地估计其预测的不确定性。

- 新方法生成的动态更接近真实数据,系统性误差更小。

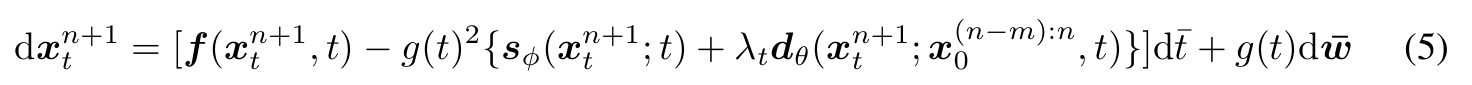

主要方法

符号定义

{x^n_t}: 表示一个图像序列。这是理解的关键。- 上标

n:物理时间步 (Physical time step)。代表视频帧或动态模拟中的时间点(n=1是第一帧,n=2是第二帧,依此类推)。 - 下标

t:扩散时间步 (Diffusion time step)。代表扩散模型去噪过程中的时间(噪声水平),t=0表示完全去噪(干净图像),t=T表示完全噪声。

- 上标

x^{(n-m):n}_0:指代从物理时间步n-m到n的无噪声 (t=0) 图像序列(m+1帧)。

时间一致性判别器的训练

构造数据对:

- 输入:

x^{(n-m):n}_0,其中n为均匀采样 - 正样本:

{x^(n+1)_t} - 负样本:

{x^(n+l)_t},其中l使用重要性采样,因此当l接近1时任务更难

输出:

D_θ(x^{n+1}_t; x^{(n-m):n}_0, t)

损失函数:

使用时间一致性判别器的时序一致性引导

根据上文可知,判别器的定义为:

由此计算出时序一致性引导为:

代码reverse SDE的更新公式得:

实验

启发

在diffusion based模型的推断过程,通过施加损失的梯度来引导生成,类似的想法在文生动作任务OmniControl中也有使用,可见这种方法确实是有效的。

GENMO:AGENeralist Model for Human MOtion

NVIDIA

研究背景与问题

要解决的问题

运动生成(如从文本生成动作)和运动估计(如从视频重建3D动作)

现有方法及局限性

视频运动估计通常关注确定性预测以追求精度,文本/音乐到运动生成则需输出多样性以覆盖可能动作,因此将运动生成和运动估计视为独立任务。

这导致模型冗余且知识无法共享。但实际上这两类任务本质均依赖对时空运动规律的理解,而技术路线分离阻碍了性能提升。

本文方法

将运动估计与生成整合至单一框架中。

- 将运动估计重新定义为受约束的运动生成,要求输出运动必须严格满足观测到的条件信号。

- 通过结合回归与扩散模型的协同效应,既能实现精准的全局运动估计,又能支持多样化运动生成。

- 一种估计引导的训练目标,利用带有2D标注和文本描述的野外视频数据来增强生成多样性。

- 支持处理可变长度运动及混合多模态条件(文本、音频、视频),在不同时间区间提供灵活控制。

这种统一方法产生了协同效益:生成先验能提升遮挡等挑战性条件下的运动估计质量,而多样视频数据则增强了生成能力。

主要贡献

-

首个通用模型:GENMO 首次统一了SOTA 全局运动估计与灵活的、多模态条件(视频、音乐、文本、2D 关键点、3D 关键帧)运动生成。

-

灵活架构设计:支持可变长度运动生成,并允许任意多模态输入组合,无需复杂后处理。

-

双模式训练范式:探索回归与扩散的协同作用,并提出估计引导的训练目标,使模型能有效利用野外视频数据。

-

双向提升:生成先验 提升遮挡等挑战条件下的估计鲁棒性;多样化视频数据 增强生成表现力。

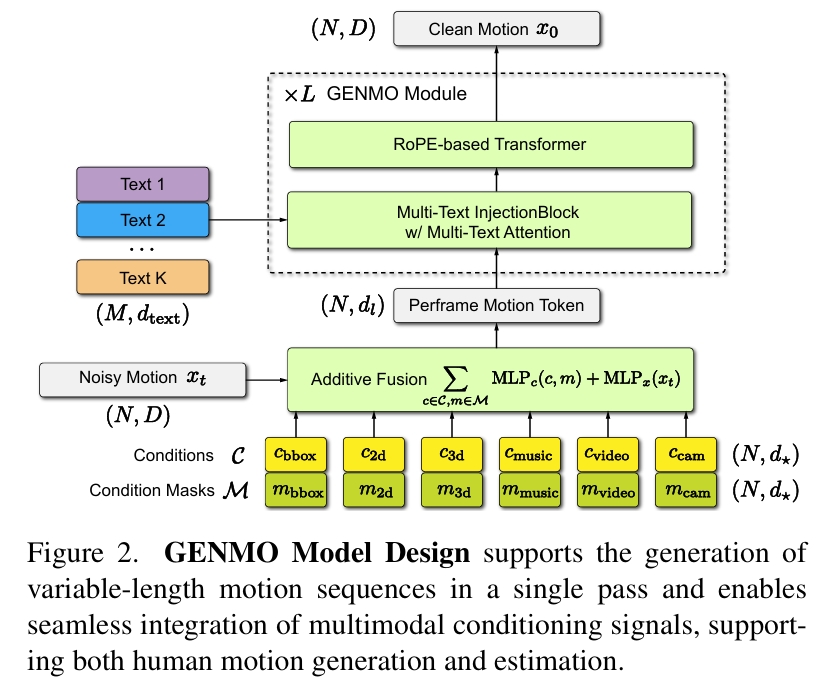

通用人体运动模型

多模态输入

- 条件信号集 \(\mathcal{C}\):包含一种或多种模态输入:

- 视频特征 \(\mathbf{c}_ {\text{video}} \in \mathbb{R}^{N \times d_{\text{video}}}\)

- 相机运动 \(\mathbf{c}_ {\text{cam}} \in \mathbb{R}^{N \times d_{\text{cam}}}\)

- 2D骨架 \(\mathbf{c}_ {\text{2d}} \in \mathbb{R}^{N \times d_{\text{2d}}}\)

- 音乐片段 \(\mathbf{c}_ {\text{music}} \in \mathbb{R}^{N \times d_{\text{music}}}\)

- 2D包围框 \(\mathbf{c}_ {\text{bbox}} \in \mathbb{R}^{N \times d_{\text{bbox}}}\)

- 自然语言描述 \(\mathbf{c}_ {\text{text}} \in \mathbb{R}^{M \times d_{\text{text}}}\)(\(M\)为文本词元数)

- 条件掩码集 \(\mathcal{M}\):为每个条件类型 \(\mathbf{c}_ {\star}\) 定义二元掩码矩阵 \(\mathbf{m}_ {\star} \in \mathbb{R}^{N \times d_ {\star}}\),当条件特征可用时掩码值为1,否则为0。

运动序列 x 的表示

- 全局轨迹(第 \(i\) 帧):

- 重力视图朝向 \(\Gamma_{i}^{\text{gv}} \in \mathbb{R}^6\)

- 局部根节点速度 \(v_{i}^{\text{root}} \in \mathbb{R}^3\)

- 局部运动(第 \(i\) 帧):

- SMPL模型参数[45]:

- 关节角 \(\theta_i \in \mathbb{R}^{24 \times 6}\)

- 身形参数 \(\beta_i \in \mathbb{R}^{10}\)

- 根节点位移 \(t_{i}^{\text{root}} \in \mathbb{R}^3\)

- SMPL模型参数[45]:

- 相机位姿(第 \(i\) 帧):

- 相机到世界的变换 \(\pi_i = (\Gamma_{i}^{\text{cv}}, t_{i}^{\text{cv}})\)

- 相机视图朝向 \(\Gamma_{i}^{\text{cv}} \in \mathbb{R}^6\)

- 相机位移 \(t_{i}^{\text{cv}} \in \mathbb{R}^3\)

- 相机到世界的变换 \(\pi_i = (\Gamma_{i}^{\text{cv}}, t_{i}^{\text{cv}})\)

- 接触标签 \(p_i \in \mathbb{R}^6\)(手足接触状态)

统一估计与生成设计

输入:带噪声的运动序列 \(x_t\) 与条件信号 \(C\)、条件掩码 \(M\)

输出:干净运动序列 \(x_0\)

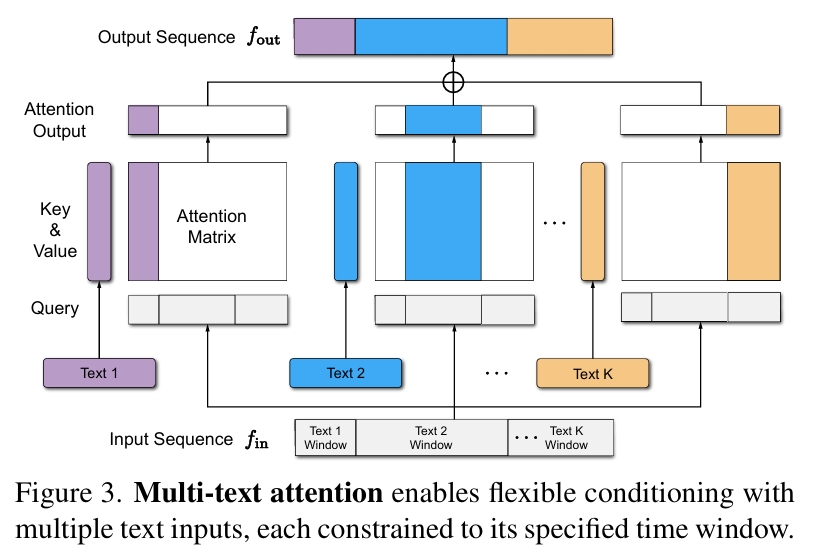

其中Multi-Text Attention为:

每一个文本序列与特定窗口的x部分做cross attention。

任意长度运动推理

在基于 RoPE 的 Transformer 块中引入滑动窗口注意力机制:每个令牌仅关注其前后 W 帧邻域内的令牌。

该设计使模型能生成远超训练时长的运动序列,同时保持计算效率并确保运动过渡平滑连贯。

混合多模态条件处理

文本条件(无帧级对齐)→ 通过多文本注意力机制处理

时序对齐模态(视频/音乐/2D骨架)→ 通过时序掩码策略管理

双模式训练范式

当前的diffusion model不足以支撑与输入视频严格一致的运动重建。

作者发现运动估计与文本生成任务存在一下差异:

- 运动估计结果变异性极低(确定性行为)。文本生成结果变异性显著(概率性行为)。

- 视频条件模型:首步预测接近最终结果,后续步变化极小。文本条件模型:各步预测方差显著。

得出结论:首步预测精度成为关键。

因此提出提出双模式训练范式。

估计模式

对纯噪声z预测时间步T下的输出x0,强制模型退化为确定性映射。

除了diffusion model本身的重建Loss意外,再增加2D/3D关节点位置的正则项约束。

生成模式

- 伪标签生成:以视频/2D骨架为条件,通过估计模式输出伪干净运动

- 噪声注入:对伪标签执行前向扩散

- 2D重投影损失:约束预测运动与真实2D关键点对齐

- 物理约束:同步施加几何损失

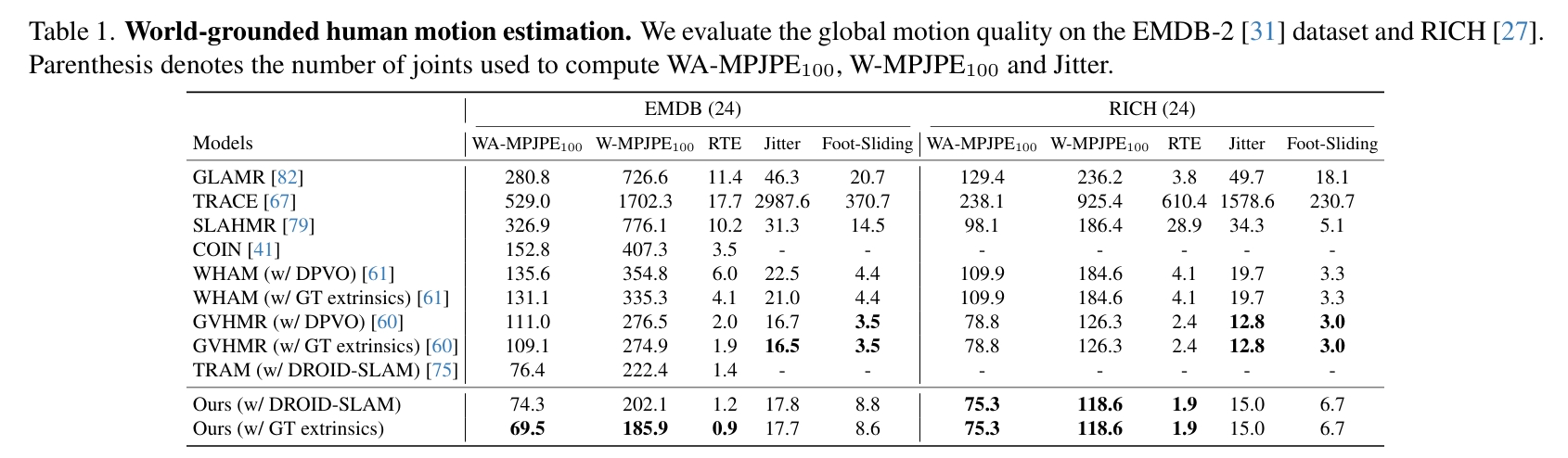

实验

动作估计

Global Motion Estimation

global motion主要关注的是滑步与轨迹。

分析:

WHAM的Motion Encoder&Decoder使用纯3D数据训练,相当于是3D动作先验模型,但这个先验模型主要是为了预测local motion。它借助SLAM结果和motion latent code共同预测轨迹,这一步需要结合视频。经测试,可能轨迹主要由motion latent code决定,因此无法区分踏步与向前走的场景。

本文根据3D动作生补全出合理的轨迹(类似WHAM)。区别在于,

- WHAM只是借助视频-3D数据来学习这个知识,而本文借助的通过大量数据的3D生成模型,因此在这方面能力更强大。

- WHAM预测轨迹的另一个输入是SLAM结果,提供的额外信息有限,而且依赖于SLAM的准确性。但本文会输入完整的视频,信息更丰富。应该可能区分踏步与向前走的场景。

WHAM和GVHMR都会显式地预测stationary并以此约束foot sliding,因此滑步问题比较小。本文只是约束了2d/3d position或速度,没有显示地预测stationary。

TRAM没有使用纯3D数据或3D动作先验模型。它完全依靠SLAM解耦相机运动和人物运动,以获得真实的人物轨迹。

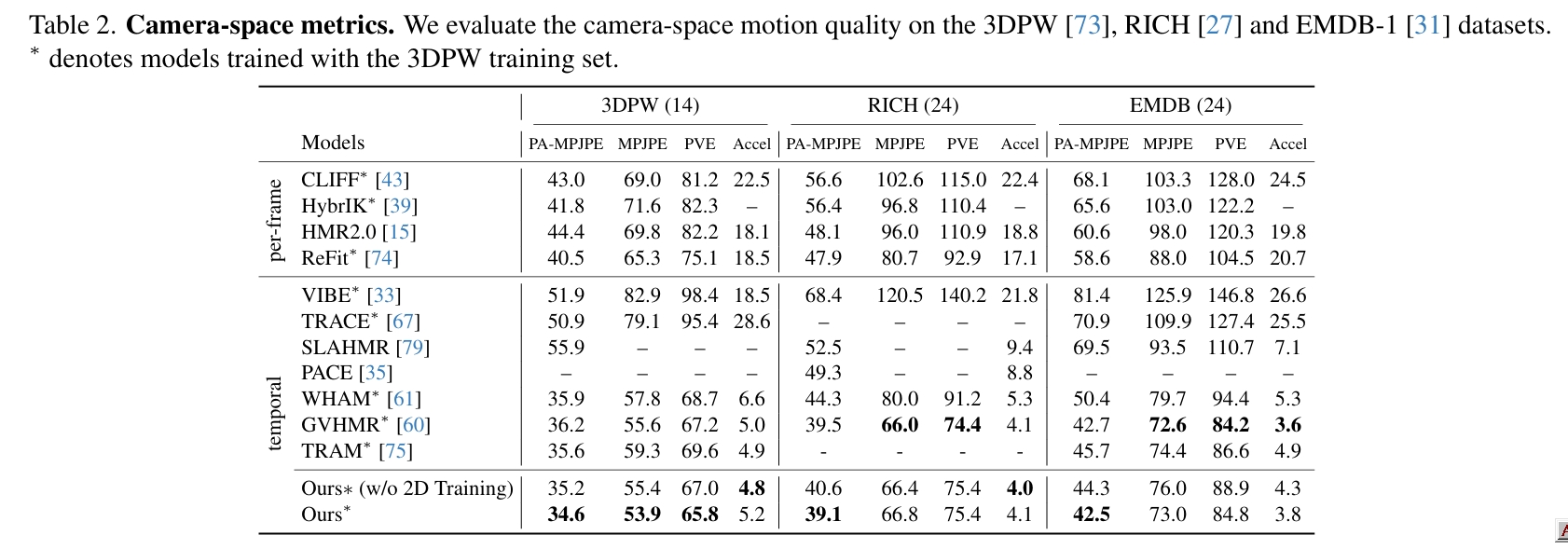

Local Motion Estimation

global motion主要关注的是动作准确度以及与视频的贴合度。

diffusion由于其泛化能力,很难约束它生成的动作跟视频完全一致,因此本文使用了双模式训练范式,从指标上看,这个训练策略非常有效。

动作生成

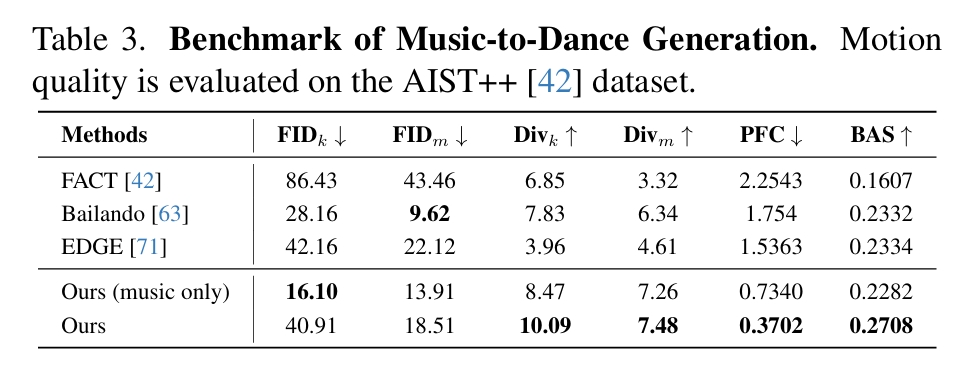

Music to Dance

| 指标 | 物理意义 |

|---|---|

| Divk | 关键帧多样性 |

| Divm | 运动序列多样性 |

| PFC | 足部接触物理合理性 |

| BAS | 节拍对齐精度 |

| FID | 分布相似性(越低越好) |

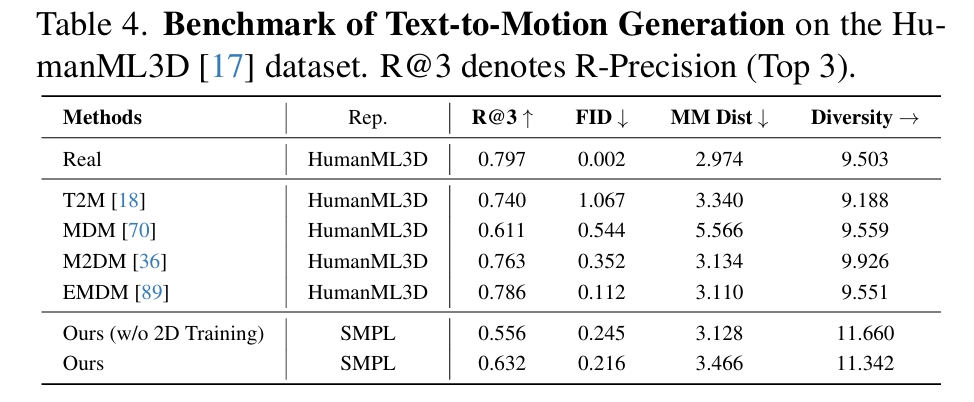

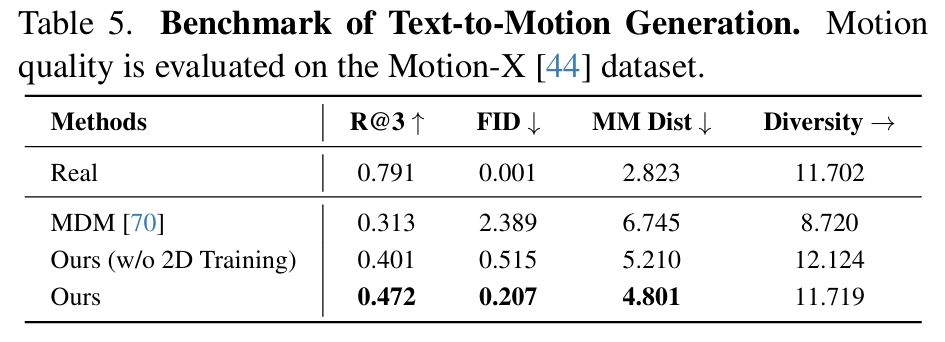

Text-to-Motion

通过Ours (w/o 2D Training)和Ours的对比,可见引入2D训练数据确实能对模型各方面性能有提升。

在表4中,GENMO的客观分数偏低,文中解释是因为本文所使用的动作表示与其它不同,在不同动作表示之间的迁移影响了结果的精度。

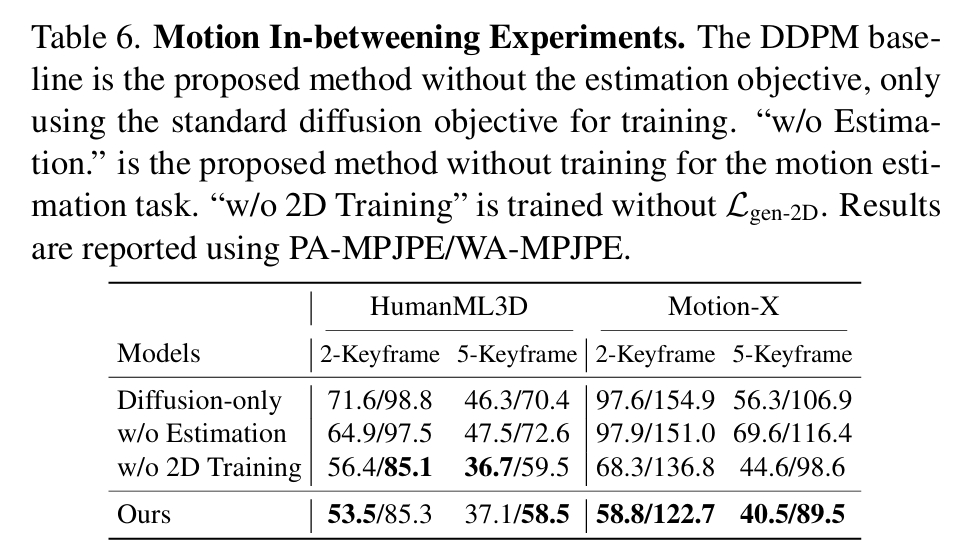

Motion In-betweening

HGM3: HIERARCHICAL GENERATIVE MASKED MOTION MODELING WITH HARD TOKEN MINING

研究背景与问题

要解决的问题

文生3D Motion

问题难点

- 文本歧义性: 相同的文本描述可能对应多种合理的动作序列(例如,“高兴地挥手”的具体幅度、速度、姿态可能有多种)。

- 动作复杂性: 人体动作涉及高维、连续、时序相关的复杂运动模式。

现有方法及局限性

-

早期方法:潜在表征对齐

- 核心思想: 试图在某个潜在空间中,让文本的表示和动作的表示尽可能接近。

- 技术手段: 使用 KL散度 (KL divergence) 或对比损失 (contrastive loss) 来最小化文本和动作潜在分布之间的距离。

- 代表工作: MotionClip, TEMOS。

- 主要局限:

- 文本和动作的本质不同(离散符号 vs. 连续时空数据)导致它们在潜在空间中的完美对齐极其困难。

- 生成的动作不自然。

-

概率映射方法:学习随机映射

- 核心思想: 认识到文本到动作的映射不是确定性的(一对一的),而是概率性的(一对多的)。因此,模型需要学习从文本条件到可能动作分布的映射。

- 技术路线一:变分自编码器 (VAE)

- **代表工作:T2M (Generating diverse and natural 3d human motions from text)

- 特点: 使用 时序 VAE,专门处理序列数据,学习文本到动作序列的映射。

- 技术路线二:扩散模型 - 当前主流之一

- 核心过程: 通过一个逐步去噪(逆向扩散)的过程,从随机噪声中生成动作序列,该过程由文本条件引导。

- 代表工作与演进:

- MDM (Tevet et al., 2023): 使用 Transformer 编码器 直接处理原始动作数据 (raw motion sequences) 进行去噪重建。

- MLD (Chen et al., 2023): 在潜在空间 (latent space) 进行扩散,显著提升计算效率 (enhance computational efficiency)。

- GraphMotion (Jin et al., 2024): 创新点在于使用分层文本条件化 (hierarchical text conditionings - 三个语义层级),试图提供更精细的控制。这为本文的分层方法 (HGM³) 提供了铺垫。

- 其他扩散模型: Kong et al. (2023), Wang et al. (2023b), Dabral et al. (2023), Zhang et al. (2024), Huang et al. (2024), Dai et al. (2025) 等,表明扩散模型是该领域非常活跃的方向。

-

掩码建模方法:掩码 Transformer - 当前主流之二

- 核心思想: 将动作序列离散化 为令牌序列(类似 NLP 中的单词)。在训练时,随机或有策略地掩码 (Mask) 一部分令牌,让模型基于上下文(未掩码令牌和文本条件)预测被掩码的令牌。

- 优势: 通常比扩散模型效率更高,能有效学习动作的时空依赖关系。

- 代表工作与技术差异:

- T2MGPT & MotionGPT: 采用 自回归 生成方式。模型像预测下一个单词一样,逐个预测动作令牌。通常使用因果掩码 (causal masking)(只能看到前面的令牌)。

- MMM: 对输入动作令牌进行随机掩码,模型基于所有未掩码令牌(上下文)同时预测所有被掩码的令牌(非自回归)。

- MoMask (Guo et al., 2024): 结合了 VQ-VAE 和 残差 Transformer。VQ-VAE 将动作编码为离散令牌,残差 Transformer 负责重建(或生成)最终的动作序列,可能涉及迭代优化(“残差”暗示了逐步修正的过程)。

- BAMM (Pinyoanuntapong et al., 2024a): 提出双向因果掩码 (Bidirectional Causal Masking)。这是对标准自回归(单向因果)的改进,试图结合双向上下文信息 的优势来补充 自回归 Transformer,可能提升生成质量和上下文理解能力。

本文方法及优势

- 困难令牌挖掘 (HTM - Hard Token Mining):

- 目标: 提升模型的学习效率(efficacy),特别是对难学部分的学习。

- 方法: 主动识别动作序列中那些对模型来说具有挑战性(“hard”)的部分,并将其掩码(mask)。

- 作用: 迫使模型在训练时更集中精力去预测和恢复这些被刻意掩盖的困难部分,类似于在训练中“专攻难点”。

- 分层生成式掩码动作模型 (HGM³ - Hierarchical Generative Masked Motion Model):

- 目标: 更好地建模文本语义与动作的对应关系,生成上下文可行的动作。

- 方法:

- 语义图表示 (Semantic Graph Representation): 使用语义图来结构化地表示输入文本句子,这种图可以捕捉词语在不同语义粒度上的关系(例如,整体动作意图 vs. 具体身体部位细节)。